IA : Alexa, porte-drapeau du silicium AWS

Amazon affirme que ses puces Inferentia supportent désormais l'essentiel des tâches de synthèse vocale d'Alexa initialement exécutées sur GPU.

La migration d'Alexa vers le silicium Amazon atteint un nouveau stade. Le groupe américain affirme avoir basculé la majorité des tâches d'inférence initialement exécutées sur GPU.

Les tâches en question relèvent de la synthèse vocale. Celle-ci s'enclenche à la fin du processus d'interaction avec l'assistant. Elle permet à ce dernier de fournir des réponses. Deux étapes d'inférence se déroulent au préalable : la transcription et la compréhension du langage naturel.

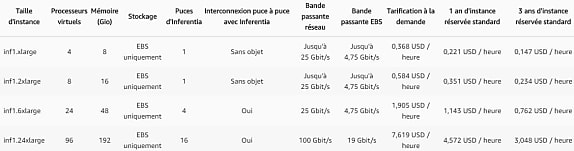

Le basculement se fait vers les instances EC2 Inf1, dotées de puces Inferentia* alliées à des Xeon Scalable 2e génération. AWS évoque une réduction de latence (25 %) et de coûts (30 %) par rapport aux instances en GPU Nvidia précédemment exploitées.

Autre service Amazon à adopter les puces Inferentia : Rekognition (reconnaissance faciale). On ne nous précise pas l'état d'avancement de la transition. Mais on nous promet des gains plus significatifs qu'avec la synthèse vocale. En l'occurrence, une latence divisée par 8 sur la catégorisation d'objets.

* Les puces Inferentia complètent, au catalogue AWS, les Graviton, fondées sur des cours Arm Neoverse 64 bits.

Illustration principale © Edelweiss - Fotolia

Sur le même thème

Voir tous les articles Cloud