Les datacenters face au défi de l'hypercroissance

Publié par La rédaction le | Mis à jour le

Futur de l'IT - Entre installations géantes et infrastructures Edge, le datacenter va devoir se réinventer pour faire face à la fuite en avant de la demande en puissance de calcul et de stockage des entreprises.

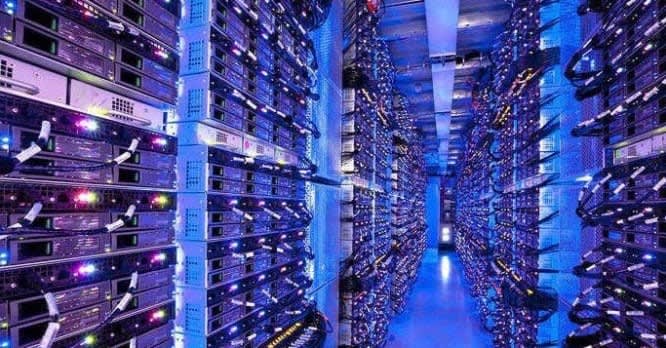

Véritables usines de l'économie numérique, les datacenters sont devenus une pièce maîtresse pour le fonctionnement des Etats et des entreprises. Néanmoins, face au tsunami des données créée par l'économie du digital. Si les serveurs et les équipements de stockage sont de plus en plus performants, la demande va beaucoup plus vite

Face à cette demande insatiable, les exploitants ont construit des datacenters de taille de plus en plus importante. On parle aujourd'hui d'hyperscalers pour évoquer cette tendance à la construction géante qui ne va pas s'arrêter de sitôt.

« Il y a 20 ans, les équipes d'Interxion bâtissaient des bâtiments de 1 000 m2 » se souvient Fabrice Coquio, président d'Interxion France depuis 1999. « Nous avons annoncé à La Courneuve le plus grand campus de datacenters qui va représenter 40 000 m2. Le facteur d'accélération est de 40 en 20 ans ! »

Michael Cohen, expert en conception de datacenters estime que la construction des grands datacenters va se poursuivre dans les prochaines décennies mais avec de nouvelles contraintes sur certaines zones géographiques choisies. « Certains lieux commencent déjà à atteindre les seuils de tolérance et de capacité d'acceptation par les populations. Amsterdam a voté un moratoire sur la construction et à Francfort, ceux-ci consomment déjà le quart de l'énergie de la ville. » affirme-t-il.

Ces contraintes risquent d'entraver l'essor des datacenters géants dans les zones urbaines. Pour l'expert, les Etats vont devoir raisonner en termes d'aménagement du territoire et redéfinir sa place dans le paysage urbain. « Le datacenter de demain sera mieux intégré aux locaux de bureau, d'habitation, sa chaleur devra être exploitée pour chauffer ces locaux et il faudra de plus en plus intégrer des notions d'économie circulaire dans les projets. »

Un impact énergétique qui pose question

Plus que jamais, les datacenters sont engagés dans une course à l'efficience énergétique (le fameux PUE pour Power Usage Effectiveness).

Le recours au « free cooling », le refroidissement par circulation naturelle de l'air, est de plus en plus fréquent et les gains enregistrés ces dernières années sont significatifs. La température de refroidissement des serveurs s'élève de plus en plus, ce qui va à l'encontre de l'idée de recycler la chaleur délivrée.

« Avant, il fallait un anorak pour rentrer dans un datacenter, aujourd'hui on souffle un air à 23/34° pour refroidir les serveurs. Nous allons encore gagner quelques degrés supplémentaires avec les serveurs et les équipements plus modernes. » détaille Michael Cohen.

La chaleur émise est désormais de l'ordre de 28 à 29° or le chauffage urbain a besoin d'une température de 70 à 80°. Hausser la température à ce niveau demandera de lourds investissements, rendant ce type d'opération économiquement peu viables.

Quand l'Edge Computing vient brouiller les cartes

Si la construction de grands datacenters va perdurer jusqu'en 2040, ceux-ci vont être rapidement rejoints par une nouvelle catégorie : les datacenters Edge.

D'une surface plus petite, ces infrastructures seront déployées au plus près des utilisateurs afin de délivrer des temps de latences très restreints, notamment pour des applications temps réels.

Michael Cohen explique ce mouvement enclenché dès la fin des années 2010: « La capillarité des datacenters va être de plus en plus fine. Il y aura de plus en plus de gros mais aussi de plus en plus de petites structures de proximité. Ce mouvement est initié par l'émergence de nouvelles technologies, dont la 5G et de nouveaux usages qui nécessiteront des temps de latence réduits. »

Les datacenters s'installent au plus près des utilisateurs, notamment dans les locaux télécoms des opérateurs ou même sous forme de conteneurs maritimes aménagés. De nombreux constructeurs sont sur les rangs et ceux-ci rivalisent afin d'intégrer un maximum de rack et leurs systèmes d'alimentation et de refroidissement dans un minimum de surface.

Sachant que la moitié de la population mondiale vit à moins de 200 km des côtes, certains opérateurs ont imaginé utiliser les océans pour y installer leurs datacenters.

C'est le cas de l'américain Nautilus Data Technologies qui propose de les installer sur des barges amarrées sur des lacs ou en nearshore proche. Son datacenter flottant utilise l'eau du lac ou l'eau de mer pour refroidir les racks de serveurs, ce qui permet, selon les concepteurs du système, d'accroître la densité des racks et des serveurs.

Des datacenters.où on ne les attend pas

Avec son projet Natick, Microsoft est allé encore plus loin en confiant à Naval Group la conception d'un datacenter sous-marin. A l'issue de 2 années d'immersion au large de l'Ecosse, le proof-of-concept a été jugé très concluant par Microsoft.

Ce qui semblait un handicap, c'est à dire l'incapacité pour les techniciens d'intervenir physiquement sur les serveurs immergés, s'est transformé en atout. Seuls huit serveurs sont tombés en panne lors des deux années de production. L'absence d'élément humain et le remplissage du submersible à l'azote expliquant cet étonnant résultat.

La start-up OrbitEdge pousse le concept encore plus loin puis qu'elle travaille sur un design de satellite baptisé SatFrame 445 LE avec l'idée d'embarquer dans son satellite non pas des calculateurs conçus pour les vols spatiaux, mais bien des serveurs standards, des serveurs de type HPE Edgeline Converged Edge Systems.

L'histoire pourrait paraitre anecdotique mais quand on sait qu'Amazon Web Services est en train de construire les stations au sol de sa future constellation de satellites. le géant du Cloud pourrait bien être tenté d'embarquer un peu puissance de calcul dans ses satellites si le marché du Edge dans l'espace se matérialise vraiment !

par Alain Clapaud