Qu'est-ce que le projet EuroLLM, qui a publié son premier modèle ?

EuroLLM arrive à mi-parcours. Comment s'inscrit-il dans le paysage des projets financés par le programme Horizon Europe ?

Lors de l'entraînement de modèles multilingues, quelle importance accorder aux données dites parallèles (associant un élément et sa traduction) ?

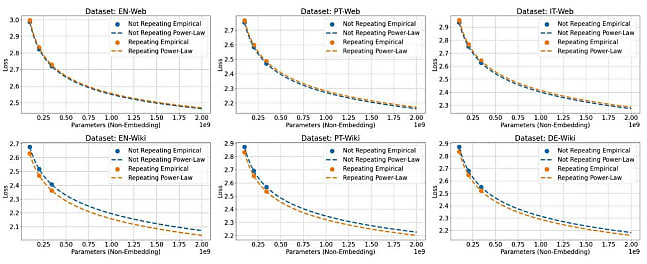

Un article scientifique publié fin septembre propose une réponse fondée sur une loi de puissance appliquée - dans les grandes lignes - au nombre de paramètres ne contenant pas de représentations vectorielles.

Ledit article rend compte du développement d'un modèle et de sa version Instruct dans le cadre du projet EuroLLM.

EuroLLM et UTTER, l'un dans l'autre

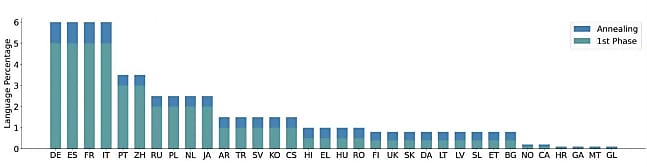

EuroLLM doit s'échelonner du 1er mai 2024 au 30 avril 2025. Il est censé en résulter des LLM d'échelle 1B, 9B et 22B pouvant traiter et produire du texte dans les 24 langues officielles de l'UE, ainsi qu'une dizaine d'autres (arabe, catalan, chinois, coréen, galicien, hindi, japonais, norvégien, russe, turc, ukrainien).

EuroLLM implique officiellement 9 entités. Dans l'ordre alphabétique :

- Aveni (entreprise privée écossaise à l'origine d'une plate-forme de traitement IA des enregistrements audio sous l'angle conformité)

- CentraleSupélec

- L'Instituto Superior Técnico (école d'ingés à Lisbonne)

- L'Instituto de Sistemas e Robótica (également basé à Lisbonne)

- Instituto de Telecomunicações (groupement portugais réunissant des universités, un institut polytechnique, un équipementier télécoms et un opérateur télécoms public)

- NAVER LABS (filiale R&D de l'entreprise sud-coréenne NAVER)

- Unbabel (entreprise privée portugaise fournissant des services de traduction)

- L'université d'Amsterdam

- L'université d'Édimbourg

La forte représentation du Portugal traduit le soutien financier que le pays a apporté dans le cadre de son plan de relance. Une partie de l'enveloppe du projet DECOLLAGE (DEep COgnition Learning for LAnguage GEneration, que portent Unlabel et Instituto de Telecomunicações) a par ailleurs été fléchée vers EuroLLM. Lequel bénéficie aussi des fonds du programme Horizon Europe à travers son projet de tutelle : UTTER (Unified Transcription and Translation for Extended Reality).

L'université d'Amsterdam chapeaute cette initiative à 4 M€ dont sont aussi parties prenantes, entre autres, son homologue d'Édimbourg, NAVER LABS et Unbabel. Objectif, sur le papier : développer, en trois ans (fin le 30 septembre 2025) et avec une quinzaine d'ETP, la "prochaine génération de technologies XR multimodales [capables de gérer texte et voix, NDLR]". Dans la pratique, les premiers livrables prototypes consistent en des assistants combinant transcription et traduction pour les réunions et le support client.

HPLT, autre initiative liée à EuroLLM

EuroLLM a aussi des liens avec Tower LLM. Sous cette bannière, quatre de ses membres (dont CentraleSupélec) ont proposé une recette pour adapter des LLM aux multiples tâches dont se composent les workflows de traduction.

Des liens, il en existe également avec HPLT (High Performance Language Technologies). Cet autre projet Horizon Europe, d'une durée de 3 ans, fédère essentiellement la sphère académique. Sa principale visée : collecter et préparer de grands volumes de données pour la formation de modèles de langage en Europe. Il travaille notamment sur des contenus issus des bases Common Crawl (5 Po) et Internet Archive (7 Po). Il s'agira aussi de former "des centaines, voire des milliers" de modèles.

Comment EuroLLM a produit son premier modèle

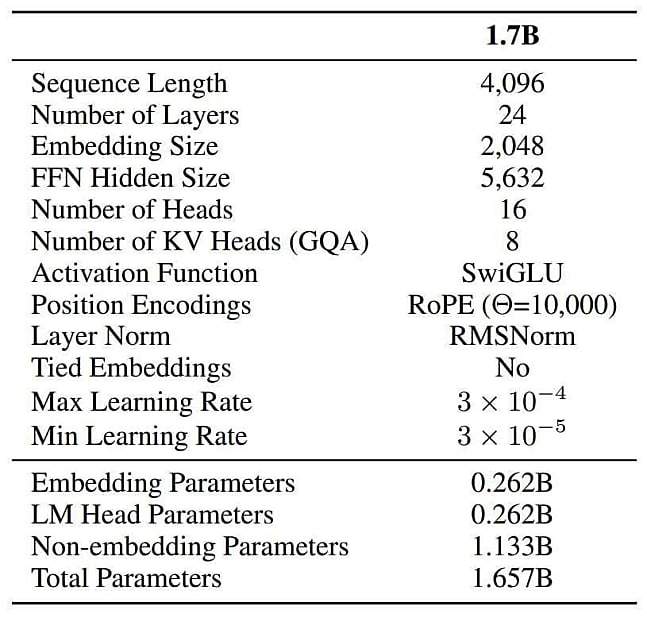

Les premiers fruits d'EuroLLM sont un transformeur 1.7B et sa version Instruct, publiés sous licence Apache 2.0.

Une multitude de sources de données ont été mises à contribution pour l'entraînement :

- Données issues du web

Pour l'anglais, extraction d'éléments du dataset FineWeb-edu.

Pour l'allemand, l'espagnol, le français et l'italien,extraction depuis RedPajama-Data-v2.

Pour les autres langues, utilisation de HPLT, MADLAD-400, CulturaX et mC4. - Données parallèles

Exploitation de "diverses sources publiques". Anglais systématiquement en langue de départ ou d'arrivée. - Code et mathématiques

Collecte depuis The Stack, AlgebraicStack et Open-web-math. - Données "haute qualité"

Pour toutes les langues, Wikipédia. Pour l'anglais, arXiv, Books et Apollo.

L'entraînement s'est fait sur 4000 milliards de tokens, par lots d'environ 12 millions, à l'appui de 256 GPU NVIDIA H100 sur le supercalculateur Marenostrum 5 d'EuroHPC. Sur la fin du processus (les 10 derniers %), EuroLLM a augmenté la proportion de données de haute qualité et en a ajouté pour l'occasion. Ses sources :

- Cosmopedia-v2 (données synthétiques générées par Mixtral-8x7B-Instruct-v0.1)

- Python-Edu (sous-ensemble de The Stack)

- GSM8K et MATH

- Europarl et ParaDocs pour la collecte de données parallèles

Les données parallèles ont représenté 20 % du corpus final. EuroLLM a testé jusqu'à 37,5 %, mais une telle proportion dégradait les performances. Au contraire, la répétition des données de haute qualité a eu tendance à améliorer le modèle.

Sur l'essentiel de la phase d'entraînement (les 90 premiers %), l'anglais a représenté 50 % du dataset. Le code et les maths, 5 %. Le reste fut réparti entre les autres langues en fonction de la quantité de données obtenues. Sur la fin du processus, la part de l'anglais fut réduite à 32,5 % et celle des données de code/maths, portée à 7 %.

Pour former le modèle au suivi d'instructions, EuroLLM a pratiqué l'apprentissage supervisé sur un dataset maison associant données publiques et données synthétiques. Sources : OpenHermes-2.5 et Aya, ainsi que des traductions machine (NTREX-128, FLORES-200-DEV, WMT-21, WMT-22).

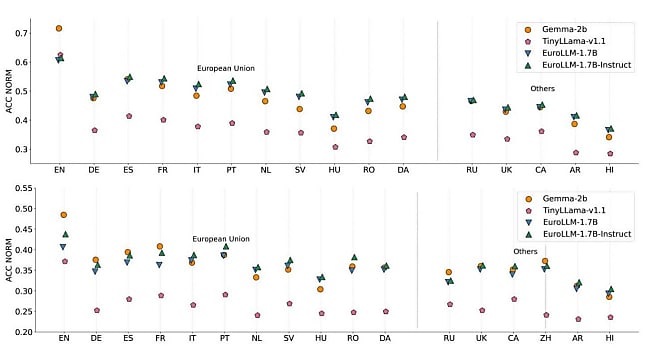

Sur les quelques benchmarks pour lesquels il publie des résultats (Hellaswag et Arc Challenge notamment), EuroLLM compare les performances de son modèle à celles de Gemma (2B et 7B) et TinyLlama.

Illustration principale © Eisenhans - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA

![Databricks viserait Neon : vers une autre acquisition OLTP [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/5/477655/databricks-viserait-neon-autre-acquisition-oltp-L.jpg)