Google muscle sa puce TPU dédiée au Machine Learning

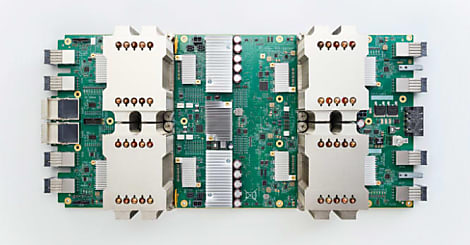

Google a présenté la seconde génération de sa puce TPU (Tensor Processor Unit) dédiée au Machine Learning et distribuée via Compute Engine.

L'intelligence artificielle ne nécessite pas uniquement des développements d'algorithmes, elle suppose aussi des ressources informatiques performantes. Pour cela, Google a élaboré sa propre puce nommée TPU (Tensor Processor Unit) et l'a intégrée dans son infrastructure depuis 2015. C'est seulement en 2017 que la société a dévoilé quelques éléments techniques sur ce composant.

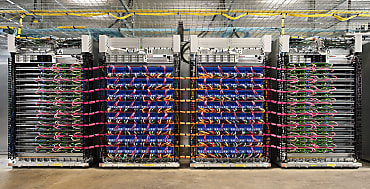

A l'occasion de la conférence Google I/O, la société a annoncé la deuxième génération de TPU, rebaptisée pour l'occasion Cloud TPU. Elle peut offrir des performances allant jusqu'à 180 Tflops en virgule flottante, en packageant 4 TPU capables de traiter 45 Tflops chacune. Dans un billet de blog, Jeff Dean, chercheur senior, et Urs Hölzle, vice-président de l'activité infrastructures Cloud chez Google, expliquent que « chaque TPU intègre une connectivité réseau haut débit permettant de construire des supercalculateurs dédiés au Machine Learning, appelés Pod TPU ». Ils ajoutent : « ce module intègre 64 TPU de seconde génération et peut traiter jusqu'à 11,53 Petaflops pour entraîner les modèles d'apprentissage automatique ».

Réduire le temps d'entraînement de l'IA

Cette course à la performance réduit le temps d'entraînement de l'IA, selon Mountain View. « Un de nos modèles de traduction à grande échelle prenait une journée pour s'aguerrir en monopolisant la puissance de 32 des meilleurs GPU du commerce. Maintenant, la formation se déroule avec la même précision, mais en une après-midi et en utilisant seulement un huitième du Pod TPU », peut-on lire sur le blog.

Les analystes sont restés un peu sur leur faim concernant les détails techniques de ces composants de seconde génération. Nos confrères de Top500 s'interrogent par exemple sur la nature des composants annoncés : 8, 16 ou 32 bits ? La première génération de TPU embarquait une puce 8 bits, pour des performances atteignant 92 Tflops. Le Cloud TPU devrait gérer des opérations 16 et 32 bits, estiment les journalistes de Top500, car ce processeur est conçu pour la formation de l'IA et nécessite donc des calculs plus complexes.

1000 Cloud TPU offerts aux chercheurs en IA

Cette annonce de Cloud TPU intervient au moment où Nvidia dévoile sa puce Tesla V100. Cette dernière affiche 5120 coeurs Cuda cadencés en pointe à 1455 MHz et capables de délivrer une puissance de calcul de 7,5 téraflops en double précision (15 téraflops en simple précision). Pour prendre en charge au mieux les applications de Deep Learning, 640 Tensor Cores sont intégrés par Nvidia. Ils permettent d'effectuer un très grand nombre de calculs, 120 téraflops (en 16 et 32 bits).

Pour conclure, Google a annoncé qu'il proposerait les performances de Cloud TPU dans le cadre de son offre Compute Engine. Pour susciter l'intérêt des utilisateurs, la firme de Mountain View met gratuitement 1000 TPU à disposition des chercheurs en Machine Learning.

A lire aussi :

Lire aussi : PC Copilot+, eldorado de l' IA locale ?

Sur le même thème

Voir tous les articles Cloud