LLM généraliste ou spécialisé ? La question sous l'angle environnemental

Une étude compare la performance environnementale entre modèles généralistes et modèles spécialisés. En voici les conclusions.

Dans des contextes où les tâches sont bien définies, est-il vraiment nécessaire de recourir à des LLM généralistes plutôt qu'à des modèles spécialisés ?

Des chercheurs de Hugging Face et de l'Institut Allen ont mis le problème en chiffres sous l'angle environnemental. Leur étude se concentre sur la phase d'inférence. Au-delà de la comparaison généraliste-spécialisé, elle aborde, entre autres, l'influence de certains choix d'architecture et l'« empreinte carbone » de la multimodalité.

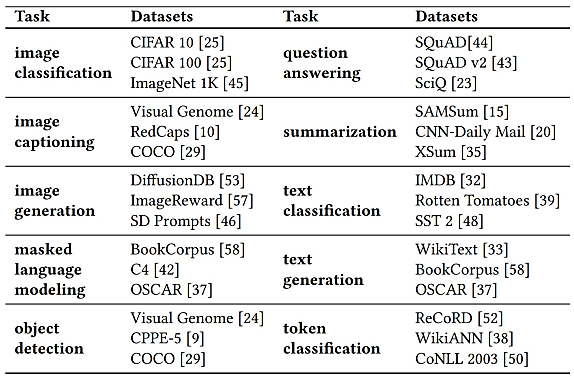

Les travaux ont englobé 88 modèles, mis à l'épreuve sur 10 tâches couvrant 30 datasets. Le coeur de la démonstration porte sur un sous-ensemble de 16 modèles (8 généralistes, 8 spécialisés).

Les tâches en question sont de cinq types :

- Text-to-category (classification de texte, classification de token, questions-réponses)

- Text-to-text (complétion, génération et résumé de texte)

- Image-to-category (classification d'images, détection d'objets)

- Image-to-text (légendage d'images)

- Text-to-image (génération d'images)

Pour chaque tâche, on a sélectionné trois datasets populaires. Les modèles expérimentés ont tous eu à réaliser 10 cycles de 1000 inférences sur chacun de ces datasets, avec la bibliothèque Transformers.

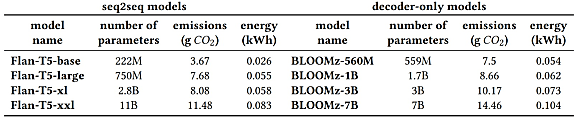

Dans la catégorie des généralistes, les chercheurs ont retenu quatre modèles seq2seq (Flan-T5 base, large, xl, xxl) et autant de décodeurs de la famille BLOOMz (versions 560M, 1B, 3B, 7B). Ils les ont soumis à trois tâches : questions-réponses, classification de texte et résumé.

L'ensemble des tests se sont déroulés sur une même base hardware : un GPU A100-SX4M-80 chez AWS. Code Carbon a permis de mesurer la consommation d'énergie et les émissions carbone... corrélées, puisque toute l'expérimentation s'est faite dans la même région cloud AWS.

Les modèles spécialisés...

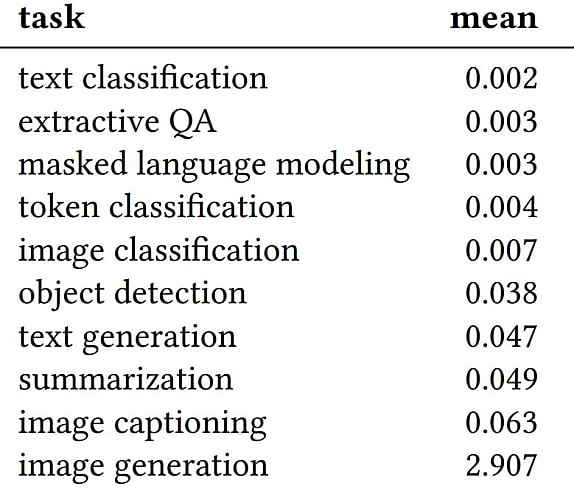

Avec les modèles spécialisés, les tâches de classification (image et texte) sont les moins coûteuses : entre 0,002 et 0,007 kWh pour 1000 inférences.

La génération et le résumé de texte consomment en moyenne 10 fois plus d'énergie (environ 0,05 kWh).

Les tâches multimodales (légender et générer des images), de 0,06 à 0,29 kWh.

La consommation médiane de la génération de texte est quasiment 20 fois plus importante que pour la classification (0,042 kWh vs 0,0023 kWh).

Pour les images, le rapport est de près de 200 (1,35 kWh vs 0,0068 kWh).

D'après les données de l'Agence de protection de l'environnement des États-Unis, recharger un smartphone nécessite en moyenne 0,012 kWh. Le moins efficace des modèles testés consomme presque autant pour générer une seule image.

De manière générale, l'écart entre le plus et le moins gourmand des modèles (respectivement stable-diffusion-xl-base-1.0 et distilbert-base-uncased) est d'un facteur 6833. Pas illogique, considèrent les chercheurs, vu l'étendue très variable du champ de décision entre un modèle d'analyse de sentiment répondant « positif » ou « négatif » et un générateur d'images qui, de surcroît, travaille à l'échelle du pixel et non du token.

La structure de la tâche a davantage d'impact que la taille du modèle. Ainsi, sur les plus petits (autour de 500 millions de paramètres), l'écart demeure en les tâches text-to-category (0,6 g d'équivalent CO2 pour 1000 inférences) et la génération d'images (100 g).

En termes d'impact, les générateurs de texte - résumé compris - ont tendance à se rapprocher des générateurs d'images.

... face aux modèles généralistes

Sur l'analyse de sentiments (datasets SST 2, Rotten Tomatoes et IMDB), les modèles spécialisés émettent moins que les généralistes, peu importe l'architecture de ces derniers. Même chose sur les questions-réponses (SciQ, SQuAD et SQuAD v2).

Les modèles spécialisés les plus efficaces émettent 0,3 g CO2e pour 1000 inférences le QA sur SciQ. Sur cette même tâche, les généralistes émettent autour de 10 g.

L'écart est moins important sur les tâches génératives. Illustration pour le résumé (SAMsum, XSum, CNN-Daily Mail). Les spécialistes seq2seq sont entre 4 et 10 g. Les généralistes, enttre 20 et 30. Vu les modèles sélectionnés, la différence s'est plutôt faite sur leur taille.

Les modèles les plus coûteux ont-ils de meilleures performances ? L'étude touche à cette question, à l'appui de deux bibliothèques : lm-evaluation-harness (pour les généralistes) et evaluate (pour les spécialisés). À prompts équivalents, on constate des variations plus sensibles chez les petits modèles encodeurs spécialisés. Les modèles généralistes ont une précision globalement plus importante... mais une consommation d'un autre ordre.

Chez les généralistes, à taille égale, les seq2seq se révèlent, surtout sur le résumé, plus efficaces que les décodeurs. Ceux-ci présentent par ailleurs une plus grande plage de conosmmation en fonction des tâches.

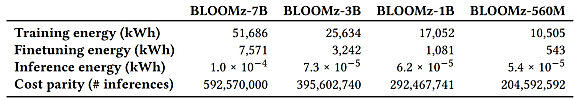

Il existe des données environnementales pour le modèle de fondation sous-jacent à BLOOMz. Couplées aux informations relatives au développement de ce dernier, elles permettent d'estimer en combien de temps la conso sur la phase d'inférence aura dépassé celle de la phase d'entraînement. L'écart peut sembler important... sauf si on prend en compte l'ensemble des instances exécutées. Les modèles BLOOMz pris en considération cumulent, en l'occurrence, plus d'un million de téléchargements sur Hugging Face.

Les principales conclusions

Les tâches génératives sont globalement les plus consommatrices.

Celles impliquant des images consomment plus que celles impliquant du texte.

Sur une même tâche et à taille comparable, les décodeurs consomment un peu plus que les seq2seq. C'est particulièrement vrai pour les modèles qui produisent de longs résultats.

L'entraînement reste bien plus gourmand, mais l'inférence peut atteindre la même empreinte environnementale en quelques semaines.

Sur une même tâche et à taille comparable, les modèles généralistes consomment plus que les spécialisés. En particulier, pour la classification de texte et les questions-réponses. Moins pour le résumé.

Ce dernier constat a son importance vu la tendance actuelle à basculer des modèles spécialisés aux modèles généralistes. Par exemple, BERT remplacé par du GPT-4 ou du PaLM pour des services de type recherche web.

D'après les mesures effectuées, un modèle BERT spécialisé Q&A (bert-large-uncased-whole-word-masking-finetuned-squad) émet 0,70 g CO2e pour 1000 inférences. Contre trois fois plus pour Flan-T5 base (2,36 g) et BLOOMz-560M (2,34 g).

Illustration principale © tookitook - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA