Machine learning : vers une classification dédiée des menaces de sécurité

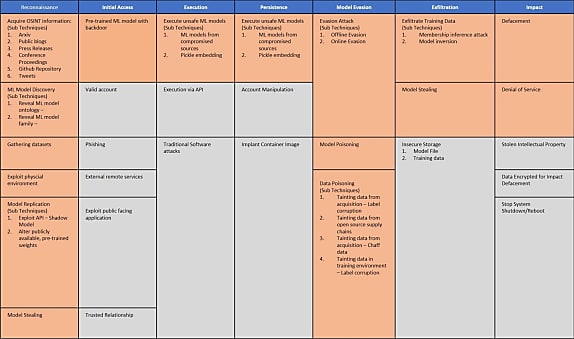

Dans la lignée de son framework ATT@CK, MITRE porte le projet open source Adversarial ML Threat Matrix, destiné à classer les menaces contre les systèmes de machine learning.

Catégoriser les menaces contre les systèmes de machine learning : c'est l'objectif du projet open source Adversarial ML Threat Matrix.

L'organisation américaine MITRE, connue notamment pour maintenir le dictionnaire de vulnérabilités de sécurité CVE, supervise la démarche. Airbus, Bosch, IBM, Microsoft, NVIDIA et PwC sont les principales entreprises à s'y être jointes.

L'initiative s'inspire du framework ATT&CK, qui fait office de base de connaissances sur les menaces contre les logiciels. Elle en reprend la structure et la terminologie. Avec toutefois quelques différences. Notamment un code couleur qui distingue les techniques spécifiques aux modèles d'IA (en orange).

Lire aussi : Benchmarks d'IA : quelle confiance leur accorder ?

La matrice s'accompagne de « cas d'étude » sur des systèmes de production. Entre autres :

- Sur la partie traitement du langage naturel, le modèle GPT-2 d'OpenAI, reproduit à partir d'un autre modèle (Grover) et de jeux de données publics

- Dans le domaine de la reconnaissance faciale, le détournement de l'IA de ClearView par accès aux données d'entraînement

- Le contournement du modèle de machine learning qui porte l'offre de protection des messageries électroniques de Proofpoint

Toute démonstration d'une attaque qui affecte l'intégralité, la confidentialité ou la disponibilité des systèmes de machine learning est susceptible de rejoindre cette liste.

En la matière, on se souviendra de l'IA Inception de Google pour la reconnaissance d'images, trompée par la rotation d'objets. Ou encore du pilote automatique de Tesla, perturbé en conditions réelles dans l'identification du marquage au sol par la présence de morceaux d'adhésif blanc sur la chaussée.

Illustration principale © zapp2photo - Fotolia

Sur le même thème

Voir tous les articles Data & IA