L'offre commerciale de Mistral AI en cinq points

Mistral AI a lancé ses premiers modèles commerciaux. Quels sont-ils, où y accéder, dans quelles conditions et à quel prix ?

Vous utilisez l'API Mistral ? Prenez note : les points de terminaison ont changé. La conséquence de l'introduction de modèles commerciaux.

Quels sont ces modèles ?

Appelez-les Mistral Small et Mistral Large. Le premier convient aux « tâches simples qu'on peut effectuer en volume, tels la classification, le support client et la génération de texte ». Le second est « idéal pour des tâches complexes nécessitant de grandes capacités de raisonnement ou une grande spécialisation, comme la génération de texte synthétique, la génération de code, le RAG [fenêtre de contexte : 32k, NDLR] ou les agents ».

Le prototype Mistral Medium reste accessible, mais ne fait pas l'objet d'une mise à jour. Il se destine aux « tâches intermédiaires nécessitant un raisonnement modéré », à l'image de l'extraction de données, de la synthèse de document ou de la rédaction d'une description de produit.

Lire aussi : Mistral AI ouvre la porte aux LLM embarqués

Quelles en sont les performances ?

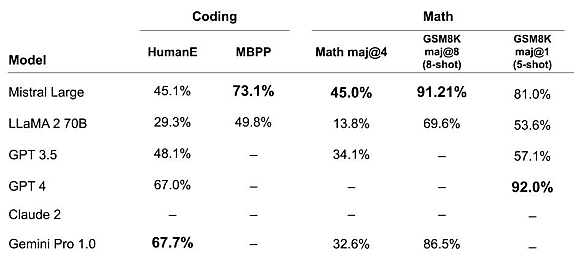

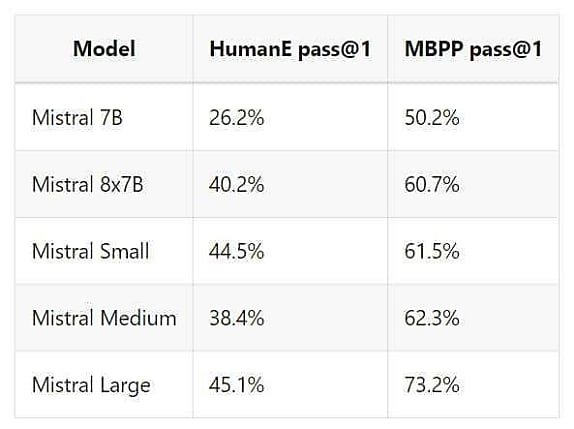

À défaut de communiquer beaucoup d'éléments sur les modèles en eux-mêmes, Mistral AI communique divers benchmarks.

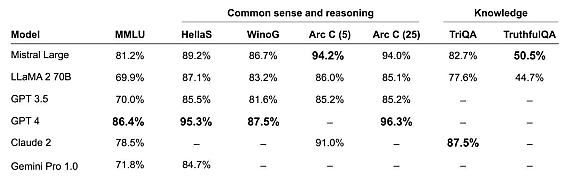

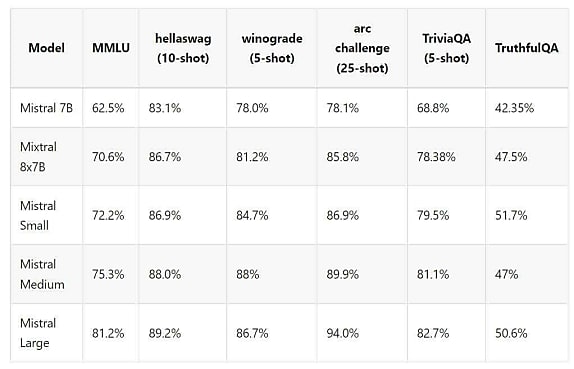

Raisonnement/bon sens et connaissances :

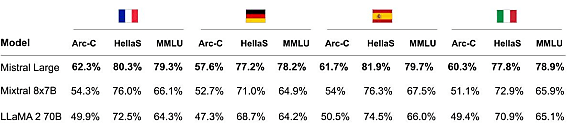

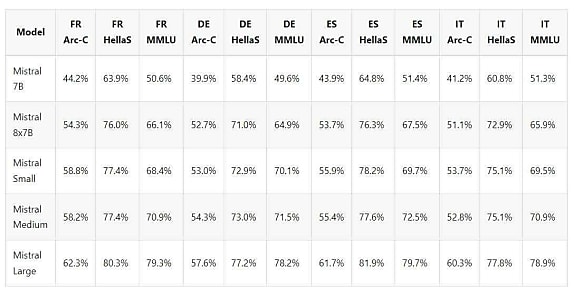

Capacités multilingues :

Lire aussi : Un niveau gratuit sur l'API Mistral AI

Mathématiques et codage :

Où y accéder ?

Mistral propose d'accéder à ces deux modèles par l'intermédiaire de son API, qui repose sur des infrastructures hébergées en Europe. Les points de terminaison : mistral-small-latest et mistral-large-latest.

Autre option : l'hébergement chez Microsoft. Mistral Large est accessible dans le catalogue de modèles d'Azure AI. On peut l'exploiter dans les environnements Azure AI Studio (axé développeurs) et Azure ML Studio (data scientists). Il rejoint Mistral 7B et Mistral 8x7B, disponibles - ainsi que leurs versions Instruct - depuis décembre 2023.

L'accès est également possible à travers l'assistant « Le Chat » que Mistral AI vient de lancer en bêta. Celui-ci permet aussi d'interagir avec le modèle prototype Mistral Next, récemment officialisé.

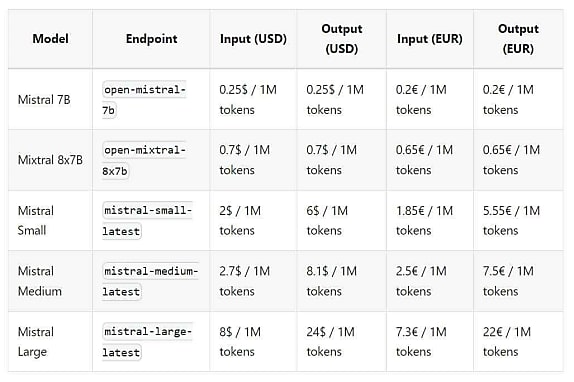

À quel prix ?

Sur l'API Mistral, les tarifs sont les suivants :

Cette tarification s'accompagne de limites d'usage :

Lire aussi : Mistral AI muscle le Chat avec l'AFP

- 2 requêtes par seconde

- 2 millions de tokens par minute

- 200 millions de tokens par mois

Sur Azure, il en coûte 0,024 $ pour 1000 tokens en entrée et 0,008 $ pour 1000 tokens en sortie. Les quotas par défaut sont à 200 000 tokens/minute et 1000 requêtes/minute.

Mistral AI sur Azure : ce qu'il faut savoir

Microsoft propose deux emplacements pour héberger les modèles : les régions Azure « Est des États-Unis » et « France Centre ».

Les API Azure sont compatible avec le schéma Mistral AI, et donc avec ses bibliothèques clientes.

Mistral Large ne nécessite pas de gestion d'infrastructure, au contraire des modèles ouverts, qui se déploient sur des VM.

Facturation par l'intermédiaire de la marketplace, avec possibilité de piocher dans d'éventuels MACC (engagements de consommation).

Pas encore de prise en charge de l'appel de fonction native, ni de la sortie JSON. Deux capacités accessibles sur l'API Mistral. Pas non plus, pour le moment, de possibilité d'ajuster le modèle (finetuning).

Mistral Large peut bénéficier des filtres de contenu de Microsoft en plus des siens, activables dans l'invite système avec le paramètre safe_prompt.

Illustration ©

Sur le même thème

Voir tous les articles Data & IA