L'AMD Opteron 6200 flexibilise le cloud

A l'occasion du lancement de l'Opteron 6200, AMD réunissait un parterre de partenaires pour débattre du cloud. Un débat suivi par Silicon.fr

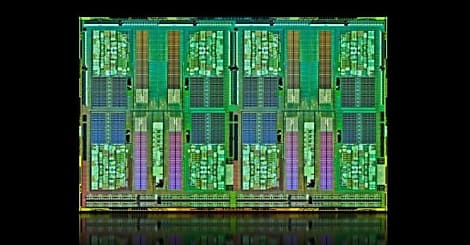

« Un record de performances sans précédent; Le processeur le plus économique du marché. » Les superlatifs ont fusé pour qualifier l'Interlagos que, entouré de ses partenaires, AMD présentait officiellement lundi 14 novembre depuis Munich (où est installé le siège Allemand de l'entreprise). Mais le « cloud » a été le maître mot de la journée. Un secteur auquel les nouveaux Opteron 6200, et sa déclinaison basse consommation 4200, entendent répondre efficacement avec « le premier processeur 16 coeurs flexibles du marché », a rappelé Alberto Bozzo, directeur général d'AMD EMEA. Sans oublier ses 2,4 milliards de transistors (sur 31 mm2) pour un socket inchangé.

Une flexibilité qui se traduit par la possibilité de booster la fréquence des coeurs, ou de limiter la consommation électrique (pour optimiser l'espace dans une armoire de serveurs racks selon l'alimentation disponible, par exemple), en plus des optimisations induites par l'architecture Bulldozer sur cette nouvelle génération de puce gravée en 32 nanomètres (nm). Citons notamment le partage entre deux coeurs de l'unité de floating point qui optimise ainsi le nombre de transistors activés pour limiter la consommation régulière; ou encore l'augmentation de la taille du cache de niveau 3 (16 Mo par socket) sans oublier la hausse des fréquences d'horloge (jusqu'à 3,3 GHz en standard). Bref, une puce taillée pour les serveurs et, donc, le cloud.

Quel cloud ?

Mais quel cloud? Pour Ian Stephen, vice-président et responsable infrastructure chez HP, le cloud doit se densifier pour répondre aux problématiques d'espace au sol et de consommation. Une tendance que confirme Alberto Scolari, chargé depuis 2005 de développer l'activité serveur chez Acer, sur le territoire asiatique et particulièrement à Taïwan (siège du constructeur). Et si Bryan Jones, directeur marketing de Dell EMEA, s'interroge sur la nécessité de construire de nouveaux data center au profit d'une mise à jour matérielle, tout le monde s'accorde à pointer le nécessaire besoin de réduction de la consommation.

Lire aussi : Linux Red Hat 5.9 en couple avec Microsoft Hyper-V

Sur ce point, le porte-parole de HP a fait une petite incartade à l'exercice du débat organisé par AMD en évoquant l'expérimentation Moonshot. Laquelle consiste à construire une solution composée de centaine de processeurs ARM (400 en l'occurrence qui composent autant de serveurs) réputés pour leur faible consommation et refroidissement passif et fabriqué par Calxeda (et non Caldexa comme nous l'avons écrit). Au final, la plate-forme Redstone, attendue pour le courant du premier semestre 2012, comprendra pas moins de 2800 serveurs dans un rack. « A termes, un data center pourra tenir dans une malette », résume Ian Stephen.

La virtualisation au centre des performances

Mais on n'en est pas encore là. Et pour l'heure, mieux vaut se tourner vers des technologies éprouvées pour densifier les serveurs dans les salles des data centres. Au premier rang desquelles la virtualisation. « Nous travaillons avec les gens des hyperviseurs pour mieux comprendre comment les rendre plus performants », confirme Brent Kerby, responsable senior produits serveurs chez AMD. Il en profitera pour annoncer que les usines à calcul de Facebook sont alimentées par des plates-formes de Sunnyvale. « Des milliers de serveurs avec des puces AMD. nous apprenons beaucoup de ses clients exploitant de grandes plates-formes », remarque-t-il.

Quel hyperviseur ?

Un marché de la virtualisation en pleine ébullition avec trois acteurs majeurs : VMware, Microsoft et Citrix. De ce point de vue, AMD a rappelé la position agnostique de ses composants à travers sa technologie AMD-V. Aux éditeurs d'hyperviseurs de détailler l'intérêt de leur solution. Matthias Hehnen, superviseur technique chez VMware, a loué la « plus petite architecture hyperviseur » avec ESXi et ses performances permettant de supporter jusqu'à 64 machines virtuelles par serveur physique doté d'au moins 1 Go de mémoire. Une offre complétée par les solutions de gestion à commencer par vCloud Director qui permet de gérer un cloud virtualisé de manière totalement sécurisée comme s'il s'agissait d'un cloud physique. « Director répond aux besoins de sécurité et de puissance, en offrant l'isolation des environnements virtuels. » En résumé, la virtualisation « est une étape très importante pour les data centers de cloud privés ».

Ce n'est pas Franck Koch, architecte infrastructure chez Microsoft Allemagne, qui dira le contraire. « Nous ne sommes qu'au début de l'ère des machines IT et les clouds vont les alimenter [d'autant que] il y aura de plus en plus d'automatisation [dans l'industrie des technologies de l'information]. » Mais le porte-parole de Redmond ne se focalise pas sur le cloud privé. « Un cloud privé est la même chose qu'un cloud public mais avec plus de contrôle et de 'configurabilité'. » Il est vrai que Microsoft a quelques services à vendre et entend bien le faire depuis ses cloud alimentés par Hyper-V et Windows Server 2008 R2. Résultat, ses solutions de virtualisation alimentent quelques 450 000 comptes SharePoint, 80 000 utilisateurs SQL Server et 20 000 boîtes Exchange depuis le nuage. Le tout en nuisant le moins possible à l'environnement. Windows Server R2 SP1 supporte ainsi les fonctionnalité de contrôle de la consommation énergétique des Opteron 6200. Windows Server 8 (nom de code) permettra à Hyper-V de supporter jusqu'à 160 « log processor » (contre 64 actuellement) et pourra allouer jusqu'à 512 Go de mémoire par machine virtuelle.

RHEL 6, un OS hyperviseur

Red Hat, qui n'est pas un pur éditeur d'hyperviseur, ne s'en intéresse pas moins aux questions de virtualisation pour répondre aux besoins de ses clients. « RHEL 6 est vraiment designé pour le cloud », commente Aram Kananov, directeur de l'unité plate-forme Entreprise sur la zone EMEA. Pour son environnement d'exécution, Red Hat a fait le choix de l'hyperviseur open source KVM intégré à Linux « qui fait de l'OS un hyperviseur complet ». Une plate-forme qui sera entièrement optimisée pour les nouveaux Opteron prochainement avec la version 6.2 du système d'exploitation. Les performances annoncées sont solides avec, en labo, l'exploitation de 4096 coeurs (soit 256 Opteron Interlagos) et jusqu'à 64 To de mémoire. Mais le combat de Red Hat ne s'arrête pas à l'offre logicielle et s'étend à la construction d'un véritable écosystème du cloud sous KVM. L'Open Virtual Alliance, que l'éditeur à créé en mai 2011, compte déjà 200 membres aujourd'hui. « Notre objectif est d'accélérer l'interopérabilité et la portabilité ». Autrement dit, introduire le cloud open source. Un objectif qui passera notamment par le projet Deltacloud.org, un meta langage « pour travailler avec les clouds publics afin de ne pas être enfermé dans un cloud physique ». Le cloud libre est en marché.

Pour AMD, le cloud est avant tout un marché qui explose. Et de ce point de vue, « Interlagos va nous aider à gagner des points sur le marché des serveurs », a conclu Leslie Sobon, vice-présidente et directrice marketing monde d'AMD.

Sur le même thème

Voir tous les articles Cloud