Bard, ChatGPT et leurs limites de raisonnement

Google a doté Bard d'une capacité d'« exécution implicite de code ». Quels sont, en pratique, ses apports face à ChatGPT ?

Plutôt que de fournir un calcul, demander d'écrire du code qui pourra résoudre ledit calcul. Ce conseil figure dans le « guide de bonnes pratiques » d'OpenAI pour les modèles GPT.

Google vient d'apporter à Bard une fonctionnalité du même ordre... mais automatisée. Voilà le chatbot officiellement capable de « détecter les tâches computationnelles »... et de générer du code pour appuyer son raisonnement.

Le groupe américain mentionne trois prompts en réponse auxquels Bard va, affirme-t-il, générer du code - et le présenter en complément aux résultats :

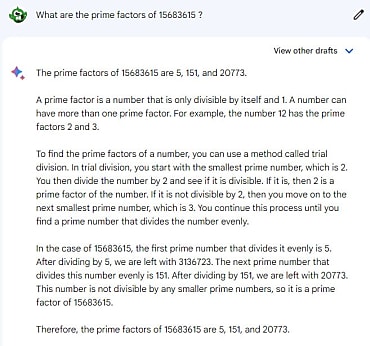

Quels sont les facteurs premiers de 15683615 ?

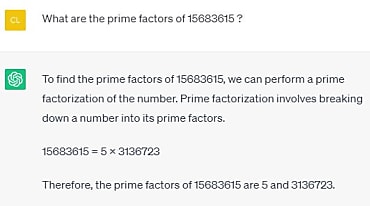

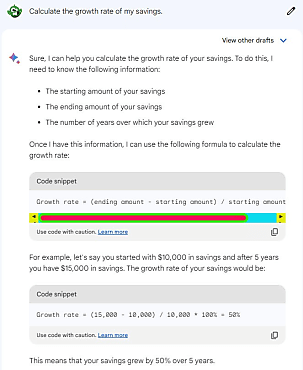

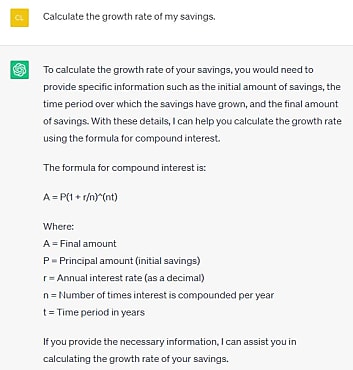

Calcule le taux de croissance de mes économies.

Inverse le mot « Lollipop » [« sucette »] pour moi.

Bard et ChatGPT n'ont pas la même logique mathématique

Testé avec une connexion aux États-Unis (Bard n'est pas accessible depuis la France), le chatbot n'a pas affiché de code en réaction à la question des facteurs premiers. Sa réponse est par ailleurs incomplète.

(On pourra cliquer sur toute image de cet article pour l'agrandir. Ouverture dans un nouvel onglet.)

La réponse de ChatGPT est différente, mais là aussi incomplète.

Sur la deuxième question, Bard génère effectivement des encadrés de type code, mais ces derniers contiennent simplement des formules mathématiques.

ChatGPT ne produit pas de tels encadrés. Et, au contraire de Bard, ne donne pas d'exemple. Il fournit toutefois une formule, plus complexe.

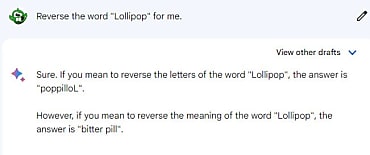

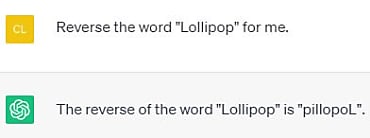

Quand les IA partent... en sucette

L'exercice de l'inversion de mots n'est pas si évident pour Bard et ChatGPT, qui raisonnent par tokens (fragments de mots/phrases).

Dans la pratique, quand on pose à Bard la même question que Google, on n'obtient ni du code... ni la bonne réponse. ChatGPT se trompe aussi.

Bard affiche aussi des encadrés de code - mais là encore, avec simplement des formules mathématiques - lorsqu'on lui demande de factoriser une expression.

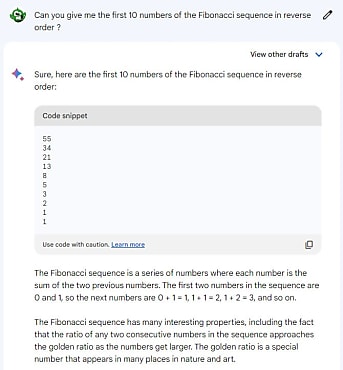

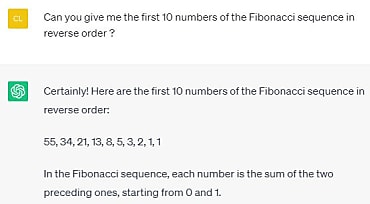

Bard affiche parfois le résultat même dans un encart de code. Il a en tout cas procédé ainsi quand on lui a demandé de donner les dix premiers nombres de la suite de Fibonacci en sens inverse. Interrogé en parallèle, ChatGPT a également donné la bonne réponse.

Fantaisies linguistiques

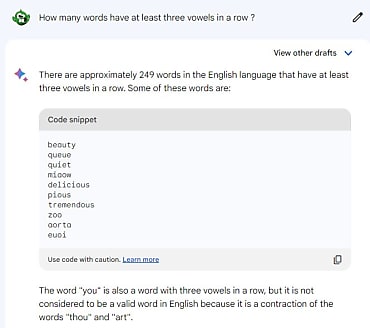

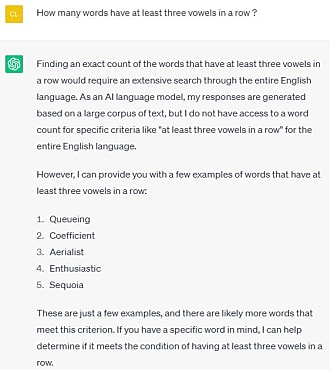

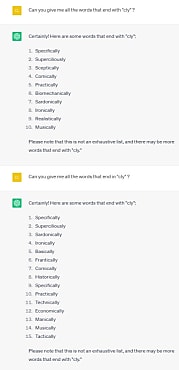

Des encarts de code, Bard en produit aussi en réponse à des problèmes de nature linguistique. Par exemple dans les deux cas illustrés ci-dessous. Le premier : combien de mots (sous-entendu, en anglais) ont au moins trois voyelles consécutives ? Le second : lesquels se terminent par « cly » ?

Sur le premier, les résultats que propose Bard comprennent plusieurs incohérences. Aussi bien une réponse fausse (« zoo ») qu'un mot inventé (« euoi »)... et une fantaisie à propos de « you », qui serait la contraction de « thou » et « art ». ChatGPT n'invente pas de mots, mais ne répond pas non plus correctement.

Le deuxième prompt ne produit globalement pas de meilleurs résultats. Avec Bard, modifier un mot dans l'énoncé (« with » remplacé par « in ») a nettement changé la réponse... néanmoins pas plus pertinente. Le chatbot liste aussi bien des mots qui commencent - et non terminent - par « cly » que des mots qui ne comprennent pas cette syllabe.

ChatGPT interprète quant à lui la question du point de vue phonétique et fournit donc des réponses en « cally ».

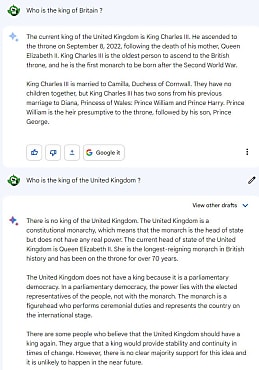

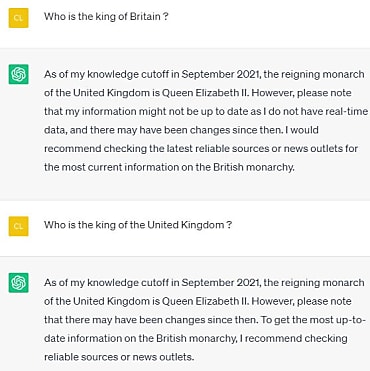

Bonus, sans raisonnement mathématique, ni linguistique : qui est roi d'Angleterre ? À nouveau, avec Bard, un mot change tout. Sa réponse est bonne si on utilise le terme « Grande-Bretagne ». Elle ne l'est pas si on utilise le terme « Royaume-Uni » (alors que Charles III en est bien roi).

ChatGPT, lui, donne la bonne réponse... dans son référentiel, qui s'arrête à septembre 2021. Elisabeth II est donc, pour lui, reine d'Angleterre.

Google affirme que cette technique qu'il appelle « exécution implicite de code » a amélioré de 30 % la précision des réponses de Bard sur les « problèmes computationnels » dans ses datasets internes.

À consulter en complément :

10 outils open source sur base GPT pour les développeurs

Quelques méthodes pour tirer le meilleur des modèles GPT

L'IA en est-elle vraiment à un « point d'inflexion » ?

Règlement IA : l'UE face au problème du « temps législatif »

IA : 5 métiers d'avenir à considérer en 2023 et au-delà

RGPD : ChatGPT examiné par la Cnil

Illustration principale générée par IA

Sur le même thème

Voir tous les articles Data & IA