Worldline fait évoluer sa gouvernance des IA génératives

Nicolas Gour, DSI du groupe Worldline, explique comment l'opérateur de paiement fait évoluer sa gouvernance des IA alors que la GenAI devient omniprésente dans le quotidien des salariés et arrive dans ses produits.

Peu connu du grand public, Worldline est un acteur majeur du paiement en France et en Europe. L'entreprise compte 18 000 collaborateurs et traite jusqu'à 30 milliards de transactions par an, avec un pic de 50 000 transactions par minute avant les fêtes de Noël.

Si l'IA générative n'a pas de rôle à jouer dans ces échanges électroniques, l'éditeur de services s'est néanmoins intéressé très tôt à cette nouvelle classe de modèles. Estimant la disruption de la GenAI équivalente à celle de l'arrivée d'Internet dans les années 90, un membre de la direction générale a l'initiative de créer très tôt une « Task Force » sur l'IA générative dès le début de l'année 2023.

Nicolas Gour, DSI du groupe Worldline, retrace les premières actions de ce groupe de travail :

«Nous avons lancé l'AI Challenge en mars 2023. C'était un exercice comparable à un hackathon proposé à 100% des collaborateurs de l'entreprise. Il s'agissait pour l'entreprise de collecter un maximum d'idées sur les usages potentiels de l'IA générative sur des axes et des thématiques dont nous pensions qu'elles pourraient générer de la valeur pour le groupe.»

Des bonnes pratiques plutôt qu'un blocage systématique

130 soumissions ont été recueillies sur des thèmes comme le développement, la gestion produit, les forces de vente, la communication et le marketing, le service client, le call center et enfin un thème plus global baptisée productivité générale. 25 idées ont fait l'objet d'un pitch et 7 ont finalement été sélectionnées.

Plutôt que de bloquer l'accès à ChatGPT, la stratégie de Worldline a été de poser des règles claires à l'usage des IT génératives.

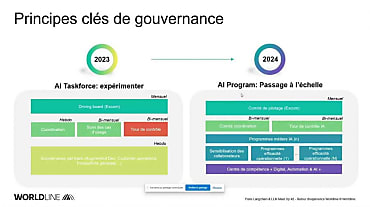

Worldline fait évoluer sa gouvernance des IA pour accompagner la montée en puissance de ses cas d'usage et l'arrivée des LLM dans ses produits.

« Nous voulions que tout le monde réfléchisse à la question car il s'agit d'un enjeu clé pour nous, mais avec des règles : ne pas communiquer de données client, pas de données personnelles et aucune donnée interne. Sur la base d'une série de règles communiquées à tous, le message était de rendre possible l'accès à ces services et pousser les collaborateurs à les utiliser. » précise Nicolas Gour.

Outre ces « Do & Don't », une campagne de sensibilisation est lancée pour démystifier les capacités réelles des IA génératives : « J'ai voulu des programmes de sensibilisation à l'IA générative qui impliquent de la manipulation, arrêter de rêver l'IA générative mais l'expérimenter réellement. » ajoute-t-il.

Comme dans beaucoup de grandes entreprises françaises, un ChatGPT interne à rapidement été mis en place, mais à la différence d'autres, un gros travail a été mené sur l''ergonomie de l'outil.

« Dès le mois de mai 2023, nous avons mis en place une intégration dans Teams pour faire des appels API dans Azure OpenAI. La performance n'était pas au rendez-vous, il y avait plusieurs secondes de délai entre la requête et l'affichage du résultat. D'autre part, nous étions limités par la fenêtre Teams. Cela ne fonctionnait pas. Nous avons commencé à redévelopper notre ChatGPT en nous appuyant sur un développement Open Source LibreChat qui s'appuie en partie sur LangChain. » analyse Nicolas Gour.

Les développeurs de Worldline ont commencé à contribuer au projet LibreChat et ajouter des fonctionnalités manquantes, notamment l'authentification avec Azure Active Directory et des modules complémentaires pour faire du RAG et permettre aux utilisateurs de créer leur propre basevectorielle en quelques clics.

Réduire les hallucinations

« L'intérêt de cette architecture est d'être compatible avec les plug-in LangChain. Cela a transformé ce projet en véritable plateforme d'expérimentation. L'utilisateur moyen accède à notre ChatGPT dans un mode simplifié où il ne dispose que de GPT-4. Un mode avancé permet d'interroger différents modèles, soit des modèles d'autres partenaires ou des modèles Open Source que l'on instancie en interne ou encore DallE. » détaille Nicolas Gour.

Avec les plug-in LangChain, de multiples cas d'usage sont possibles sans énormément de développements. La plateforme compte actuellement 4 500 utilisateurs.

Un autre cas d'usage est apparu sur un portail destiné aux développeurs des clients de Worldine. Pour faciliter le travail d'intégration des API Worldline sur leurs sites de e-commerce, les développeurs disposent d'un portail dédié sur lequel ils trouvent toute la documentation relative à ces API.

L'idée était de mettre en place une recherche assistée par l'intelligence artificielle en intégrant ChatGPT directement dans la barre de recherche du site. Ainsi le développeur peut poser directement sa question dans le champ de recherche et obtenir une réponse.

« Un gros travail de réduction des hallucinations et de mise en place de barrières pour éviter un usage démesuré de la solution et pour s'assurer qu'on ne peut poser de question qui sorte du contexte. » précise le DSI.

Worldline commence à placer ces IA génératives face à ses clients, mais aussi à les intégrer directement dans ses produits. C'est le cas de son offre WLCP, un chatbot commercialisé dans le cadre du support client.

« Pour les chatbots, l'IA générative est désormais un Must-Have. L'équipe produit a pris le taureau par les cornes et a rapidement intégré des technologies RAG. Ses membres sont allés assez loin dans les techniques de chunking et de reformulation des questions, mais il ne s'agit pas juste d'une expérimentation. Ce service est commercialisé auprès de nos clients. Il y a donc de vrais enjeux de tests et de mesure de la fiabilité des réponses. Dans nos mesures, on est passé de 10% de fiabilité à 95% en quelques mois, ce qui nous a permis de le proposer à nos clients. »

Une tour de contrôle pour surveiller les usages

En parallèle à cette montée en puissance des cas d'usage, la gouvernance de l'IA générative mise en place en 2023 a évoluée. La liste des « Do & Don't » s'est transformée en AI policy, avec des guidelines précises sur ce qu'il est possible de faire en fonction des typologies d'outils et la classification des données pouvant être exploitées dans ces différents cas d'usage. La mise en oeuvre de cette politique s'est accompagnée de la mise en place d'une tour de contrôle des IA.

Cette « Control Tower » regroupe des membres du service juridique, de la sécurité, de la protection des données personnelles, des achats. « Plutôt que de freiner et ralentir certains cas d'usage, ce fut en réalité un facteur d'accélération » explique Nicolas Gour. « C'est grâce à elle que nous avons pu valider rapidement les conditions d'accès à Azure OpenAI, les conditions d'accès aux outils de support aux développeurs, etc. Ils ont aussi validé certains cas d'usage avec les demandeurs. » Cette structure permet aux équipes d'aller plus vite dans la création de produits qui intègrent l'IA générative car elle prend en charge la rédaction des clauses juridiques à intégrer aux contrats et les conditions d'utilisation.

Le développement des cas d'usage est mené soit par la DSI centrale lorsque les cas se prêtent bien à un roll-out global, comme par exemple les outils d'assistance au développement. Pour les IA plus liées aux produits, ce sont les 3 entités business du groupe qui mènent leurs propres programmes GenAI. « Nous les soutenons en mettant à dispositions des technologies, du support et nos partenariats » ajoute le DSI.

En termes de technologies et de LLM, l'objectif de Nicolas Gour est de rester le plus flexible possible dans ses choix. « Nous avons été tentés de tout miser sur Azure OpenAI car toutes les entreprises y vont... Nous investissons évidemment sur OpenAI, mais nous cherchons aussi à avoir la capacité à passer d'un modèle à un autre. ».

Le choix d'une approche « Make »

Comme de nombreux confrères, le DSI a opté pour une approche « Make » sur l'IA générative, alors que le Buy et la mise en oeuvre de solutions sur étagère sont désormais la règle dans les grandes DSI.

« Aujourd'hui, sur l'IA générative, quand on travaille avec nos partenaires technologiques et les sociétés de conseil, l'approche est de tout faire en interne. Ça me choque un peu car je suis persuadé que l'on va de plus en plus avoir des produits et que l'on va arrêter de tout faire nous-mêmes. »

La stratégie de Nicolas Gour est d'adopter cette approche Make dans un premier temps, tant qu'il n'existe pas de solutions pouvant traiter tous les cas d'usage. « Nous continuons d'évaluer le marché et sur notre ChatGPT interne, par exemple, nous recalculons très régulièrement les coûts de ce business case. Tant que cela nous coûte moins cher, nous le conservons et nous achèterons un produit comme Copilot ou d'autres lorsque ce ne sera plus le cas. Cela nous permettra d'éviter de maintenir en interne des solutions sur le long terme. »

La réutilisabilité est un autre sujet très important pour le DSI. « Le chemin suivi par chaque acteur qui monte un cas d'usage d'IA générative est assez similaire. Au début, tout le monde fait du Prompt Engineering pour optimiser ses appels à ChatGPT, puis progressivement on va vers les RAG. Chacun est passé par les mêmes étapes. »

Face à des cas d'usage très différent mais des technologies finalement similaires, le DSI a voulu promouvoir des librairies communes, du code partageable et réutilisable au sein de l'organisation. Là encore, la maturité des offreurs de solution fera évoluer cette approche, notamment pour mettre en oeuvre les solutions de « RAG as a Service » qui sont désormais disponibles chez Microsoft et Google et éviter de réinventer la roue à chaque projet.

Sur le même thème

Voir tous les articles Data & IA