Ignite 2023 : dans la « boîte à outils IA » de Microsoft

La conférence Ignite 2023 offre une vitrine sur l'évolution de l'offre Azure AI sous l'angle « LLMOps ». En voici quelques marqueurs.

Dans quelle mesure les services IA d'Azure se nourrissent-ils les uns des autres ? La conférence Microsoft Ignite 2023 a apporté des éléments de réponse.

En première ligne, Azure AI Studio, actuellement en bêta publique. Ce portail s'inscrit dans la lignée de celui déjà disponible sur l'offre Azure OpenAI Service. Il doit donner accès, entre autres, à des briques du portefeuille Azure AI - en alternative au SDK et au CLI.

Parmi les jonctions à l'étude, il y en a, par exemple, une avec la composante « Analyse de texte » de la gamme Azure AI Speech. Elle permettra d'enrichir les transcriptions (extraction de points-clés, résumé, détection d'informations sensibles...).

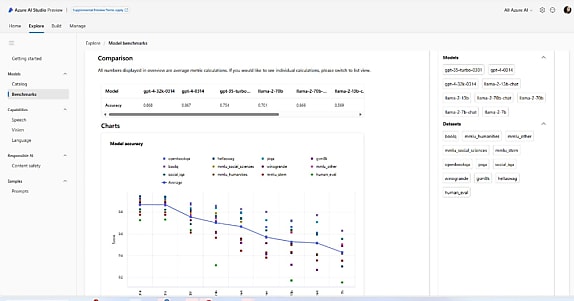

Pour guider les utilisateurs dans le choix des modèles, Azure AI Studio embarque des benchmarks. Ils englobent, pour commencer, les familles OpenAI et Llama 2.

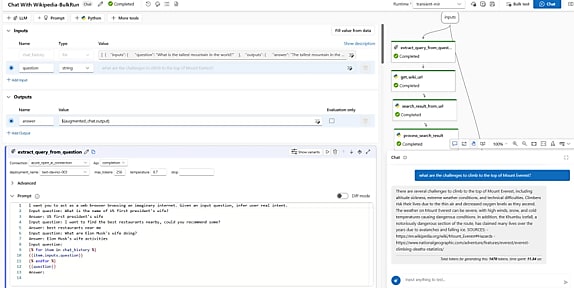

À venir également sur AI Studio, une composante dite « Prompt flow ». Elle est déjà disponible sur l'offre Azure ML, qui cible les data scientists.

En mai dernier, alors que le service était en bêta privée sur Azure ML, Microsoft avait mis l'accent sur la fluidification du prompt engineering à renfort de diverses interfaces (notebook, chatbot, graphe acyclique).

L'intégration sur Azure AI Studio, qui vise un public de développeurs, a été synonyme d'ajout d'une expérience « code-first ». Avec un SDK et un CLI qui permettent notamment la gestion de versions, le packaging/déploiement et l'automatisation.

Azure AI enrichi en connexion avec Hugging Face

Divers modèles du hub Hugging Face s'ajoutent au catalogue OpenAI :

- Stable Diffusion (7 modèles, dont 2 pour l'inpainting)

- Falcon (versions 7B et 40B, avec leurs déclinaisons Instruct)

- Whisper v3 (version large)

- CLIP (3 modèles d'OpenAI pour le traitement d'images)

- BLIP (4 modèles de Salesforce pour le même usage)

- SAM (3 modèles de Facebook pour la segmentation d'images)

Lire aussi : De Llama 3 à Llama 4 : ce qui change, ce qui reste

Microsoft ajoute aussi :

- Deux modèles maison « légers » (1,3B et 2,7B) de la famille Phi

- Code Llama (versions 7B, 13B et 34B, avec leurs variantes Instruct et Python)

- Nemotron-3 8B (5 modèles de NVIDIA dont un de base générateur de texte, un « spécial QA » et trois orientés conversation avec différentes techniques d'entraînement)

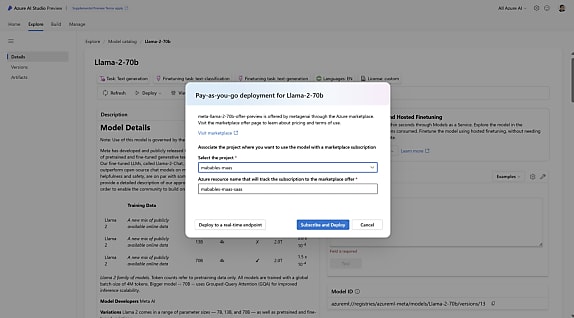

Autre ajout prévu : les « modèles en tant que service ». Dans les grandes lignes, Microsoft mettra à disposition une API d'inférence avec paiement à l'usage. Elle permettra d'exploiter les modèles en question sans avoir à réserver de VM. L'initiative touchera aussi au finetuning. La famille Llama 2 ouvrira le bal. Suivront Command (de Cohere), Jais (de G42) et des « modèles premium » de Mistral AI.

Microsoft aussi pousse la recherche vectorielle

Sur le volet VM, on aura noté l'annonce, dans la gamme ND, d'instances à base de GPU AMD Instinct MI300X 192 Go. Le reste du « socle ND » est reconduit (CPU Xeon Scalable 4e génération, 16 canaux DDR5, InfiniBand 400 Gb/s...).

Pour des modèles nécessitant moins de données et de parallélisme (classification d'images, détection d'objets, NLP n'impliquant pas la génération de nouvelles informations...),les instances H100 v5 sont en preview. Elles reposent sur des EPYC de 4e génération. La configuration de base allie 40 vCPU, 320 Go de RAM, 1 GPU H100 94 Go et 40 Gbps de bande passante. Deuxième option : le double de ces specs.

Il n'y a pas que sur le traitement de la vidéo (voir notre article) que la recherche vectorielle se répand. La voilà aussi lancée - en GA - sur Azure AI Search (ex-Azure Cognitive Search). Elle associe magasin de vecteurs et bibliothèques clientes (Python, JavaScript, .NET, Java), avec une dose de recherche sémantique (classement des documents et mise en avant des extraits pertinents).

Microsoft travaille, en parallèle, sur un système de vectorisation intégrée. L'objectif : permettre de segmenter et de vectoriser des données lors de l'ingestion. Une option complémentaire au pipeline RAG d'Azure AI Studio. Elle est pour le moment en bêta publique, avec un exemple de mise en application sur Azure SQL Database.

Sur le volet bases de données, on signalera l'ajout d'une extension Azure AI pour Azure Database avec PostgreSQL. Elle permet d'accéder aux services Azure OpenAI et Azure AI Language par des appels de fonctions dans les requêtes SQL.

Illustration principale © Ben - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA