OpenAI ouvre les vannes de GPT-3

Il n'y a plus de liste d'attente pour accéder à l'API d'OpenAI. Et aux modèles d'IA sous-jacents. Le point sur les dernières fonctionnalités expérimentales.

Finie la liste d'attente pour accéder à GPT-3. OpenAI l'a officialisé la semaine dernière. Et est revenu, à cette occasion, sur quelques éléments récemment ajoutés à son API.

En tête de liste, les modèles Instruct. Actuellement en bêta, ils sont au nombre de deux. Comme les modèles de base dont ils dérivent (Curie et Davinci), on peut les utiliser pour interpréter et générer du langage naturel. La valeur ajoutée ? De meilleures performances dans la compréhension des consignes qu'on leur communique, affirme OpenAI.

Ces consignes seront rédigées en anglais, éventuellement avec des listes à puces. On pourra préciser un certain nombre d'éléments. Par exemple, les catégories entre lesquelles classer des entrées ou le public à qui s'adresse le contenu en sortie.

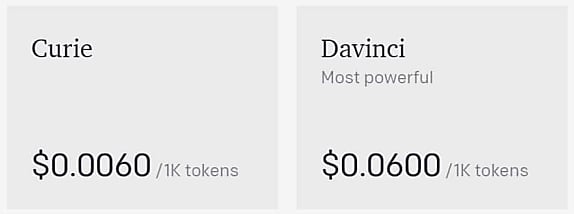

Les prix sont les mêmes que pour les modèles de base. À savoir 0,006 $ les 1000 tokens pour Curie. et dix fois plus cher pour Davinci. Un token équivalant à un « fragment de mot » (en anglais, environ 4 caractères ou 0,75 mot).

OpenAI admet deux usages sur lesquels ces modèles spécialisés sont probablement moins performants que les modèles de base. D'un côté, la recherche sémantique (pas entraînés pour). De l'autre, la complétion d'un long texte.

Autre ajout récent, là aussi en bêta : un endpoint spécifique aux questions-réponses. Il exploite le même format de fichier (JSON en ligne) que le point de terminaison destiné à la recherche sémantique. Le schéma ci-dessous illustre son processus de sélection du contexte.

En bêta également, il y a un moteur de filtrage du contenu. Accessible via l'endpoint « completions », il classe en trois catégories : « sûr », « sensible » et « dangereux ».

OpenAI mentionne aussi Codex, un modèle dédié à la compréhension et à la génération de code informatique. GitHub s'en est servi pour développer Copilot.

Illustration principale © artinspiring - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA

![Déployer l'IA à l'échelle : l'approche d'AXA, entre vision et [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/473364/deployer-echelle-approche-axa-L.jpg)