Quelle infrastructure on-premise pour porter une stratégie IA ?

Le Cloud public n'a plus le monopole de l'IA. De nombreuses entreprises cherchent à internaliser leurs algorithmes d'IA. Que ce soit pour des raisons de conformité, de souveraineté ou de performance, elles cherchent des solutions hardware pour porter leurs IA. Un marché particulièrement dynamique pour les constructeurs informatiques.

Sommaire

Le Cloud public n'est plus nécéssairement un prérequis pour l'IA. Si beaucoup d'entreprises l'ont utilisé lors de la mise à l'épreuve du concept et de leurs premiers projets digitaux, il existe des alternatives. De multiples appliances ont été lancées ces derniers mois afin de répondre à leurs besoins pour déployer des IA en on-premise et dans le Edge Computing. L'offre est déjà très fournie chez les constructeurs de serveurs, depuis les racks spécialisés jusqu'aux PC IA capables aujourd'hui de faire tourner des inférences d'IA.

Dell a récemment annoncé la disponibilité de racks conformes à la dernière spécification Open Rack v3 d'Open Compute Project. « L'IR7000 est le premier rack compatible à arriver sur le marché », explique Eric Bezille, Senior Presales Manager, Systems Engineering chez Dell. « Celui-ci peut atteindre une puissance de 140 kW pour aligner jusqu'à 72 GPU GB200 de Nvidia. Ces racks intègrent l'alimentation et le refroidissement pour monter jusqu'à 480 kW. » Ces racks sont clairement conçus pour les entreprises qui entraînent des modèles LLM dits de fondation. Pour des besoins moins extrêmes comme le fine-tuning de LLM ou l'entraînement de modèles prédictifs, le constructeur propose un modèle intermédiaire, l'IR5000 peut intégrer des modules standards de 19'.

HPE ProLiant DL145 Edge - Pour le Edge Computing, HPE propose des bundles avec des éditeurs spécialisés dans la Computer Vision, dans la création de LLM, comme LightOn en France, et proposer ainsi des solutions prêtes à l'emploi.

Tous les acteurs du HPC se positionnent sur ce marché à très fort potentiel de l'entraînement des IA et des LLM de fondation avec une montée spectaculaire de la puissance des racks. Chez HPE, on estime qu'avec un refroidissement liquide de l'ensemble des éléments du rack, la puissance va passer d'une moyenne de 5 à 20 kW à jusqu'à 360 kW, avec un maximum de GPU empilés au m2.

Lire aussi : ZT Systems, une acquisition à point nommé pour AMD ?

1 Bienvenue dans l'ère des appliances AI

À côté de ces monstres de puissance, les entreprises ont des besoins plus modestes pour entraîner leurs modèles prédictifs, « fine tuner » les LLM de fondation ou porter leurs moteurs de recherche RAG. Les constructeurs de serveurs répondent bien évidemment présents. HPE propose ainsi Private Cloud AI, une appliance préassemblée en usine en intégrant serveurs, stockage et logiciels. L'ensemble est piloté via un portail Web pour proposer une expérience proche des services managés du Cloud. « Cette solution a notamment pour objectif de réduire la complexité d'intégration d'une plateforme IA complète, ce qui demande généralement de 7 à 8 mois de travail », estime Philippe Rullaud. HPE fournit aussi des connecteurs afin de simplifier l'accès aux données ainsi que le travail des data scientists avec les outils Nvidia AI Enterprise, ainsi que tous les microservices NVidia NIM.

DR

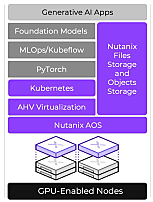

Nutanix GPT in a Box - L'approche GPT in a Box de Nutanix est reprise par de nombreux fournisseurs. L'idée est de préintégrer en usine tout le stack matériel et logiciel dans une appliance afin d'accélérer le déploiement des projets IA.

Nutanix suit une démarche très similaire avec le lancement, il y a deux ans, de sa GPT in a Box. « L'idée étant de fournir une plateforme IA prête à l'emploi où l'entreprise n'a plus qu'à poser ses modèles et ses LLM », argumente Stéphane Berthaud, directeur Systems Engineering de Nutanix pour la France et la zone Afrique Nord-Ouest. « Cette première itération a fait place depuis à GPT in a Box version 2 qui propose une intégration avec les repository IA d'Huggingface et NIM de NVidia. » Comme sur une marketplace, l'utilisateur se connecte au référentiel de son choix pour télécharger et déployer les modèles de son choix sur la solution. L'idée est de fournir le même niveau de simplicité que le Cloud public pour consommer des modèles d'IA et des LLM sans se préoccuper du sous-jacent. Les équipes de l'infrastructure peuvent monitorer le cluster, les temps de réponse, les GPU utilisées, etc. La toute dernière évolution de cette offre a été de pouvoir utiliser des LLM indifféremment sur GPT in a Box ou dans le Cloud public depuis la même interface, selon chaque cas d'usage.

2 Le stockage, un composant d'architecture trop négligé

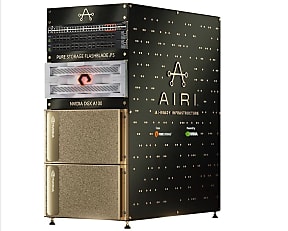

L'appliance AIRI de Pure Storage, un équipement qui intègre notamment les modules de calcul DGX de Nvidia et la technologie de stockage du constructeur.

L'autre point important d'une architecture IA porte sur le stockage des données. L'accès aux données est souvent le goulet d'étranglement des architectures GPU. Un acteur comme Pure Storage fournit aux hyperscalers et CSP des modules SSD de type DFM (« DirectFlash Modules ») avec une densité très élevée et une consommation faible (de l'ordre de 6 W pour 100 To). Pour les entreprises, le fournisseur propose une plateforme intégrée, AIRI (« AI Ready Infrastructure ») qui allie les modules DGX de Nvidia, des switchs Infiniband Arista de Nvidia et ses appliances Flashblade. Toutes les couches logicielles nécessaires à l'IA sont préchargées dans l'appliance. « Conscients que tous les clients n'avaient pas besoin de la puissance du Nvidia DGX, nous avons créé une alternative plus modeste », explique Gabriel Ferreira, directeur technique de Pure Storage. « Cette appliance s'appuie sur des serveurs UCS Cisco dotés de cartes GPU, des switchs Cisco et notre solution Pure Storage. En termes de capacité, on peut commencer petit, puis croître de manière progressive, en fonction des besoins. Cette entrée de gamme est adaptée pour faire tourner des inférences et des modèles de machine learning classiques. »

Qu'il s'agisse d'appliances spécialisées ou de serveurs dopés avec des cartes GPU, les DSI disposent aujourd'hui de toutes les briques pour déployer des architectures IA complètes et répondant à des cas d'usage où le Cloud public reste encore proscrit.

Eric Bezille, Senior Presales Manager, Systems Engineering chez Dell

Il faut amener l'IA à la Data

« Nous voyons beaucoup de clients qui commencent avec des PoC dans le Cloud public, puis, lorsqu'ils veulent passer à l'échelle, ils se tournent vers nous pour déployer ces modèles au plus près de leurs données. Les industriels ne souhaitent pas diffuser ces données dans le Cloud public, notamment pour des raisons de conformité. Elles doivent parfois privilégier l'Edge pour bénéficier de temps de réponse compatibles avec leurs process. Il faut amener l'IA à la Data et pas l'inverse. »

Sur le même thème

Voir tous les articles Data & IA

![Déployer l'IA à l'échelle : l'approche d'AXA, entre vision et [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/473364/deployer-echelle-approche-axa-L.jpg)