NVIDIA à fond sur l'inférence : quelques éléments à retenir de la GTC 2025

Lors de la GTC 2025, les workloads d'inférence ont nettement orienté la parole de NVIDIA... et ses actes, dans une certaine mesure.

Ne dites plus Triton, mais Dynamo ?

Le premier de ces serveurs d'inférence commence à s'effacer au profit du second, désigné comme son successeur. NVIDIA y a effectivement intégré des mécanismes censés mieux répondre, entre autres, à la croissance de la taille des modèles, à leur intégration dans des workflows agentiques... et aux architectures GPU distribuées qui en résultent.

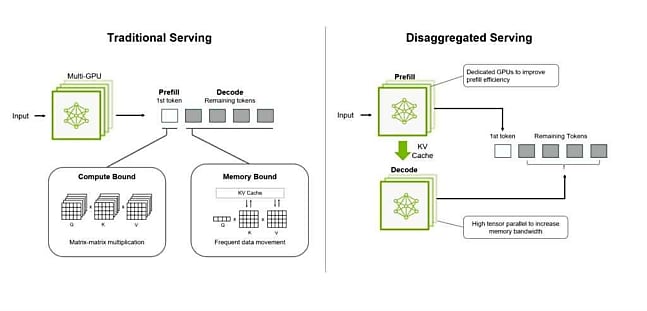

Parmi ces mécanismes figure la désagrégation des phases de préremplissage (prefill) et de décodage (decode). La première traite l'input pour générer le premier token. Elle est essentiellement dépendante des ressources CPU. La deuxième génère les tokens suivants. Elle a surtout besoin de ressources mémoire. Localiser ces opérations sur des GPU distincts permet de mieux optimiser chacune, en appliquant différentes stratégies de parallélisme.

Lire aussi : Les mini-PC petascale de NVIDIA prennent corps

Dynamo comprend un planificateur qui automatise ces choix. Il décide d'activer ou non l'inférence désagrégée et éventuellement de dédier davantage de ressources à l'une ou l'autre phase. Il pourra par exemple confier une partie du prefill aux GPU decode dans le cas d'un traitement par lots de requêtes de synthèse de texte (inputs longs, outputs courts).

Autre technique mise en oeuvre : une forme de "routage intelligent" du cache clé-valeur. Ce cache encode une représentation contextuelle de l'input. Il est intéressant d'éviter de le recalculer dans les cas où une même requête est souvent exécutée (prompts système, historiques de conversation, workflows agentiques).

Dans cette logique, Dynamo évalue la ressemblance entre les requêtes entrantes et le cache clé-valeur. En combinant ce score avec la distribution du workload sur la flotte GPU, il dirige les requêtes vers les noeuds les plus adaptés. S'y ajoute un système de tiering de la mémoire qui déporte vers du stockage plus "froid" les données moins fréquemment utilisées dans le cache clé-valeur.

cuOpt passe en open source

Autre brique logicielle évoquée lors de la GTC 2025 : le moteur d'optimisation combinatoire cuOpt. Le voilà désormais en open source. Pas dans les dépôts de NVIDIA, mais dans ceux de la COIN-OR (Computational Infrastructure for Operations Research), une fondation à but non lucratif née en 2000 sous l'impulsion d'IBM. Parmi ses utilisateurs, NVIDIA met en avant Domino's Pizza pour sa logistique de livraison et Kawasaki pour la maintenance des voies ferrées.

Lire aussi : L'Europe passe à l'IA pour les prévisions météo

Llama Nemotron pour le raisonnement, Isaac Gr00t N1 pour la robotique

Dans la boîte à outils open source de NVIDIA se sont aussi ajoutés des LLM. Parmi eux, les modèles de raisonnement Llama Nemotron. Construits sur Llama, avec des améliorations sur les maths, le code et la prise de décisions complexes. Trois tailles disponibles : Nano (usage local et en edge), Super (mono-GPU) et Ultra (multi-GPU). ServiceNow les exploite pour développer des agents ; SAP, pour enrichir notamment son copilote Joule.

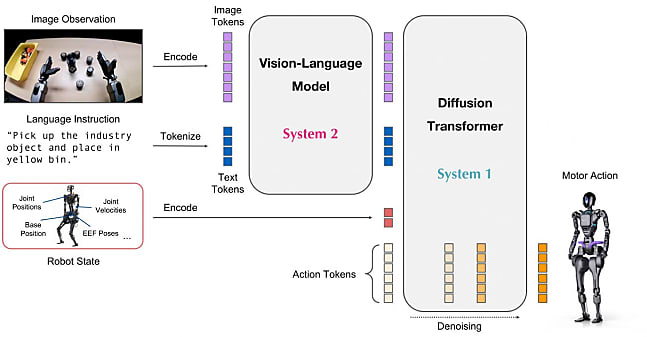

Au rang des modèles de fondation plus spécifiques, il y a Isaac Gr00t N1 2B. Sa cible : les robots humanoïdes. Son rôle : à partir d'un input multimodal (vidéo + état du robot + action), réaliser des tâches de manipulation. Il associe un modèle de vision qui interprète les instructions et un modèle de diffusion qui les traduit en mouvements.

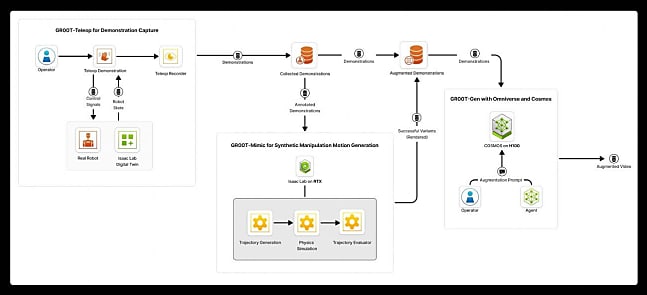

L'entraînement s'est fait sur trois types de contenus : démonstrations humaines, vidéos issues d'Internet et données de trajectoire synthétiques. Ces dernières ont été générées grâce à un blueprint (workflow de référence) qui utilise Omniverse et des modèles Cosmos.

Assistants de recherche, données synthétiques... Qui n'a pas son blueprint ?

La famille Cosmos regroupe des world models, capables de simuler des environnements du monde réel. Elle accueille officiellement, à l'occasion de la GTC 2025, un autre blueprint de génération de données synthétiques, axé sur les véhicules autonomes. Il met à contribution les modèles Cosmos Transfer, qui ingèrent des éléments de type cartes de profondeur, scans lidar ou fichiers de trajectoire pour créer des rendus vidéo photoréalistes en faisant varier des conditions telles que l'éclairage et la météo.

La lignée Cosmos Predict, annoncée aux CES, s'agrandit également, avec des modèles capables de générer des trajectoires ou des actions étant donné une image de départ et une image d'arrivée. NVIDIA y ajoute Cosmos Reason, un modèle à chaîne de pensée conçu pour prédire l'issue d'interactions (une personne traverse un passage piéton, une boîte tombe d'une étagère, etc.).

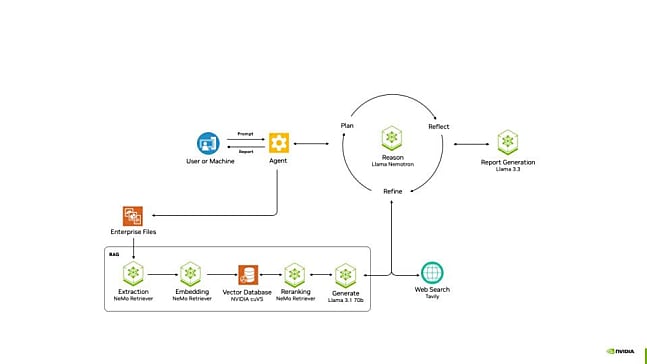

Autre blueprint mis en avant lors de la GTC 2025 : AI-Q. Destiné au développement d'assistants de recherche, il s'appuie, en particulier, sur les modèles Llama Nemotron, la brique RAG NeMo Retriever et la bibliothèque AgentIQ (collaboration entre agents). On le retrouve dans l'AI Data Platform, une architecture de référence à destination des fournisseurs de solutions de stockage. Lesquels peuvent ainsi élaborer des infrastructures d'exploitation de données... se nourrissant de la stack NVIDIA.

Lire aussi : Les LLM autorégressifs ont-ils fait leur temps ?

Blackwell au-delà du datacenter

Parmi les projets expérimentaux sur lesquels NVIDIA a communiqué lors de la GTC, on peut citer Project Aether. Dans la lignée des bibliothèques de data science RAPIDS, il doit procurer l'outillage nécessaire pour accélérer la migration des workloads Spark des CPU vers les GPU.

Project DIGITS, annoncé au CES, vient quant à lui de dépasser le stade expérimental. Il s'incarne en un mini-PC : le DGX Spark (voir notre article à son sujet), qui embarque un SoC de la gamme Grace Blackwell, jusque-là utilisée exclusivement dans le datacenter. En parallèle, la DGX Station (format tour) est mise à jour, elle aussi sur du Grace Blackwell. Contre de l'Ampere (GPU A100 + CPU AMD EPYC) sur la génération précédente.

La DGX Station exploitera plus précisément la puce GB300. On retrouvera aussi cette dernière dans des systèmes DGX SuperPOD. En particulier dans une configuration à 72 GPU et 36 CPU (format rack avec refroidissement liquide). Comme pour les GB200, donc, mais avec 50 % plus de performance, si on en croit NVIDIA - qui annonce 1,1 exaflops en FP4. Notamment parce que la quantité de mémoire dédiée passe de 192 à 288 Go par GPU. Disponibilité prévue pour le deuxième semestre 2025.

Sur la partie réseau, on aura noté l'ambition d'intégrer de la photonique sur silicium dans les switchs Quantum-X (InfiniBand) et Spectrum-X (Ethernet). En 2025 pour les premiers ; en 2026 pour les seconds.

Illustrations © NVIDIA

Sur le même thème

Voir tous les articles Data & IA

![Modern Data Stack : la migration accélère vers le Data [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/3/469074/modern-data-stack-accelere-dwaas-L.jpg)