Google optimise le PUE de ses datacenters avec du machine learning

Un ingénieur de Google a inventé une méthode s'appuyant sur l'apprentissage automatique pour prédire les évolutions du PUE au sein des datacenters. Le géant du web va prochainement le déployer dans ses salles.

Google est une société souvent mise en avant pour ses salaires et ses conditions de travail. Sur ces dernières, les employés de la firme de Mountain View ont la possibilité de consacrer une partie de leur temps de travail sur des projets personnels (la fameuse règle des 80/20). Un ingénieur spécialisé dans les datacenters du nom de Jim Gao a profité de son « temps libre » pour travailler sur le machine learning. Ses recherches lui ont permis de construire un système pour prédire avec précision les évolutions du PUE (Power Usage Effectiveness) des datacenters et de proposer des corrections en cas de faiblesses.

Le PUE d'un datacenter est le ratio de l'énergie totale consommée par l'ensemble du datacenter (avec la climatisation) et la partie qui est effectivement consommée par les infrastructures IT (serveurs, stockage, réseau). L'indice d'efficacité énergétique idéal est de 1 (l'énergie totale consommée par le datacenter est égale à celle des systèmes informatiques) et des efforts sont menés par les grands acteurs du web, comme Google et Facebook, pour atteindre ce ratio. Plusieurs techniques ont été mises en ouvre comme le free cooling (refroidissement par l'air extérieur) ou la tolérance de températures plus élevées dans les salles serveurs. On peut citer également le projet Open Compute qui réinvente les équipements IT pour prendre une place optimale dans les salles. En jouant sur ces différents paramètres, ces sociétés peuvent économiser des millions de dollars sur leur facture énergétique.

Un réseau neuronal pour analyser les interactions dans le datacenter

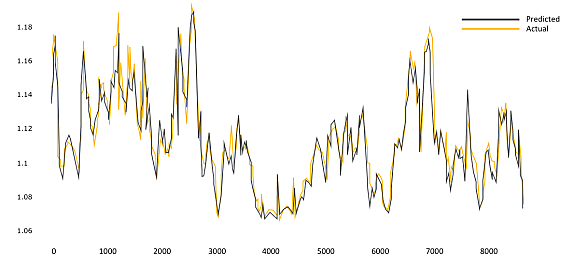

Google dispose de données sur l'évolution du PUE de ses datacenters depuis 5 ans en collectant différentes données toutes les 5 minutes. La firme a transmis à Jim Gao un jeu de données comprenant 19 variables (température de l'air extérieur, l'humidité, les actions des échangeurs thermiques, des tours de refroidissement, l'utilisation des serveurs.). Cela représente des millions de données et l'ingénieur a choisi de construire un modèle à partir d'un réseau neuronal permettant d'analyser les impacts de certaines actions sur le PUE d'un datacenter. Il explique la construction de ce modèle dans un whitepaper disponible sur le web. Et les résultats sont concluants comme le montre le graphique ci-dessous. Google a comparé les statistiques réalisées avec une méthode traditionnelle et avec les prédictions de Jim Gao. Le taux d'erreur est de 0,004%.

Cela signifie que la méthode de l'ingénieur peut être utilisée en mode prédictif et ouvre un champ d'interactions pour les datacenters de Google. Selon le site GigaOM, le géant du web pourrait utiliser l'apprentissage automatique pour élaborer des simulations sur ses centres de calcul et observer le comportement du PUE. Interrogé sur le futur de cet outil, le responsable des datacenters de Google Joe Kava explique qu'après un an de test, l'outil de Jim Gao va être déployé sur la totalité des datacenters de la société. Il exclut pour l'instant d'en faire un produit à part entière, mais en publiant le whitepaper il donne la possibilité à d'autres de travailler sur le sujet. La solution de Jim Gao utilise un simple serveur, précise le dirigeant.

A lire aussi :

Sur le même thème

Voir tous les articles Cloud