Ignite 2023 - Microsoft et l'IA : que retenir sur le traitement du langage naturel

Comment se développe, chez Microsoft, l'offre de traitement du langage ? La conférence Ignite 2023 est l'occasion d'un bilan.

Où en est le développement des services d'IA chez Microsoft ? La Tech Community donne un aperçu pour le moins exhaustif... mais aussi parcellaire. Surtout dans le cadre de l'Ignite 2023 : plusieurs dizaines de contenus sont parus au premier jour de cette conférence.

Voici quelques-unes des annonces dans le domaine du traitement du langage.

Sur Azure AI Language

[Rappel : cette offre unifie les services Analyse de texte (Text Analytics), QnA Maker et LUIS.]

Microsoft ajoute GPT-3.5 Turbo à la liste des LLM sous-jacents. Et propose, avec l'API version 2023-11-15-preview :

- Possibilité d'angler les résumés d'articles et de rapports

Lire aussi : Un modèle spécial OCR chez Mistral AI

- Prise en charge linguistique officiellement étendue au-delà de l'anglais pour le résumé de conversations (8 langues supplémentaires, dont le français)

- Gestion de plusieurs formats de documents (Word, PDF, PowerPoint) en plus du texte simple

- Version conteneurisée des services de résumé, utilisable en mode connecté ou déconnecté, y compris dans d'autres régions que celles que couvre l'offre cloud

Sur Azure AI Speech

[Cette offre réunit des services de reconnaissance et de synthèse vocales, ainsi que de traduction.]

Plusieurs éléments passent officiellement en phase commerciale à l'occasion de l'Ignite 2023. Parmi eux :

- Modèles bilingues

Deux options pour commencer : anglais + espagnol et anglais + français.

- Embedded Speech

Dans le même esprit que le « conteneur AI Language », il s'agit d'un « mode déconnecté » pour les services Azure AI Speech. Le socle fonctionnel est le même que celui qui propulse, sur Windows 11, l'accès vocal, le Narrateur et les sous-titres en direct (live captions).

- Évaluation de la prononciation

Ce système exploite une gamme de modèles pour juger de la précision, de l'aisance et de la complétude. Mais aussi - en bêta, néanmoins - la prosodie (rythmique), la grammaire, le vocabulaire et la pertinence par rapport au sujet. On le trouve, entre autres, dans l'outil Reading Progress pour Teams et dans le « coach en prise de parole » de PowerPoint.

D'autres briques sont pour le moment en version expérimentale. Citons :

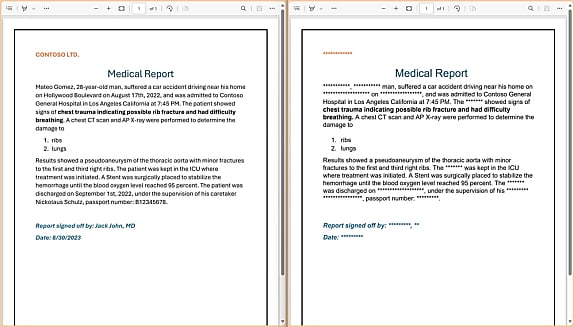

- Création d'avatars

On est là dans le domaine de la synthèse vocale. Le texte est d'abord découpé en phonèmes. Un premier modèle produit l'audio tout en prédisant les caractéristiques acoustiques. Un deuxième modèle génère un avatar et assure la synchronisation labiale.

Microsoft propose des modèles prêts à l'emploi. On peut aussi créer ses propres avatars en téléversant des données vidéo, voire de l'audio.

- Personal Voice

Il s'agit ici de permettre aux utilisateurs de créer leurs propres voix, à partir d'un court enregistrement (1 minute).

- Personnalisation de Whisper

Le modèle speech-to-text d'OpenAI peut être adapté grâce à des données audio et leurs transcriptions annotées. Par exemple, pour lui faire apprendre un vocabulaire ou des conditions acoustiques spécifiques.

Sur Azure AI Translator (Traducteur)

Il y a du nouveau pour l'une des fonctionnalités qui composent ce service. En l'occurrence, Custom Translator, qui permet de créer des systèmes de traduction automatique personnalisés et d'y accéder par une API.

Tous les utilisateurs peuvent désormais expoiter des modèles de langues dits « directs » au sens où ils n'ont plus besoin de passer par l'anglais.

Le français peut pour le moment être langue source dans deux cas (allemand ou italien) et langue cible dans trois (allemand, italien ou néerlandais).

Illustration principale © WrightStudio - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA

![NVIDIA à fond sur l'inférence : quelques éléments à retenir de [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/3/469193/nvidia-fond-inference-elements-retenir-gtc-2025-L.jpg)