De l'image au son, OpenAI met le cap sur le multimodal

La multimodalité se développe dans l’offre d’OpenAI. Le traitement de la vidéo en reste toutefois absent… et l’audio reste à part.

« DALL-E 3 ouvre la voie à un ChatGPT multimodal. » Ainsi avions-nous réagi, il y a quelques semaines, lorsque OpenAI avait annoncé son intention d’intégrer le premier dans le second. C’est officiellement fait depuis mi-octobre.

Restait à ouvrir l’accès à DALL-E 3 par API. La conférence développeurs organisée ce 6 novembre a été le théâtre de ce lancement.

De DALL-E 2 à DALL-E 3 : ce qui change sur l’API

DALL-E 3 ne permet, pour le moment, que de créer des images (pour en éditer ou en créer des variations, on en reste à DALL-E 2).

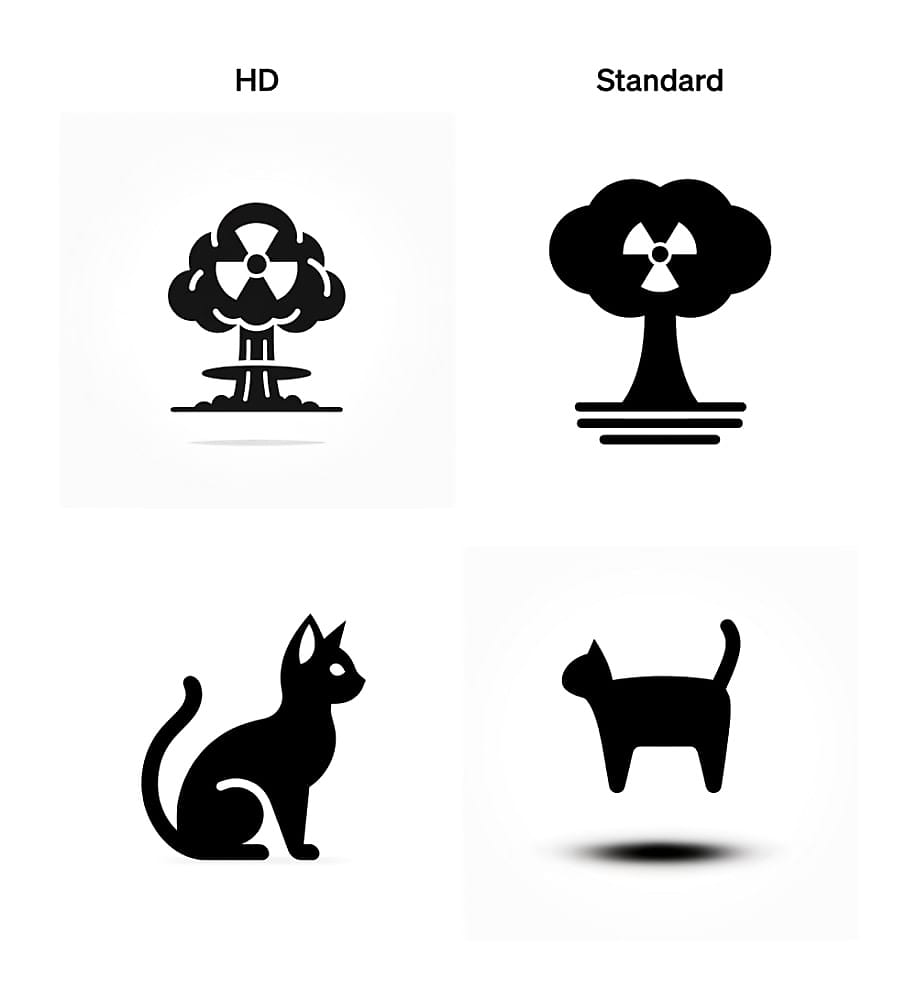

Avec lui arrivent de nouveaux paramètres. D’un côté, pour définir le style (natural ou vivid ; ce dernier, tendant vers l’hyperréalisme, est le mode par défaut, comme d’ailleurs sur ChatGPT). De l’autre, pour régler la qualité (standard ou HD ; illustration ci-dessous sur la production de logos).

Autre différence : la taille des images produites. Le format carré reste une option (à 1024 pixels de côté, soit le maximum que permet DALL-E 2), mais le format 3:2 est désormais accepté (1024 x 1792 ou 1792 x 1024 pixels).

Alors que DALL-E 2 peut générer jusqu’à dix images par requête, DALL-E 3 ne peut en générer qu’une. Contrepartie : en back-office, les prompts passent par GPT-4, qui les enrichit (une option non désactivable en l’état).

GPT-4 doté d’une vision… expérimentale

En matière de gestion des images, il y a aussi des avancées sur GPT-4. Il existe désormais une version expérimentale spécialisée accessible sur l’API Chat Completions. Sur les autres tâches, elle conserve le même niveau de performance que le modèle d’origine, assure OpenAI.

Pour fournir les images, deux solutions : par URL ou en base64 (au niveau des messages user, system et/ou assistant). On peut en transmettre plusieurs par requête. Taille maximale : 20 Mo. Formats acceptés : jpeg, PNG, WebP et GIF non animé.

GPT-4 n’exploite pas les métadonnées. On peut contrôler son niveau de fidélité, sur deux échelons :

– Low

Le modèle travaille sur une version de l’image de 512 pixels de côté. Il la représente avec un budget de 65 tokens.

– High

L’image est mise à l’échelle en deux temps. D’abord pour ne pas dépasser 2048 pixels de longueur, puis 768 de largeur. Chaque carré de 512 pixels de côté consomme 170 tokens ; il faut en ajouter 85 pour l’image dans son ensemble.

L’API étant sans état, elle ne conserve pas les images entre les requêtes. Il n’est pas encore possible d’affiner le modèle. Il a du mal, entre autres, avec :

– Alphabets non latins

– Images pivotées ou renversées

– Raisonnement spatial

– Panoramas et fish-eye

– Décompte d’objets

– Texte et graphiques où couleurs et styles varient

Il est prévu d’intégrer ces fonctionnalités dans GPT-4 Turbo une fois qu’elle seront stabilisées. Le modèle, lui aussi en preview, bénéficie d’une fenêtre de contexte élargie (128k tokens) et d’une base de connaissance étendue jusqu’à avril 2023.

Avec GPT-4 Turbo arrive aussi un « mode JSON ». Activable par l’intermédiaire du paramètre response_format, il « force » le modèle à produire du JSON syntaxiquement valide.

Autre nouveau paramètre : seed. Il permet de tendre vers des résultats reproductibles en rendant les modèles plus déterministes. Son efficacité peut se vérifier avec le champ de réponse system_fingerprint, qui représente la configuration en back-end.

Reconnaissance et synthèse vocales encore à part

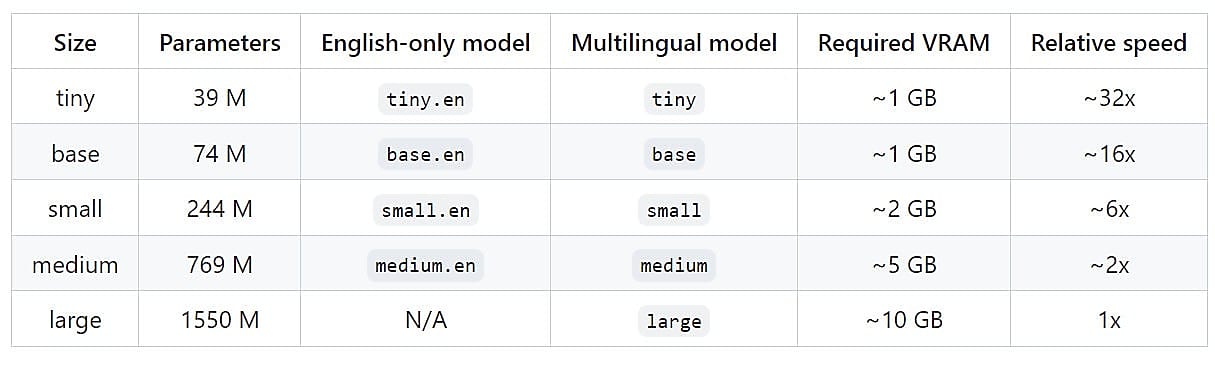

OpenAI a un modèle spécifique à la reconnaissance vocale : Whisper. Il vient d’en publier la v3. Son intégration sur l’API se fera « dans un avenir proche ». Il n’y aura pas de différence avec la version ouverte (sous licence MIT), sinon une garantie de rapidité des traitements.

Pour la synthèse vocale, OpenAI propose désormais une API. Avec deux variantes de modèle (tts-1, plus rapide et tts-1-hd, plus qualitatif) et un choix entre six voix. Format de sortie par défaut : MP3 (supporte aussi Opus, AAC et FLAC). L’audio peut se lancer avant que le fichier complet soit généré.

Illustration principale © Dmytro – Adobe Stock

Sur le même thème

Voir tous les articles Business