NVIDIA s'affirme en fournisseur de... logiciels

À travers, entre autres, la notion de microservices, NVIDIA donne du relief à son offre logicielle à l’occasion de la GTC 2024.

NVIDIA est-il désormais moins un fournisseur de puces qu’un fournisseur de « plates-formes » ? L’heure est en tout cas à la revendication de ce positionnement.

Pour l’incarner, l’entreprise généralise, dans sa communication, diverses notions. Dont celle de microservices.

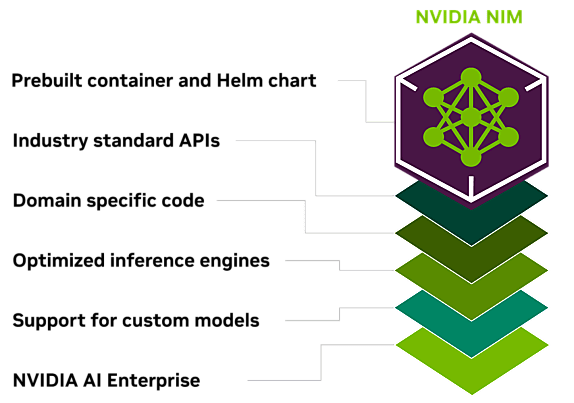

Sous cette bannière, elle place notamment NIM (NVIDIA Inference Microservice). Ce service fait partie de l’abonnement NVIDIA Enterprise (4500 $/an/GPU). Il est censé accélérer le déploiement de modèles d’IA en embarquant, au sein de conteneurs, des versions optimisées du serveur d’inférence Triton et de la bibliothèque TensorRT-LLM, le code adéquat et des API standards.

Dans le secteur de la santé, par exemple, MoIMIM (chimie générative) est proposé sous cette forme. Comme ESMFold (prédiciton de la structure de protéines) et DiffDock (simulation d’interactions moléculaires).

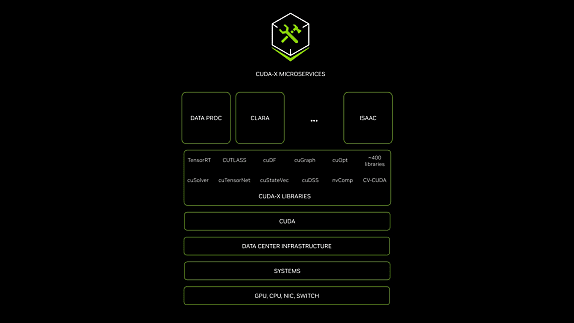

Au catalogue NVIDIA figurent aussi les « microservices CUDA-X ». Y sont regroupés des outils, des bibliothèques et des technologies auxquels l’entreprise donne accès par API. Parmi eux, Riva (traitement de la parole), cuOpt (optimisation du routage) et NeMo Retriever (récupérateur pour le RAG). Ainsi que Earth-2, qui donne accès à un jumeau numérique de la Terre pour simuler météo et climat.

Des API, il y en a désormais aussi pour la plate-forme Omniverse Cloud (conception 3D). Au nombre de cinq, entre autres pour la génération de rendus, la modification de données et le suivi des changements sur ces mêmes données.

Azure aura pendant un temps l’exclusivité d’hébergement des API Omniverse. Parmi les entreprises qui les ont déjà expérimentées figurent Dassault Systèmes et Siemens. Le premier, sur 3DEXCITE. Le second, pour son PLM Teamcenter.

Blackwell, caution hardware de la GTC 2024

Le mathématicien David Harold Blackwell fut le premier Afro-Américain membre de la National Academy of Sciences. NVIDIA a donné son nom à sanouvelle microarchitecture GPU, qui fera ses débuts cette année.

La première puce à l’implémenter – la B200 – combine deux dies de 104 milliards de transistors, pour un TDP de 1000 W.

Sur cette base, TSMC fabrique des SoC GB200. Ils associent deux GPU B200… et un CPU Grace (72 cœurs Neoverse V2), d’où le G. L’ensemble est interfacé en NVLink 5e génération (900 Go/s de débit dans les deux sens).

Par rapport à l’architecture Ampere, l’actuelle Hopper avait apporté davantage de flexibilité en prenant en charge les calculs en précision FP8. Avec Blackwell, NVIDIA franchit un palier de plus, en intégrant le FP4. Et annonce ainsi qu’un GB200 peut délivrer 20, voire 40 Pflops (avec parcimonie).

On retrouve les puces B200 autant sur la gamme HGX que la gamme DGX (en combinaison avec des processeurs Xeon).

Les GB200 entrent dans la composition de systèmes en rack à refroidissement liquide. Deux configurations : NVL36 (un rack à 18 nœuds) et NVL72 (deux racks à 18 nœuds ou un rack à 18 nœuds bi-GB200). Configurations qu’on peut intégrer à l’infrastructure SuperPOD.

On retrouve également du Blackwell dans une carte Jetson mise à contribution pour le projet Gr00t (Generalist Robot 00 Technology). Celui-ci vise à développer des modèles de fondation généralistes pour les robots humanoïdes. Il est porté par un groupe de recherche que NVIDIA avait dévoilé en février.

Gr00t utilise plusieurs briques expérimentales, dont l’orchestrateur OSMO, destiné au déploiement sur clusters Kubernetes hétérogènes (ici, DGX pour l’entraînement et OVX pour l’apprentissage continu). Divers modèles sont dans les cartons, autant à destination des bras robotisés que des robots mobiles autonomes.

Sur le même thème

Voir tous les articles Business

![Que faut-il attendre du premier CSF « logiciels et solutions [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/473403/faut-attendre-csf-logiciels-solutions-numeriques-confiance-L.jpg)