DOSSIER Datacenter: convergence des réseaux LAN et SAN, les scénarios possibles

1- La refonte du SI et du datacenter: enjeux et tendances

Introduction

Dans le contexte de la modernisation de leur SI, la plupart des entreprises travaillent à une refonte de leur ‘datacenter’, voire à une consolidation: c’est à dire une reconfiguration de plusieurs sites de traitement vers un site principal (ou quelquefois deux) et vers un site de secours pour assurer un plan de continuité de service.

Ces mêmes entreprises cherchent également à optimiser les coûts de fonctionnement et d’administration ; elles veulent diminuer la facture énergétique. Surtout, elles se concentrent sur une simplification de leur infrastructure, et ce tout en recherchant plus de souplesse, plus d’agilité, afin de déployer rapidement de nouveaux services. Certaines envisagent déjà un modèle de prestations de services « à la demande » en configuration « cloud » privé, plus rarement en ‘cloud’ public.

Comme déjà évoqué, ces entreprises en profitent pour redéfinir ou parachever leur plan continuité d’activité, avec un deuxième voire un troisième centre de données pour la sauvegarde et la restauration de leurs données sur un site « miroir » distant.

Dans ce contexte, que peut apporter la convergence des réseaux de stockage et des serveurs d’applications virtualisées à l’intérieur du ‘datacenter’ ?

Quels sont les scénarios et les offres intéressantes du marché qui permettent d’organiser cette convergence?

1- La refonte du SI et du datacenter: enjeux et tendances

2- Les scénarios de rénovation ou de migration des datacenters

Lire aussi : Big data : le cloud public, pas encore automatique ?

3- Choix d’urbanisation et retour sur investissement

4-ENTRETIEN: M. Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco‘

Partie 1- La refonte du SI et du datacenter: les enjeux, les tendances

1.1- Les investissements prioritaires, selon les cabinets d’analystes

Les évolutions techniques impactent directement l’organisation des centres de données. Selon une étude Gartner publiée en janvier 2010, portant sur les dépenses IT des grandes entreprises du secteur public et privé, et ce dans le monde entier, les principaux postes de dépense devraient avoir un effet direct sur les centres de données. Arrivent en première place des dépenses la virtualisation, suivie du ‘cloud computing’, et du web 2.0.

De fait, l’impact de la virtualisation sur la gestion des serveurs physiques à l’intérieur du data center est majeur. Passant d’un niveau de charge de 20% à parfois 80%, les serveurs physiques exigent désormais des volumes d’alimentation et de refroidissement de plus en plus importants. La mise en place de ‘clouds‘ privés et publics exige un degré d’ouverture de plus en plus important pour permettre une allocation à la demande des ressources à distance. Enfin, l’intégration d’applications riches de type web 2.0 dans les centres de données provoque une multiplication des relations stockage serveur (ne serait-ce qu’en raison de l’utilisation de nouveaux langages de type flex).

Autant de mutations qu’il faut prendre en considération sous peine de courir le risque de posséder une infrastructure sous-dimensionnée par rapport aux exigences des utilisateurs d’une part, et des nouvelles technologies d’autre part.

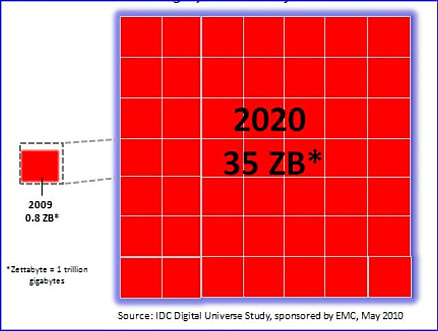

1.2- La volumétrie des data :

Multiplication des cœurs au sein même des processeurs, ponts de plus en plus fréquents entre différents clouds, reliés à la demande au centre de données principal, réplication des données vers un site distant, accroissement des connexions entre serveurs d’application et instances de stockage ; la volumétrie des centres de données est en forte croissance.

A titre d’exemple: dans le domaine de la santé, depuis 2004, le volume des données sauvegardées par le CHU de Rennes est passé de 20 à 360 To, soit une croissance multipliée par 3,3 tous les 18 mois ! Et cela ne concerne que le stockage !

–

–

1- La refonte du SI et du datacenter: enjeux et tendances

3- Choix d’urbanisation et retour sur investissement

4-ENTRETIEN: M. Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco‘

2- Les scénarios de rénovation ou de migration des datacenters

Pour moderniser, optimiser leur(s) datacenter(s), les DSI peuvent rencontrer deux cas de figure, avec des délais différents:

2.1- scénario 1: construire du neuf: ériger un tout nouveau datacenter (avec construction d’un immeuble, ou réaffectation, et réhabilitation locaux neufs, afin d’organiser un déménagement ou ré-emménagement).

Dans ce cas, les architectes du SI cherchent à anticiper la convergence des réseaux en définissant une architecture fédérative, unique autour d’un réseau de commutateurs centralisé ou « fabrique ».

Ici, la mise en place en direct d’un câblage et de connecteurs FCoE (Fibre Channel over Ethernet) prend tout son sens. Jusqu’ici, d’un point de vue technique, les disques de plusieurs serveurs sont regroupés en baies, lesquelles sont raccordées via la fibre optique. Cette dernière se retrouve démultipliée par un commutateur FC (Fibre Channel) pour connecter ensuite les cartes contrôleurs HBA (Host Bus Adapter).

Or, depuis peu, une nouvelle norme paraît devoir s’imposer pour le haut débit, sur un réseau fédérateur unique au sein du datacenter: c’est la norme du 10 Gigabits/Ethernet. Cela équivaut aux débits du FC (4, 8 ou 16 Gbps). Sur le 10 Gigabits-Ethernet s’ajoutent des possibilités de virtualisation, avec prise en compte du protocole TCP/IP et des capacités de l’Ethernet.

2.2- scénario 2: adapter l’existant et migrer progressivement vers des solutions de convergence, en procédant selon un enchaînement d’étapes logique minimisant l’impact sur la production et financièrement plus confortable.

Surtout, pendant la phase de migration se pose la question de la mise en place d’un nouveau cœur de réseau qui doit coexister avec l’ancien. Et la question de la mise à jour du câblage induit des aspects financiers qu’il faut prendre en compte.

Enfin, il faut bien noter qu’aujourd’hui, le protocole FCoE (Fibre Channel over Ethernet) n’est pas en mesure de se substituer complètement au FC (Fibre Channel). Ce peut être, tout du moins, le cas sur les serveurs-lames uniquement, car leurs châssis sont équipés dans cette logique. Mais pour les serveurs dits classiques, la question du prix se pose encore puisque les contrôleurs FC aux normes 4 Gbits/s et 8 Gbits/s restent encore moins chers que les contrôleurs FCoE.

Cependant, cette tendance tend à disparaître. Et depuis quelques années, la norme FCoE a mûri, ce qui lui permet de garantir les performances et l’intégrité des données.

Attention donc, en cas de projet de migration ou de mise à jour du centre de données, à bien prendre en considération la nature des serveurs, qui oriente sérieusement les choix financiers en matière de connecteurs.

1- La refonte du SI et du datacenter: enjeux et tendances

3- Choix d’urbanisation et retour sur investissement

4-ENTRETIEN: M. Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco‘

3 -Choix d’urbanisation et retour sur investissements (ROI)

3.1 – Quelle urbanisation pour quels scénarios?

En fonction du scénario retenu, des choix d’urbanisation vont se poser. Ils vont concerner le choix de l’architecture de câblage, l’agencement des serveurs au sein du réseau du centre de données, ou encore l’organisation du stockage.

Sur un plan dynamique, l’organisation du provisioning et du dé-provisioning devra être étudiée, ainsi que l’impact des modifications d’infrastructure sur les applications existantes. Au delà de ces aspects, c’est bel et bien l’ensemble des logiques de cycle de vie des données qu’il faut déterminer au regard de la nouvelle organisation.

Seule une étude attentive de ces différents aspects peut permettre de continuer d’assurer une qualité de service aux différents clients internes ou externes de la structure.

Surtout, l’arrivée dans le centre de données de nouvelles techniques, comme la virtualisation, demande la présence de nouveaux instruments de suivi d’activité, d’administration, et de supervision.

Dès lors, la solution FCoE (Fibre Channel over Ethernet) peut être considérée comme efficace. Ce protocole FCoE permet en effet de faire transiter les données du réseau et du stockage via une connectique unique. Les avantages de ce type d’infrastructure sont tout d’abord du côté de la consommation de temps et d’énergie. Comme chaque serveur physique utilise un connecteur unique pour le réseau et le stockage, les économies en électricité, en administration et en maintenance deviennent vite perceptibles.

Il reste à prendre en considération les nouveaux besoins de sécurité induits par la transformation du centre de données. La bonne pratique qui demandait de séparer physiquement les flux applicatifs par des câbles distincts devra être revue au profit d’une sécurisation virtualisée via une gestion des flux au niveau des consoles d’administration réseau.

Ce n’est qu’au prix de la maîtrise de tous ces éléments que la convergence réseau entre les serveurs d’application et les instances de stockage via le FCoE (Fiber Channel over Ethernet) que les gains de performances seront véritablement perceptibles, tout en conservant une sécurité optimale.

Il reste aussi à effectuer un travail non négligeable de formation auprès des équipes. On peut parler d’un changement de culture important. De fait, le stockage ne se définit plus simplement comme un service. Le dialogue entre administrateurs de stockage et administrateurs réseau doit s’établir et s’enrichir quotidiennement.

3.2 – Comment évaluer le ROI de ces ré-agencements?

La mise en place d’un réseau unique qui posséderait la rapidité de la fibre et les possibilités du TCP/IP soulève la question du retour sur investissement (ROI).

Au delà de l’économie d’énergie et de temps évoquée plus haut, le gain principal issu de la mise en place d’un réseau sur protocole FCoE tient surtout à la flexibilité qui en résulte.

Une plus grande souplesse est immédiatement perceptible sur les connexions serveur. L’administrateur n’est plus dans l’obligation de prioritiser les serveurs qui ont besoin de mémoire en les connectant au SAN des serveurs les moins gourmands. La connectique unique permet au contraire de relier l’ensemble des serveurs au stockage. Il reste donc ensuite à gérer dans la couche d’administration l’équilibrage de charge (load-balancing) en fonction des machines virtuelles installées, par exemple. D’un point de vue physique, toutes les machines ont en effet accès aux disques de stockage.

Toujours pour aller dans le sens de la flexibilité, il devient possible de remplacer un serveur web qui se sert peu du SAN, par exemple, par un serveur de base de données qui, lui, accède de manière intensive au réseau de stockage.

Chez Brocade, par exemple, les outils d’administration FCoE et de virtualisation permettent de gérer à la fois la cartographie du réseau et celle des machines virtuelles ce qui permet d’optimiser la production, le stockage et le réseau.

La maîtrise de ces outils s’avère d’ailleurs indispensable puisqu’il s’agit de suivre les bonnes pratiques au sein des centres de données. De fait, le principe d’un réseau unifié se heurte aux process en cours dans les ‘datacenters’ actuels. C’est typiquement la gestion de la sauvegarde, qui ne doit pas empiéter sur la production. Avec deux réseaux distincts, cela s’opère souvent sans difficulté. Avec un réseau unique, la question de la gestion du trafic reprend son sens et exige des règles précises.

Que peut apporter la convergence des réseaux de stockage et des serveurs d’applications virtualisées à l’intérieur du ‘datacenter’? Quels sont les scénarios et les offres intéressantes du marché qui permettent d’organiser cette convergence?

2- Les scénarios de rénovation ou de migration des datacenters

3- Choix d’urbanisation et retour sur investissement

4-ENTRETIEN: M. Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco‘

4 – ENTRETIEN EXCLUSIF

Michael Klayko, Brocade: ‘Oui, nous sommes challengers de Cisco«

Le CEO de Brocade soutient la cause des standards, face à Cisco, mais laisse ouvert le choix de la convergence de réseaux

Lors du Forum Brocade à Paris, en novembre, Michael Klayko et Dave Stevens, respectivement CEO et CTO de Brocade, se sont prêtés au jeu des questions sur la nouvelle offre de convergence VDX -dans la nouvelle architecture Brocade-One – visant à fédérer la connectivité au sein des datacenters

Brocade propose une solution de convergence au coeur du datacenter: pourquoi?

Nous lançons la première « Fabrique Ethernet » [Ethernet fabric, ou commutateur central], au coeur du datacenter, entre les serveurs de données, les baies de stockage, les diverses appliances de service. C’est une pièce fondatrice. Elle résulte de 3 années de développement.

Nous nous sommes concentrés sur la cible des grands comptes. Beaucoup de ceux qui nous font confiance nous ont incités à développer une offre de convergence au sein du datacenter.

Est-ce une stratégie qui se positionne face ou contre Cisco ?

Disons que nous sommes un challenger de Cisco. Très clairement. Mais le contexte est très contrasté. Ils peuvent être aussi partenaires. Mais c’est vrai qu’avec cette offre de convergence, nous sommes challengers.

Nous, nous cherchons à éliminer sinon à diminuer les couches [layers] qui constituent les infrastructures. Et cela pour réduire les coûts. C’est d’ailleurs là le principal levier de la virtualisation des systèmes.

J’ajouterai que Cisco a lancé son offre UCS avec VMware. Eh bien, nous aussi, nous travaillons étroitement avec VMware.

Nous voulons nous positionner comme fournisseur à « guichet unique », notamment auprès des PME. Car, du fait que nous avons démarré très tôt, nous avons toujours suivi une démarche d’intégration, en développant ce qu’il y a de meilleur, l’état de l’art du moment. C’est là que nos clients, OEM ou non, reconnaissent notre expertise.

S’agissant de la connectivité -Infiny Band, Fibre Channel, Iscsi…-, nous avons une expertise de 10 ans sur ces technologies; elles sont très fiables, très stables. Le stockage par blocs, c’est solide comme le roc!

Et avec l’acquisition de Foundry Networks, nous avons accru notre expertise dans le Giga-Ethernet.

Nous nous appuyons aussi sur notre large base de clients. Nous collaborons étroitement avec eux pour perfectionner nos solutions.

Vous affichez ouvertement votre soutien en faveur des « standards ». Est-ce, là encore, face à Cisco?

Nous avons toujours développé une offre ouverte, qui repose sur les standards. Nous contribuons directement au développement des standards. Nous avons des équipes qui travaillent au sein des commissions ou groupes de travail de l’IEEE et de l’IETF, notamment.

Au total nous avons 18 personnes qui y contribuent et certains de nos experts président des groupes de travail.

Vous militez notamment en faveur d’Ethernet ?

Oui, le Giga-Ethernet se confirme comme le protocole le plus apte, le plus efficace et le plus économique notamment pour optimiser des infrastructures de ressources virtualisées.

Nos clients nous le demandent. Ils constatent que la virtualisation des serveurs ou des systèmes de stockage apporte de la complexité.

Notre proposition consiste à simplifier les architectures. Nous fournissons un réseau permettant d’optimiser et de fluidifier l’environnement virtualisé.

Entre la connectivité Fibre Channel et le Gigabit-Ethernet, c’est selon nous une perspective sur 5 à 10 ans pour l’agencement et la refondation des datacenters. Car la virtualisation des systèmes ne va pas s’arrêter là. Evidemment, non!

Est-ce que cette convergence que vous préconisez intéresse tout le monde?

Pour un grand nombre d’entreprises, nous pensons qu’il y a des avantages évidents à réaliser cette convergence de réseaux, autour d’une connectivité unique, une infrastructure unique.

Mais il est vrai que pour certains clients, les avantages ne sont pas garantis ou pas suffisants au regard de la qualité de service escomptée. C’est une question de ratio avantages sur coûts.

Nous laissons le choix totalement ouvert à nos clients. Nous savons que cela dépend de leur environnement, de leurs applications, du nombre d’I/O (entrées/sorties), donc selon leurs besoins d’accès aux serveurs et aux baies de stockage.

Cela dépend des applications. S’il s’agit d’énormes bases de données, très sollicitées, mieux vaut privilégier des gros tuyaux [‘pipes’] Fibre Channel dédiés.

S’il s’agit d’applications de taille moyenne, comme les ressources humaines, avec relativement peu d’accès et des volumes de données traitées, une infrastructure convergée se justifie tout à fait.

Un bon nombre d’entreprises ne veulent pas d’un réseau unifié ou « convergé ». Elles recherchent avant tout une infrastructure très sécurisée. Certaines vont choisir de maintenir la cohabitation de deux infrastructures.

Et le ‘cloud computing’ a-t-il une incidence dans ces choix?

Oui, puisque cela repose sur la virtualisation. Mais quelles sont les stratégies d’implémentation? On sait, techniquement, comment virtualiser, mais cela implique de re-architecturer l’existant.

C’est une bonne occasion de le faire en s’efforçant de simplifier l’infrastructure, en supprimant des couches réseau non indispensables. L’objectif est toujours le même! Diminuer les coûts tout en augmentant les fonctionnalités et la souplesse au changement.

_____________________________________________

Quelques précisions intéressantes…

Dans un entretien avec notre confrère StorageNewsletter, Michael Klayko apporte quelques précisions:

Dans la simplification, vous incluez le câblage?

Oui, nos nouveaux adaptateurs réseau permettent de virtualiser les connexions. Ainsi, nous pouvons éliminer beaucoup de câblage. Il y a aussi une simplification avec une concentration sur les ‘switchs’ (commutateurs) en ‘top-of-the rack’, ce qui conduit à plus de densité de connexions et donc moins de câbles.

Mais finalement, vous recommandez plutôt le Fibre Channel (à 4, 8 ou 16 Gbps?) ou le 10 Gigabit-Ethernet?

Les utilisateurs de larges configurations de stockage vont continuer de se fier au Fibre Channel car, pour eux, c’est le standard de facto. Sur le trimestre écoulé, nous constatons que 94% du Fibre Channel livré est déjà en 8 Gbps. Donc le FC en 16 Gigas deviendra populaire un jour aussi.

Mais le protocole FCoE n’est-il pas supposé amener les entreprises à migrer du Fibre Channel vers Giga-Ethernet?

Non. C’est une option. Nous avons toujours dit que le FCoE ne serait pas le « mainstream » de notre marché avant 2012, et donc nous voyons toujours plus d’installations Fibre Channel sur le stockage, pour le moment.

Source: StorageNewsletter 2 déc. 2010. https://www.storagenewsletter.com/news/business/brocade-ceo-mike-klayko-interview

_____________________________________________

Dave Stevens, CTO de Brocade: « Il faut renforcer l’infrastructure«

« Dans beaucoup d’entreprises, l’infrastructure n’est pas suffisante pour traiter de nouvelles applications. Elle n’est pas assez flexible pour être gérable dans un monde où les applications sont mobiles.

Les réseaux des datacenters doivent passer au niveau supérieur pour augmenter la performance, pour réduire le temps de latence et éliminer les temps d’interruption.

Ces réseaux doivent également supporter des environnements avec beaucoup de virtualisation, optimisés pour le ‘cloud’.

Avec Brocade One, nous apportons une simplification considérable aux réseaux. Nous augmentons l’évolutivité sans introduire de complexité supplémentaire.

Aujourd’hui, les commutateurs Brocade VDX, basés sur la technologie VCS de Brocade, fournissent de véritables réseaux optimisés pour le ‘cloud’

__________________________________

Les réseaux de stockage SAN et les machines virtuelles : quelles incidences?

Sur les réseaux SAN, Brocade revendique avoir été le premier à développer des architectures réseau en ‘fabrique’ et ce depuis 2000. Dans le même temps, Brocade a développé les premiers ‘switchs’ embarqués, sur des serveurs ‘blades’. IBM, Intel, Bull, HP, Dell, Hitachi et Fujitsu, ont rallié ce choix technologique.

Aujourd’hui, l’option de ‘switch’ virtuel embarqué avec l’hyperviseur (VMware, Xen, Hyper-V, KVM, …) se confirme comme pertinente. Deux cas de figure se présentent:

– soit la fonction réseau est intégrée à l’hyperviseur, et s’exécute au niveau du serveur hôte physique

– soit il y a externalisation au niveau des adaptateurs CNA (EVB) et ‘switch’ d’accès physiques (VEPA) Standards du marché: VEPA, VEB ; cette externalisation s’applique notamment dans le cas de stratégies de qualité de service ou ‘SLA’ déterministes (dans le cas d’applications critiques)

A noter que Brocade, outre la fourniture de commutateurs Ethernet et FC, dispose d’adaptateurs HBA et CNA pour les serveurs. [cf : Brocade 1010 et Brocade 1020 FCoE/CEE Converged Network Adapters (CNAs); ils apportent un niveau supérieur de consolidation d’I/O de serveurs ; ils intègrent de façon transparente les environnements Fibre Channel et Ethernet]

Brocade propose également des adaptateurs CNA, de 2è génération. IBM et Dell ont déjà prévu de les mettre à leur catalogue.

De son côté, Cisco propose de remplacer le « commutateur virtuel » VMware par un produit logiciel ; ce qui suppose des licences supplémenataires, incrémentales.

__________________________________

La virtualisation des serveurs et la mobilité des machines virtuelles

La virtualisation sur le SAN soulève quelques problèmes spécifiques. Ainsi, comment garantir les niveaux de flux si l’on déplace les machines virtuelles à grande distance, la latence du réseau se faisant ressentir?

Dans la phase de configuration et définition des machines virtuelles (les ‘VM’), il est relativement facile de maîtriser le ‘provisioning’ utile.

Mais ensuite, comment nettoyer les machines virtuelles qu’on a laissé proliférer? Il faut localiser les différentes instances qui se sont enchaînées. Il faut disposer d’une cartographie des VM à un instant ‘t’.

D’où l’intérêt d’un protocole comme AMPP (Automatic Migration of Port Profiles) : il permet de propager l’information des configurations des VM. Chez Brocade, c’est une fonction VCS qui véhicule les caractéristiques des VM, (ressources qui lui sont nécessaires). Les mêmes paramètres (adresse MAC, filtres, gateway, attributs de qualité de service, de sécurité…) doivent suivre; toutes ces informations sont propagées.

Brocade le fait au sein de sa ‘fabric’.

Localisation des datacenters et proximité des données

Les données doivent être au plus près de l’utilisateur. C’est ce qui conditionne l’installation de plusieurs datacenters ou sites d’hébergement sur un ou plusieurs continents. C’est pourquoi Brocade propose le ‘load balancing’ ou le chiffrement des data en mode « dérivation » vers des appliances dédiées (conçues autour d’ASICs développés par Brocade ; cf. ADC ou Application Delivery Controller ). Ainsi, la fonction ‘load balancing’ peut être utilisée localement mais aussi de manière distribuée (protocole GSLB, Global Server Load Balancing), la charge étant répartie sur plusieurs sites (cf. les plans de continuité PCA, PRA …).

_______________________________________________________________ FIN / DOSSIER _____

Sur le même thème

Voir tous les articles Cloud