Ce qu'il faut savoir sur Moshi, l'IA vocale de Kyutai

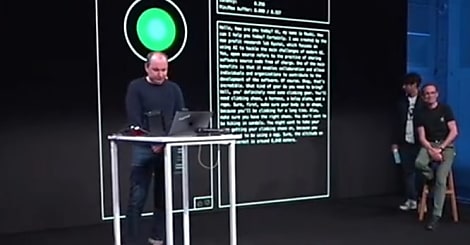

Kyutai a officialisé son IA vocale Moshi et en a ouvert une démo au public. Voici quelques éléments à son sujet.

Que peut-on produire avec 1000 GPU ? Chez Kyutai, la réponse s’appelle Moshi. Il a fallu six mois pour développer cette IA vocale. La voilà ouverte au public, en tant que prototype.

Qui a développé Moshi ?

Officiellement, huit personnes se sont impliquées. Toutes ont pris part à la présentation officielle, ce 3 juillet 2024. Parmi elles, les six scientifiques qui composaient l’équipe initiale : Alexandre Défossez, Édouard Grave, Hervé Jégou, Laurent Mazaré, Patrick Pérez et Neil Zeghidour (cf. notre article à leur sujet). S’y ajoutent Emmanuel Orsini et Amélie Royer. Le premier, diplômé de Polytechnique et Télécom Paris est un ancien de Google/Deepmind. La seconde, passée par l’ENS Rennes et l’Institut autrichien des sciences et technologies, a précédemment travaillé chez Qualcomm.

Pourquoi ce nom ?

« Moshi moshi », c’est le « allô » japonais. On est dans la lignée de « kyutai », qui signifie « sphère » dans cette même langue.

Quelle est la raison d’être de Moshi ?

Il s’agissait de fusionner en un réseau de neurones le pipeline complexe des IA vocales actuelles (détection de parole, transcription textuelle, génération d’une réponse texte, puis synthèse vocale). Autant pour réduire la latence que pour conserver des éléments que la modalité texte fait perdre (émotions, intonations, hésitations, acoustique…).

Comment Kyutai a-t-il entraîné Moshi ?

Kyutai est parti d’un LLM maison (Helium) à 7 milliards de paramètres. Il l’a d’abord entraîné exclusivement sur du texte, pour lui faire acquérir des connaissances.

La deuxième phase a reposé sur un mix de texte et d’audio annoté afin que le modèle en apprenne une représentation commune.

À ce stade, Moshi ne savait pas encore tenir une discussion : il générait un flux continu. On l’a donc ajusté, sur des données synthétiques : 100 000 transcriptions de conversations générées par Helium et passées à la moulinette d’un moteur text-to-speech.

Pour donner une voix à Moshi, Kyutai a eu recours à une actrice audio. Son modèle gère aujourd’hui plus de 70 émotions et styles de discours, affirme-t-il.

Moshi fonctionne-t-il en local ?

Kyutai a promis de publier le code et les poids de Moshi. En attendant, il en propose une démo en ligne, pour des conversations en anglais de 5 minutes max. On peut régler certains paramètres, dont la température et le top_k à la fois pour le texte et l’audio.

Dans sa version cloud, Moshi a une latence d’environ 200 ms – en particulier parce qu’il est capable de parler et d’écouter en parallèle, grâce à l’usage de deux flux audio. Pour le rendre utilisable hors ligne, Kyutai a travaillé à compresser le modèle et l’historique de conversation. Le défi réside, selon A. Royer, dans l’équilibrage du texte et de l’audio, qui se comportent différemment après quantisation.

Lire aussi : IA génératives : qui a l'UI la mieux écoconçue ?

Kyutai a aussi développé son propre codec audio, qui sait capturer les caractéristiques sémantiques et compresse en 300:1 par rapport au MP3. Ses équipes ont effectué une courte démo sur un MacBook Pro.

Comment détecter du contenu généré par Moshi ?

Kyutai explore deux approches. D’une part, une base de signatures extraites des audios. De l’autre, une forme de filigrane inaudible.

Au-delà d’un modèle, Moshi est un framework adaptable à des tâches, clame Kyutai. Il en a donné un exemple fondé sur l’affinage à partir de conversations téléphoniques collectées aux États-Unis entre 1994 et 2002 (dataset Fisher).

Sur le même thème

Voir tous les articles Data & IA