MLPerf s'ouvre aux LLM : Oracle et Microsoft au rendez-vous

MLPerf a ajouté du résumé de texte dans son benchmark d'inférence. Quels systèmes ont le mieux performé dans la catégorie principale ?

Microsoft, NVIDIA, Oracle et Supermicro dans un mouchoir de poche ? Oui, dans le cadre d'un des tests du dernier benchmark MLPerf Inference.

Le test en question est une nouveauté. Son principe : résumer du texte sur le dataset CNN/DailyMail avec le modèle GPT-J 6B. Il marque l'entrée des LLM au sein dudit benchmark, quelques mois après l'intégration de l'IA générative dans MLPerf Training.

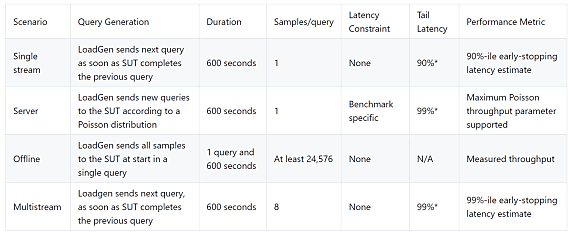

Les résultats de la catégorie principale (environnement datacenter, modèle imposé) sont présentés sur deux objectifs de qualité (99 % et 99,9 %). Ils sont par ailleurs séparés selon la méthode de chargement des requêtes : ou bien selon une distribution de Poisson (« serveur »), ou bien en lot (« hors ligne »).

Lire aussi : MLPerf : la quête de benchmarks IA représentatifs

Méthode serveur, précision 99 %

Sur cette configuration, le meilleur score revient à un système Supermicro. Doté de 2 Xeon Platinum 8468 et de 8 GPU H100 SXM-80, il a atteint 85,57 requêtes par seconde.

Un autre système Supermicro avec les mêmes GPU mais en EPYC 9554 a atteint 84,50 r/s. Une VM Azure ND H100 v5 (2 Xeon 8480C, même GPU) complète le podium, à 84,22 r/s.

Méthode hors ligne, précision 99 %

Le système Supermicro le plus performant en méthode serveur l'est aussi en méthode hors ligne. Il atteint 107,33 échantillons par seconde.

Arrive ensuite une VM Oracle (2 Xeon 8480+, toujours les mêmes GPU), mesurée à 106,69 é/s. Suit un NVIDIA DGX H100 (2 Xeon Platinum 8400C, mêmes GPU), à 106,32 é/s.

Méthode serveur, précision 99,9 %

On retrouve le même top 3 qu'à 99 % de précision. Les scores sont identiques, sauf pour le système Supermicro, légèrement moins performant (85,43 r/s).

Méthode hors ligne, précision 99,9 %

On prend les mêmes et on recommence... mais dans un autre ordre. La VM Azure s'en tire le mieux, à 107,56 é/s. Elle devance le principal système Supermicro et le serveur NVIDIA.

À consulter en complément :

OpenAI : gare à l'obsolescence

IA et données publiques : Google joue carte sur table

Comment Netflix a conçu son infrastructure de machine learning

Vers une pénurie de données d'entraînement pour l'IA ?

Formation et recherche en IA : ce qui gêne la Cour des comptes

llustration principale © KanawatVector - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA

![Déployer l'IA à l'échelle : l'approche d'AXA, entre vision et [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/473364/deployer-echelle-approche-axa-L.jpg)