Tribune Big Data : hors Hadoop, point de salut

En moins de quatre ans, le framework open source Hadoop est devenu hégémonique sur les solutions de type Map Reduce, étouffant toute concurrence propriétaire. Une tribune signée Romain Chaumais d'Ysance.

Romain Chaumais, cofondateur d'Ysance et responsable de son pôle business intelligence, retrace pour nous l'historique du Big Data, expliquant par la même occasion comment une solution open source, Hadoop, a pu s'imposer sur ce marché.

Le monde des moteurs de traitement de données de type Big Data a déjà bien changé, depuis ses récents débuts. Il y a peu, celui-ci était globalement scindé en deux. D'un côté, les moteurs spécialisés qui offrent une optimisation maximale, via une structuration et un stockage des données en colonnes par exemple, et permettent des requêtes analytiques ensemblistes propices aux applications de type décisionnel. Ce sont les « coupés sport » de la base de données, composés d'acteurs tels que Sybase IQ, Vertica, Infobright, Vectorwise, Calpont.

De l'autre côté, les moteurs de traitement de données de type Appliance MPP (Massive Parallel Procesing) qui sont davantage adaptés aux grands datawarehouses d'entreprise pour des usages aussi bien transverses que métiers (EDW). Ils centralisent le patrimoine d'informations de l'entreprise et autorisent une organisation des données relativement souple. Ce sont les « semi-remorques » de la base de données, certes plus puissants, mais moins abordables que les moteurs spécialisés. S'y côtoient Teradata, Oracle (Exadata), ou encore IBM (Netezza).

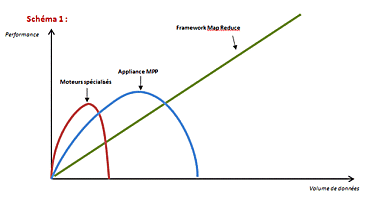

Si ces deux approches répondent à des usages bien réels, elles peinent à traiter la jungle des données structurées et non structurées désormais produites : commentaires sur les réseaux sociaux, mobilité, machine-to-machine, trafic web. Stratégique pour l'entreprise, cette masse croissante d'informations recèle une réelle valeur économique, mais dépasse très largement la capacité des moteurs de traitement traditionnels. Autrement dit, ces derniers ne sont déjà plus adaptés à la gestion intensive de pétaoctets de données. C'est là qu'interviennent les frameworks de type Map Reduce, dont l'approche consiste à explorer, puis à révéler des données chaudes, brutes et potentiellement non structurées. Au prix d'une moindre performance par CPU et d'une relative inertie dans les traitements, la quantité de données traitables est ici démultipliée à l'infini (cf. schéma 1), comme une motrice dont on pourrait accrocher autant de wagons qu'on le souhaite.

Ce nouveau monde est bien différent des deux précédents. Alors que plusieurs éditeurs se partagent historiquement le marché des moteurs de traitement de données de type SGBD, Hadoop s'impose d'ores et déjà comme le principal et incontournable moteur de type Map Reduce. Rappel des faits. En 2008, Google publie l'algorithme de son framework Map Reduce, dont Yahoo propose un clone open source. Hadoop est né. Ce moteur, qui fonctionne sur un système de fichiers répartis sur plusieurs machines physiques (HDFS), reprend les grands principes de l'algorithme Map Reduce en Java.

Sur le même thème

Voir tous les articles Data & IA