AWS Summit : le RAG, au carrefour des stratégies GenAI

Les choix technologiques s'affirment en matière de RAG. Veolia, Qonto et Bureau Veritas en ont témoigné à l'occasion de l'AWS Summit Paris 2025.

Et vous, comment est votre RAG ? D'une édition à l'autre de l'AWS Summit Paris, la parole s'est affirmée sur ce sujet, témoignant de choix technologiques.

Signe d'une certaine maturité, on entend désormais parler de RAG "avancé"... et pas que du côté des fournisseurs. Les stratégies apparaissent plus claires sur l'ensemble de la chaîne, de la vectorisation des documents à leur récupération.

Les positions sont par ailleurs plus tranchées vis-à-vis solutions alternatives. En premier lieu, l'affinage ou ajustement des modèles (fine-tuning). "Un LLM de dernière génération avec un RAG bien configuré peut donner des résultats aussi bons, voire souvent meilleurs, et il sera plus facile à maintenir en production", selon Fouad Maach, directeur de l'architecture et de l'ingénierie de Veolia.

Le RAG au coeur de Veolia Secure GPT

En septembre 2023, le groupe aux 218 000 employés et 45 M€ de chiffre d'affaires avait ouvert à tous ses collaborateurs l'application Veolia Secure GPT. Qui regroupait alors trois services (chat avec sélecteur de modèle, interrogation de documents et traduction).

Ouverte aux équipes IT par API le mois suivant, elle s'était ensuite enrichie de deux briques. D'une part, de la génération d'images. De l'autre, de la "base de connaissances à grande échelle". Autrement dit, un RAG.

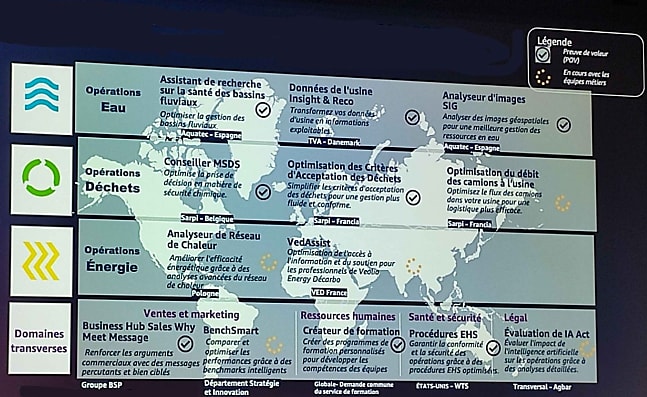

Entre autres évolutions, ce RAG fut doté du chargement incrémentiel. C'était en juillet 2024. Les premières expérimentations agentiques venaient alors de démarré. Elles aboutiraient au lancement d'une plate-forme d'assistants (flux de travail multi-agents) au mois d'octobre.

Pour présenter son approche, Veolia la segmente en trois niveaux. Au premier se trouvent les assistants destinés à fournir des conseils généraux. Ils reposent sur des données d'entraînement publiques et utilisent un prompt système personnalisé. Au deuxième niveau, le RAG vient s'ajouter au prompt système personnalisé. Par exemple, pour un assistant de formation en temps réel des nouveaux opérateurs en stations d'épuration (utilisation de la documentation spécifique de l'usine).

Le troisième niveau associe base de connaissances et analyse de données. Par exemple, de séries temporelles, toujours sur la base de la doc d'usine. "Les données peuvent être requêtées en mode text-to-SQL en allant attaquer le data warehouse, mais aussi par API en consommant les données dans une application, explique Fouad Maach. Activée en lecture seule l'an dernier, cette passerelle fonctionne maintenant aussi en écriture, détaille l'intéressé. Et de donner trois exemples, du plus simple au plus complexe :

- Un appel sur une plate-forme bureautique pour envoyer par e-mail le contenu d'une discussion

- L'insertion, dans une base de type lakehouse, de données issues d'une analyse

- La soumission d'un ordre d'achat à un ERP sans quitter l'assistant

Du point de vue architectural, les assistants sont des graphes de type LangGraph. Chacun, à l'exception du superviseur, est configuré avec un LLM, un toolkit et peut prendre des décisions de routage. Diverses technologies open source portent l'ensemble, conteneurisé. Outre le duo LangChain-LangGraph, on retrouve le framework Unstructured. Et, pour le RAG, Postgres avec l'extension pgvector. S'y ajoute dorénavant le protocole MCP, toutefois pas encore en production. Fouad Maach y voit "peut-être une révolution" qui, en tout cas, permettra de démultiplier les cas d'usage, en créant un pont avec la plate-forme d'API management de Veolia.

Au dernier pointage, ils sont 60 000 à utiliser au moins une fois par mois la plate-forme. Dans une démarche d'open source intra-entreprise, toutes les équipes IT peuvent contribuer au code. Les métiers sont quant à eux formés pour créer, configurer, tester et publier de manière autonome leurs assistants.

Bureau Veritas : "On aura toujours besoin du RAG"

Chez Bureau Veritas, on en est arrivé à la même conclusion que Veolia concernant le fine-tuning. Pour les cas d'usage ciblés, il n'est pas pertinent. "On ne voit pas du tout l'intérêt de réentraîner un modèle avec une base documentaire qui sera obsolète quelques semaines plus tard", affirme Édouard Lagrue, Group Robotics & AI Manager.

L'aide à la recherche documentaire est effectivement la principale raison d'être de l'assistant Jules, sur lequel Bureau Veritas travaille depuis un an et demi. Reposant sur des modèles Anthropic, il fédère, aux dernières nouvelles, 21 000 utilisateurs uniques pour 3000 utilisateurs quotidiens.

Vu leur technicité et leur structure spécifique, les documents amenés à constituer la base de connaissances ne sauraient être coupés aléatoirement avant vectorisation, explique Édouard Lagrue. Pas de chunking à taille fixe, donc.

Quant à l'intérêt du RAG à l'heure où les fenêtres de contexte des plus gros modèles atteignent des millions de tokens : "On travaille sur des documents qui font plus de 3000 pages et des corpus qui comprennent plusieurs centaines de documents. C'est super d'avoir une fenêtre de contexte plus grande, mais on aura toujours besoin du RAG au sein de notre activité."

Dans le même esprit que chez Veolia, Bureau Veritas a mis en place un "studio" qui permet à chacun de créer un assistant avec son prompt et son RAG (documents uploadés ou base contextuelle), puis de le partager.

De même, Jules a une API. C'est là que réside la véritable valeur du RAG, affirme Édouard Lagrue : son utilisation via un assistant est "la partie visible de l'iceberg". Pour en améliorer la qualité, l'entreprise explore la technique du LLM as a judge (évaluation automatique sans avoir à utiliser ses propres datasets). Elle s'intéresse aussi aux bases de données de graphes. Édouard Lagrue attend beaucoup de cette forme de représentation des corpus par des concepts de haut niveau. Il y perçoit une manière de limiter la dilution de l'information à mesure qu'augmente le volume de documents.

Chez Qonto, un RAG sur données publiques

Chez Qonto, le RAG trouve notamment sa place dans un processus agentique associé à la fonctionnalité de paiement fractionné. Trois agents interviennent l'un après l'autre pour étudier les demandes. Leurs tâches respectives : lecture de la facture, recherche d'informations extérieurs et application des conditions d'utilisation.

À partir des informations extraites de la facture, l'agent de recherche doit trouver plusieurs éléments à propos de l'entreprise demandeuse (réputation, nombre d'employés, adresse, propriétaire(s)...). Parmi les sources auxquelles il a accès figure une API qui collecte des infos de l'INPI (Institut national de la propriété intellectuelle) à partir d'un SIRET/SIREN. Il y a aussi Serper, un outil qui récupère des recherches Google sous une forme prête à utiliser par des LLM.

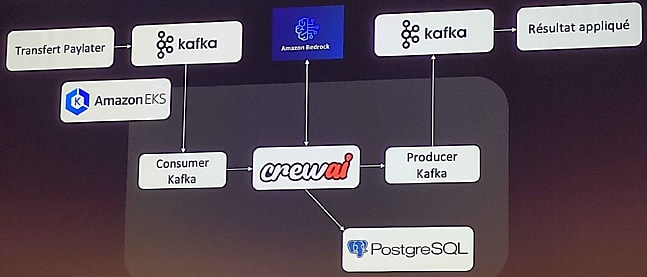

Pour ce use case, Qonto a recours aux modèles d'Anthropic. "Plutôt Haiku pour la recherche, plutôt Sonnet 3.7 pour la vision et la décision", glisse Bastien Roland, ML engineer. Les transferts arrivent sur un topic Kafka et l'application appelle CrewAI - préféré à LangChain - qui lui-même appelle Amazon Bedrock. Le résultat, est stocké sur PostgreSQL, renvoyé dans le topic Kafka et appliqué. Un quart du flux est aujourd'hui automatisé (objectif : 80 % pour la fin du premier semestre 2025). Sur ces demandes, le temps de réponse moyen est passé à 5 minutes, contre 6 heures auparavant.

Mille et une recettes de RAG

Parmi les méthodes alternatives au chunking à taille fixe, il y a la segmentation récursive (sur la base de caractères), sémantique (découpage en phrases puis regroupement par similarité) ou hiérarchique (chaque noeud contient un résumé de sa hiérarchie).

Sur la partie recherche, l'exploitation des graphes de connaissances (GraphRAG) peut être intéressante dans les cas où on a affaire à de multiples entités connectées et/ou à un vocabulaire technique difficile à comprendre par un algorithme sémantique.

On peut aussi ajuster la récupération. Autant en la pondérant dans le temps qu'en adoptant une approche hiérarchique (recherche rapide au niveau des documents enfants, mais récupération du document parent pour obtenir un contexte général).

Post-récupération, on pourra appliquer un reclassement (reranking) ou des filtres de métadonnées.

Illustration principale générée par IA

Sur le même thème

Voir tous les articles Data & IA