DeepSeek, l'électrochoc IA venu de Chine

En quelques semaines, la start-up chinoise DeepSeek s'est établie en exemple d'optimisation sous contrainte pour le développement de LLM.

L'IA open source a-t-elle dépassé l'IA propriétaire ? Ce sujet fut, la semaine dernière, au programme du Paris Open Source AI Summit.

Difficile, pour les intervenants, de ne pas mentionner DeepSeek. La start-up chinoise venait de publier ses premiers modèles "de raisonnement", dits R1-Zero et R1.

L'entraînement du modèle DeepSeek-V3, dont dérivent R1-Zero et R1, n'a nécessité qu'un peu plus de 2000 GPU, et pas les plus puissants de chez NVIDIA, a notamment fait remarquer Stéphane Requena, CTO du GENCI (Grand équipement national de calcul intensif). Jamal Atif, directeur scientifique de l'institut PRAIRIE, lui a fait écho : "DeepSeek a montré qu'on pouvait faire, avec de bonnes compétences, ce qu'on n'imaginait pas il y a 3 mois."

De DeepSeek-V3 à DeepSeek-R1 : un modèle peut en cacher un autre

DeepSeek a émané d'un fonds spéculatif. En l'occurrence, High-Flyer, fondé en 2015 par des ingénieurs de l'université du Zhejiang. Au printemps 2023, il avait formé un labo de recherche sur l'AGI, séparé de ses activités financières. Quelques semaines plus tard, cette structure allait se constituer en start-up. En novembre 2023, elle publia son premier modèle (sous licence MIT, y compris pour l'usage commercial) : DeepSeek-Coder. Puis elle ouvrit un chatbot. DeepSeek-V2, lancé au printemps 2024, avait stimulé une guerre des prix entre fournisseurs de LLM chinois. DeepSeek-V3 est arrivé en décembre 2024. Son entraînement a duré environ 2 mois, sur 2048 GPU, pour un coût estimé à moins de 6 M$.

Lire aussi : Comment DeepSeek en est arrivé à ses derniers LLM

DeepSeek (Chinese AI co) making it look easy today with an open weights release of a frontier-grade LLM trained on a joke of a budget (2048 GPUs for 2 months, $6M).

- Andrej Karpathy (@karpathy) December 26, 2024

For reference, this level of capability is supposed to require clusters of closer to 16K GPUs, the ones being... https://t.co/EW7q2pQ94B

DeepSeek avait donné un premier aperçu de ses modèles de raisonnement en novembre 2024, sur son interface de chat. Elle y avait intégré DeepSeek-R1-Lite, dit au niveau des performances d'o1-preview sur les benchmarks AIME et MATH.

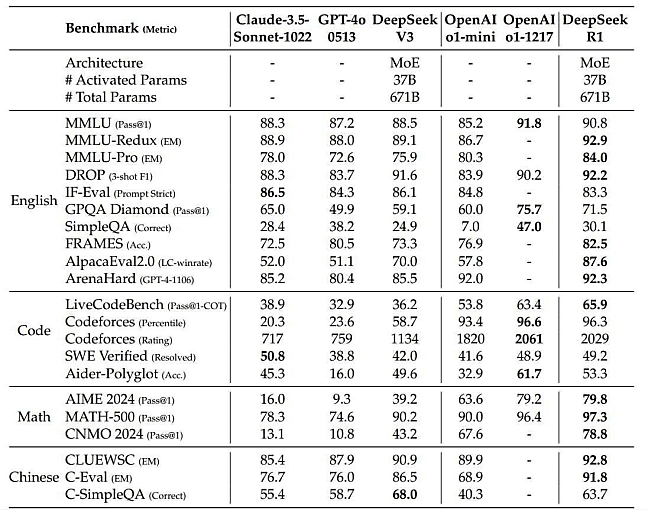

Avec R1, on est désormais au niveau d'o1 tout court, affirme DeepSeek. Le modèle, en open weights, est aussi utilisable sur l'API. Si V3 est son socle (y compris pour l'architecture MoE, avec 37 milliards de paramètres actifs sur 671 milliards), les capacités de raisonnement ont été améliorées, en recourant non pas à du fine-tuning supervisé mais à de l'apprentissage par renforcement.

Pour diminuer les coûts d'entraînement, DeepSeek a utilisé l'algorithme GRPO (Group Relative Policy Optimization). Lequel ne s'appuie sur des modèles critiques, mais sur l'évaluation de groupes de réponses les uns par rapport aux autres. Il y a ajouté un mécanisme de récompense basé sur deux types de règles orientées précision et format. Dans ce setup, arrive un moment, au cours de l'inférence, où le modèle a une forme de "révélation" : il commence à allouer davantage de temps de réflexion à certains problèmes et à réévaluer son approche initiale.

Une touche d'entraînement supervisé

Tel quel, le modèle - qui correspond à R1-Zero - a tendance à se répéter, à mélange les langues et à ne pas structurer idéalement certaines réponses (absence de Markdown, en particulier). On lui greffe donc un pipeline d'entraînement à plusieurs étapes. Dans les grandes lignes :

- Ajustement préalable de V3 avec un petit volume de données de chaîne de pensée (CoT)

DeepSeek a exploré plusieurs approches pour collecte ces données : prompting avec injection de CoT en exemple, récupération des outputs de R1-Zero en un format lisible, annotation par des humains... L'ensemble permet au modèle de ne pas démarrer "à froid" l'apprentissage par renforcement. - Apprentissage par renforcement orienté raisonnement, avec le même processus que pour R1-Zero. Pour éviter le mélange des langues dans la chaîne de pensée, on ajoute - au prix d'une légère dégradation de performance - un mécanisme récompensant la cohérence linguistique.

- Utilisation de ce checkpoint pour collecter des données supervisées dans des domaines de type écriture, traduction, jeu de rôles, Q&A factuel, etc.

Pour les données servant au raisonnement, DeepSeek a collecté environ 600 000 exemples. Pour les autres, environ 200 000. Il a fait travailler V3 sur ce dataset pour deux cycles. - Deuxième apprentissage par renforcement, élargi à tous les scénarios, pour aligner le modèle sur les préférence humaines.

De ce processus découle R1. DeepSeek en souligne particulièrement les performances sur le benchmark FRAMES (Q&A sur long contexte).

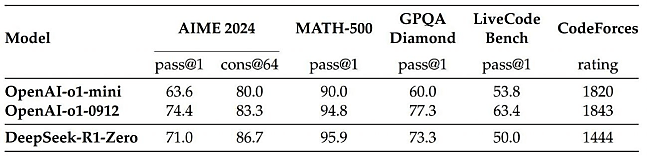

Pour ce qui est de R1-Zero, DeepSeek met en avant les performances sur le benchmark AIME 2024. En pass@1, le score passe de 15,6 % à 71 % une fois l'apprentissage par renforcement achevé. Avec un système de vote à la majorité, la performance atteint 86,7 %, dans les eaux d'o1-0912.

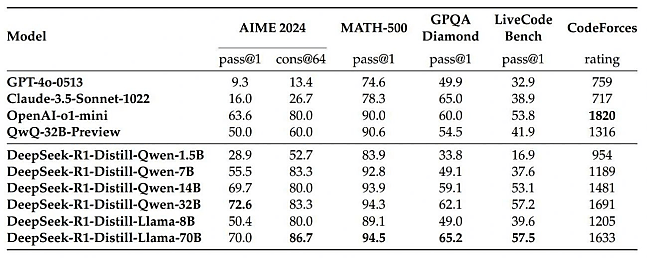

Distillation sur des modèles Qwen et Llama

Le dataset en question a aussi été expérimenté pour affiner six modèles Qwen et Llama (Qwen2.5-Math 1.5B et 7B, Qwen2.5 14B et 32B, Llama 3.1 8B, Llama 3.3 70B Instruct). Leurs capacités de raisonnement s'en sont trouvées améliorées plus nettement qu'avec de l'apprentissage par renforcement ; tout en exigeant moins de puissance de calcul.

Au-delà de l'entraînement, l'inférence semble aussi consommer moins de ressources que pour les modèles concurrents. Les prix sur l'API peuvent être un indice dans ce sens. Le modèle dit DeepSeek-Reasoner (basé sur R1) revient à 0,55 $ par million de tokens en entrée (ou 0,14 $ si récupération en cache) et 2,19 $ par million en sortie. À comparer aux tarifs d'o1 : 15 $ par million de tokens en entrée et 60 $ par million en sortie. Ou à ceux de Claude 3.5 Sonnet : 3 $ par million de tokens en entrée et 15 $ par million en sortie.

L'annonce de R1 a potentiellement eu un effet sur les valeurs boursières de NVIDIA et de certains de ses partenaires. Si ce n'est plus globalement dans l'industrie des semi-conducteurs.

Illustration générée par IA

Sur le même thème

Voir tous les articles Data & IA

![Gouvernance des communications : qui se distingue sur ce marché [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/472883/gouvernance-communications-distingue-marche-L.jpg)