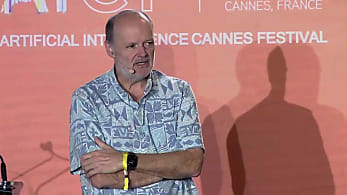

Luc Julia : « L’IA générative n’est pas une révolution des IA, mais une révolution des usages »

Pour Luc Julia, inventeur de Siri, l’essor des IA génératives n’est pas une révolution qui nous mènera vers une IA forte. Il lui reconnaît toutefois une vertu : le prompt.

Aujourd’hui directeur scientifique de Renault, Luc Julia conteste la vision des médias qui font de ChatGPT et plus largement des IA génératives une révolution.

« Il s’agit simplement de plus de données et de plus de puissance de calcul. Je ne dirais pas qu’il s’agit d’une révolution, mais elle impliquera sans doute encore plus de calcul et plus de données. Or il faut s’interroger sur l’énergie que cela consomme et ce n’est sans doute pas une tendance à poursuivre car nous devons penser à la planète ! » déclarait le créateur de Siri lors de l’événement WAICF.

Pour cette sommité, l’IA générative s’inscrit en droite ligne du Machine Learning et du Deep Learning. « Quand on parle de Machine Learning, si on remonte aux années 80/90, il s’agissait essentiellement de faire de la reconnaissance. Le premier modèle fut dédié à la reconnaissance de chats. A partir de 100 000 images de chats, on pouvait reconnaître un chat sur une photo alors qu’il faut 2 images à un humain pour apprendre à identifier un chat… Beaucoup de données pour un petit résultat ! »

Là où le Machine Learning met en œuvre de l’ordre de 1 000 à 1 million de données, le Deep Learning en met en œuvre plusieurs millions et la GenAI plusieurs milliards. « ChatGPT 4.0 représente 2 000 milliards de paramètres. Nous sommes dans une course sur le nombre de données. » analyse le chercheur.

Le prompt, nouvelle interface

Néanmoins, Luc Julia souligne un point clé apporté par ChatGPT et ses homologues : « Quand on évoque l’aspect science, l’IA générative est une évolution, mais c’est aussi une sorte de révolution dans la manière dont on utilise l’IA. Ce qui est extrêmement intéressant avec l’IA générative, c’est les prompt. »

Cette approche remplace toute interface par le langage naturel et cette approche a littéralement dynamité son adoption par le public. « La courbe d’adoption de l’IA éditée par Gartner en août 2023 était déjà fausse. Les analystes avaient placé l’IA générative au sommet de la courbe, or c’était le cas en janvier/février 2023 lorsqu’un million de personnes utilisaient déjà les IA génératives, et notamment ChatGPT 3.5. Cependant, les usages sont retombés très rapidement à cause des erreurs, des hallucinations. » précise-t-il.

Les utilisateurs ont rapidement trouvé les limites du LLM, mais le traditionnel rebond des usages annoncé par les analystes est arrivé très vite : « Les utilisateurs ont compris que pour des domaines très spécifiques il était possible d’utiliser cet outil dans leur entreprise. Ce qui est remarquable dans cette courbe d’adoption, c’est qu’une technologie a besoin de 5 à 10 ans pour parcourir cette courbe d’adoption. Pour l’IA générative, cela n’a demandé que moins d’une année complète, ce qui est incroyable et cela est dû au prompt qui a rendu la technologie très accessible. »

GenAI : une adoption très rapide

Les hallucinations et les réponses erronées des IA génératives constituent toujours un écueil certain dans leur adoption par les entreprises. Luc Julia évoque une étude universitaire sur la justesse des informations retournées par ChatGPT 3.5. Leur étude montre que les propos de l’IA étaient justes dans 63,4% des cas.

« Il existe des solutions : on peut faire du Fine Tuning, créer des RAG. Le Fine Tuning consiste à apporter ses propres données à ces IA. Il s’agit de données propres à votre domaine, des données dans lesquelles vous avez confiance. L’IA sera plus spécifique mais deviendra bien plus pertinente. Dans l’entreprise où je travaille [NDLR : Renault], nous avons créé des domaines spécifiques qui nous permettent d’atteindre une précision supérieure à 90 %. Il faut toujours vérifier ce qui est produit, mais la précision obtenue varie de 95 à 98%. »

Luc Julia évoque un changement d’approche pour rendre les LLM plus efficaces : « Ces modèles fondation sont très bons pour interagir et ils doivent être très génériques pour y parvenir. Ils doivent aussi devenir plus spécialisés afin de répondre mieux à nos questions. Il faut encore travailler sur ce point. »

Il évoque notamment la possibilité d’aller vers des modèles hybrides, intégrant l’approche statistiques des LLM et l’approche logique des systèmes experts. « Ces systèmes des années 50/60/70 n’étaient pas si mauvais que cela : il faudra sans doute marier la logique et les statistiques. Ce n’est pas simple d’un point de vue mathématique, mais on doit y songer. »

L’impact environnemental de la GenAI en question

Pour Luc Julia, il faut aujourd’hui disposer de solutions pour faire du Fine Tuning et créer des RAG plus simplement et disposer de services de confiance où les entreprises pourront apporter leurs données internes pour accroître la précision des IA. « Il faut aussi s’appuyer sur l’Open Source. Ce n’est pas la solution à tout, mais cela rend possible la vérification des données utilisées, les algorithmes mis en œuvre. C’est un moyen d’avoir plus de contrôle sur ces architectures. »

Les fournisseurs de LLM devront aussi résoudre les problèmes de protection de la propriété intellectuelle et lutter contre le jailbreaking de leurs modèles par les utilisateurs qui contournent les protections mises en place.

« Une course s’est instaurée entre les utilisateurs et les concepteurs sur cette question. En novembre 2022, il était possible de demander à ChatGPT le mode d’emploi pour fabriquer une bombe. Un mois plus tard, l’IA était corrigée et refusait de donner la recette. En février 2024, il était encore possible d’obtenir le mode d’emploi en rédigeant un texte d’une trentaine de pages… et c’est vrai pour toutes les IA génératives. Un étudiant de l’université de Toronto collecte tous ces jailbreaks avec des prompts de parfois plusieurs pages pour contourner les protections mises en place. Les concepteurs ne surpasseront jamais la créativité humaine pour contourner les protections qu’ils mettront en place. » détaille Luc Julia.

L’auteur de « On va droit dans le mur ? » a aussi parlé de la consommation énergétique gargantuesque des grands LLM : « il nous faut des modèles plus frugaux. On met de plus en plus de données dans ces modèles et le monde ne peut plus accepter cette fuite en avant. Si aujourd’hui on faisait autant de requêtes sur ChatGPT 4.0 qu’on ne le fait aujourd’hui sur Google, il n’y aurait pas assez d’énergie dans le monde pour répondre à cette demande ! Ces IA demandent énormément d’énergie pour l’entraînement des modèles, mais demandent aussi de l’énergie lorsqu’on utilise leurs inférences. C’est inacceptable et il faut aller vers plus de frugalité, on n’a pas le choix. »

Photo : © Renault SAS

Sur le même thème

Voir tous les articles Data & IA

![Déployer l'IA à l'échelle : l'approche d'AXA, entre vision et [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/4/473364/deployer-echelle-approche-axa-L.jpg)