Pourquoi OpenAI se prête de plus en plus au FinOps

L’offre d’OpenAI s’élargit… et avec elle, l’éventail des modèles économiques. De GPT-4 Vision à DALL-E 3, aperçu des évolutions.

Combien ça coûte ? De nombreuses questions de cet ordre ont émergé ces dernières heures sur le forum développeurs d’OpenAI.

L’API Assistants, tout juste officialisée, concentre l’essentiel de ces questions. Certaines trouvent réponse en consultant la documentation. Par exemple, concernant le fonctionnement de la tarification « à la session » pour l’interpréteur de code.

C’est moins évident sur d’autres points. Parmi eux, le stockage des conversations côté serveur (il s’agit d’une API stateful)… et son influence sur la facturation. La principale interrogation se résume ainsi : les messages précédents comptent-ils pour des tokens à chaque tour de conversation ?

L’expérience semble indiquer que oui. À chaque run, le traitement de l’historique par le modèle est facturé. À moins d’avoir pris ses précautions, par exemple en plafonnant la fenêtre de contexte. Il faut y ajouter le travail en back-end (fonctions, exécution de code, récupération de données).

Sur le papier, OpenAI communique deux indicateurs de prix pour l’API Assistants. D’une part, pour l’interpréteur : 0,03 $/session. Chaque session est active pendant une heure : on ne paye donc qu’une fois, peu importe le nombre de sollicitations. D’autre part, pour la récupération de données : 0,20 $/Go/assistant/jour, peu importe le nombre d’utilisateurs et de conversations. Une application stockant 1 Go de fichiers pendant un jour et les transmettant à deux assistants entraînerait donc une facture de 2 x 0,20 = 0,40 $.

La tarification se complexifie avec GPT-4 Vision…

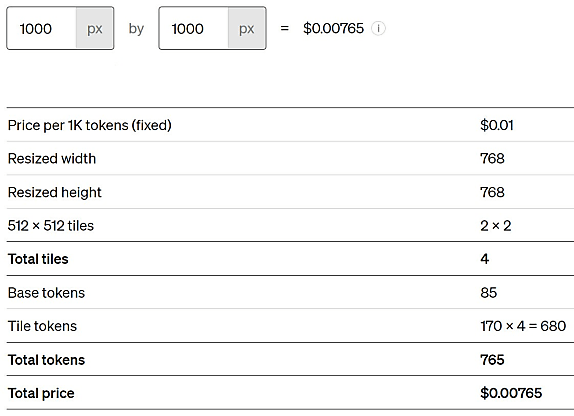

OpenAI vient de lancer une version expérimentale de GPT-4 dotée de capacités d’analyse d’images. Elle a une tarification spécifique. Celle-ci dépend de la résolution de traitement et éventuellement de la taille desdites images.

En « basse résolution », l’image est réduite à 512 pixels de côté avant d’être transmise au modèle. Elle consomme alors 85 tokens. À 0,01 $ par tranche de 1000 tokens, cela représente un coût unitaire de 0,00085 $.

En « haute résolution », l’image n’est redimensionnée que si elle dépasse 2048 pixels de longueur et/ou 768 de largeur. Elle consomme toujours 85 tokens… auxquels il faut ajouter 170 tokens pour chaque bloc de 512 pixels de côté. Par exemple, une image en 1000 x 1000 coûtera 0,00765 $.

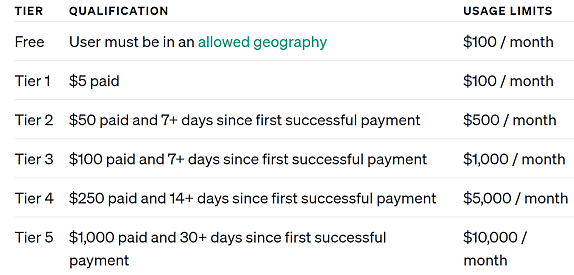

Pendant la phase expérimentale, OpenAI fixe les limites à 20 requêtes par minute et 100 requêtes par jour. Le nombre de tokens par minute dépend du niveau d’usage global auquel on se trouve (seuils progressivement relevés en fonction des volumes de paiement).

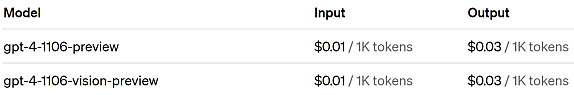

Les limites sont les mêmes pour GPT-4 Turbo, lui aussi en preview. Il absorbera les fonctionnalités de GPT-4 Vision une fois que celles-ci seront stabilisées. En attendant, les prix sont les suivants (ils s’entendent aussi par tranche de 1000 tokens) :

– En entrée, 0,01 $. Soit trois fois moins que pour GPT-4 8k et six fois moins que pour GPT-4 32k. Mais dix fois plus que GPT-3.5 Turbo (nouvelle tarification).

– En sortie, 0,03 $. Soit deux fois moins que pour GPT-4 8k et quatre fois moins que pour GPT-4 32k. Mais cinq fois plus que GPT-3.5 Turbo (nouvelle tarification également).

Le finetuning n’est pas encore disponible sur GPT-4. Il l’est sur GPT-3.5. L’inférence coûte ensuite 0,003 $ tous les 1000 tokens en entrée et 0,006 $ tous les 1000 tokens en sortie.

… et avec DALL-E 3

Comme GPT-4 Vision, DALL-E 3 a une option « haute qualité ». Elle joue sur les prix, en plus de la taille des images générées.

Avec DALL-E 2, toujours disponible sur l’API, il en coûte 0,016 $ par image de 256 pixels de côté ; 0,018 $ en 512 pixels ; 0,02 $ en 1024 pixels.

Avec DALL-E 3, le ticket d’entrée est à 0,04 $ par image de 1024 pixels de côté en qualité « standard ». C’est deux fois plus cher (0,08 $) en qualité « HD ».

Il faut également compter 0,08 $ pour une image « standard » de 1024 x 1792 pixels (ou l’inverse)… et 0,12 $ en « HD ».

L’usage de DALL-E 3 est pour le moment plafonné à 6 images par minute.

Le traitement de l’audio facturé à la minute et au nombre de caractères

La nouvelle fonctionnalité de synthèse vocale est facturée non par tranche de 1000 tokens, mais de 1000 caractères. Tarifs : 0,015 $ avec le modèle de base et 0,03 $ avec le modèle « haute qualité ».

Le modèle tarifaire de la reconnaissance vocale – avec Whisper – ne change pas. C’est 0,0001 $ la seconde. La limite est à 50 requêtes par minute.

OpenAI ne garantit encore aucun SLA pour ses offres.

Illustration principale © canonmark2 – Adobe Stock

Sur le même thème

Voir tous les articles Business