Acme : un boost made in Google pour l'apprentissage par renforcement

Avec le framework Acme, DeepMind (filiale de Google) entend favoriser la mise à l'échelle des modèles d'apprentissage par renforcement.

Le problème de la mise à l'échelle se pose aussi avec l'apprentissage par renforcement.

DeepMind le rappelle en introduction d'un rapport relatif à Acme.

La filiale de Google a développé cette boîte à outils (framework + bibliothèque logicielle) pour répondre à la complexification des algorithmes dans cette branche de l'IA.

Elle a défini une architecture modulaire censée favoriser l'entraînement distribué.

Dans le cadre de l'apprentissage par renforcement, cette distribution consiste à faire interagir les agents avec de multiples instances des environnements à partir desquels ils génèrent des données.

Lire aussi : Prix Turing 2024 : Andrew Barto et Richard Sutton, pionniers de l'apprentissage par renforcement

Une simple réimplémentation n'est pas toujours suffisante pour effectuer ce passage à l'échelle.

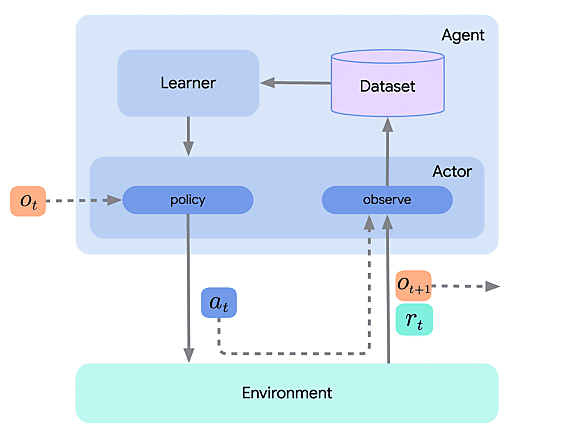

L'architecture modulaire qu'Acme met en ouvre face à cette problématique implique une séparation claire entre les fonctions d'acteur (« actor ») et de critique (« learner »). Le premier explore l'environnement et en tire des expériences. Le second apprend de ces expériences et adapte la politique que suit l'acteur.

Cette séparation en processus permet de mener l'apprentissage indépendamment de la capacité de collecte de données, les modules communiquant par appels distants. Elle favorise aussi l'exploitation en offline (apprentissage à partir d'un jeu de données fixe).

La boîte à outils contient des agents « prêts à l'emploi ». DeepMind les présente comme des « implémentations de référence » destinées à tirer parti des algorithmes existants. Il s'agit pour le moment de versions monotâches (non parallélisées).

Illustration principale via shutterstock.com

Sur le même thème

Voir tous les articles Data & IA

![Qu'est-ce que le protocole MCP, qui monte dans l'univers de [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/3/469501/quest-protocole-mcp-monte-univers-llm-L.jpg)