ChatGPT risque-t-il de « privatiser » la connaissance ?

Une étude universitaire pose la question de l'accaparement de la connaissance par les LLM, au premier rang desquels ChatGPT.

Les grands modèles de langage (LLM), une menace pour les biens numériques publics ? Trois chercheurs universitaires se sont penchés sur la question. Leur principal support d'étude : l'évolution des publications sur Stack Overflow après le lancement de ChatGPT.

Le postulat, dans les grandes lignes, était le suivant :

- Les LLM sont un substitut potentiel à de nombreuses méthodes « ouvertes » d'acquisition de connaissances... dont les forums tel Stack Overflow.

- L'interaction avec ces LLM étant privée, il existe un risque de réduction de la quantité - et éventuellement de la qualité - des connaissances publiquement accessibles.

- Il en résulterait, entre autres, un manque de données d'entraînement pour de futurs modèles.

- Les progrès des LLM reposeraient ainsi plus sensiblement sur ces interactions privées. Ce qui bénéficierait aux plus populaires, comme ChatGPT.

- On peut imaginer former des LLM avec des données produites par d'autres LLM, mais la méthode a ses limites.

Un « effet ChatGPT » marqué sur Stack Overflow

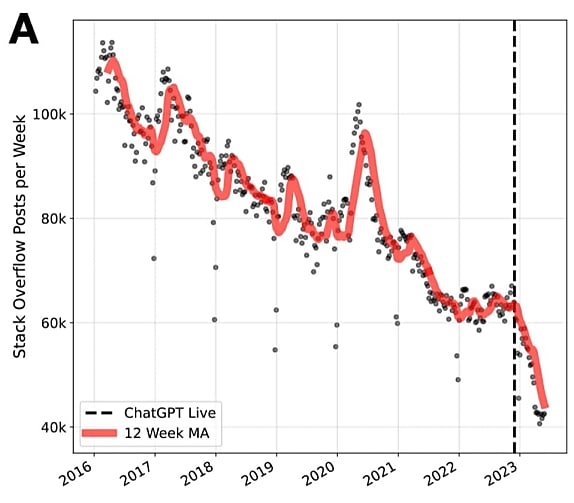

Début 2016, Stack Overflow enregistrait environ 110 000 posts par semaine, d'après les données qu'ont collectées les chercheurs. Le volume a ensuite décru, en moyenne, de 7000 posts chaque année, pour atteindre 60 000 début 2022.

La chute s'est accélérée à partir du lancement de ChatGPT fin novembre : 20 000 posts hebdomadaires de moins en six mois.

Lire aussi : ChatGPT, la fin de l'humanité ?

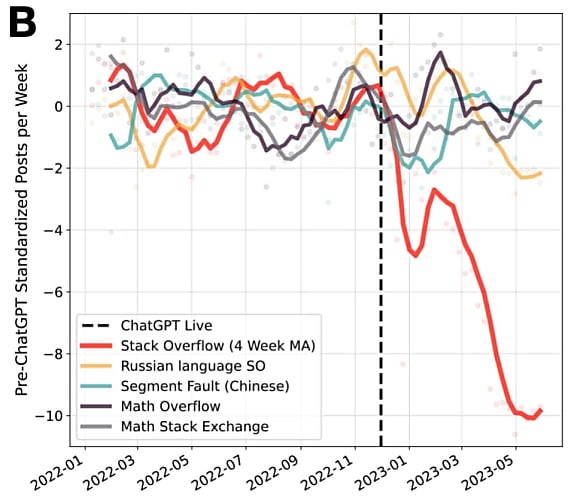

On n'a pas constaté le même phénomène sur les quatre autres plates-formes examinées. D'une part, la version russe de Stack Overflow et son homologue chinoise Segmentfault. De l'autre, Mathematics StackExchange et MathOverflow.

Aucune, a-t-on estimé, n'était susceptible d'être remplacée par ChatGPT. Les deux premières, parce qu'elles couvraient des zones géographiques où l'accès au chatbot d'OpenAI est officiellement limité. Les deux autres parce qu'elles touchent à des sujets qui ne sont pas sont point fort (voir notre article « Bard, ChatGPT et leurs limites de raisonnement »).

CUDA, exception à la baisse

Par « post », il faut entendre à la fois les questions et les réponses. Pour les unes et les autres, la chute post-ChatGPT est similaire.

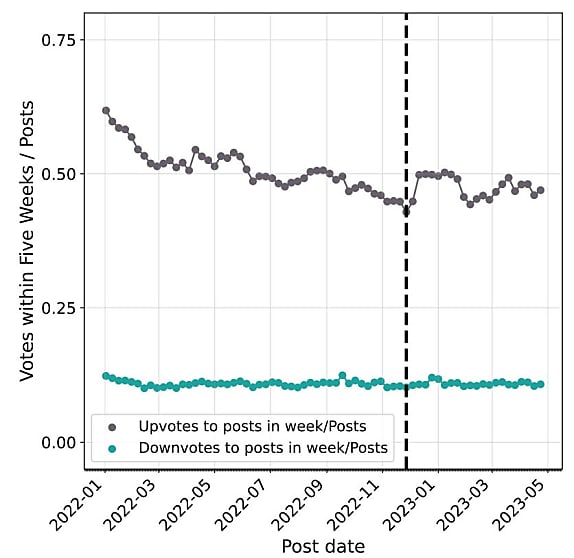

On pourrait supposer que les connaissances « de base » disparaissent pour laisser place à des discussions plus qualitatives. L'examen des votes sur les posts ne le suggère pas : il n'y a pas eu d'évolution significative.

Les chercheurs reconnaissent que cet indicateur peut ne pas refléter la véritable qualité des publications. C'est l'une des limites de leur étude, admettent-ils. Aux côtés, notamment, du point d'interrogation sur la capacité des utilisateurs russes et chinois d'accéder tout de même à ChatGPT. Et de citer, à ce propos, des travaux qui ont démontré un pic de connexions VPN après le blocage - temporaire - du chatbot en Italie.

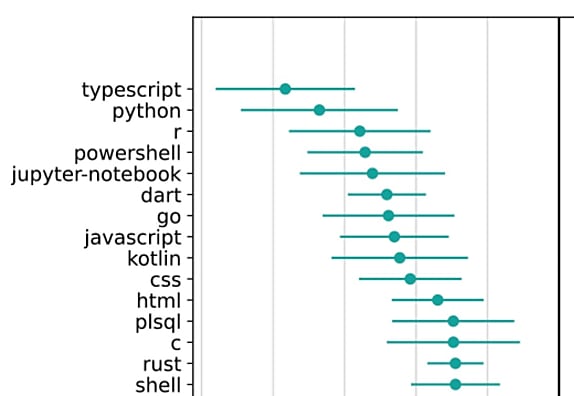

Si on se penche sur l'évolution du volume de posts par langage de programmation, l'« effet ChatGPT » a été négatif pour la plupart d'entre eux. Les plus touchés sont globalement aussi les plus populaires, en tout cas sur la foi de l'étalon que les chercheurs ont défini : le nombre de dépôts GitHub à juin 2021.

Ils sont cinq à faire exception à la baisse du volume de questions-réponses. Nommément, Objective-C, VBScript, Fortran, CUDA et Delphi.

Illustration principale générée par IA

Sur le même thème

Voir tous les articles Data & IA