IA et copyright : la perspective d'une norme IETF réconciliatrice

Un groupe de travail au sein de l'IETF ouvre la voie à la standardisation de méthodes de contrôle des collectes de contenus destinés à entraîner des IA.

Robots.txt, nécessaire mais pas suffisant pour contrôler la collecte de contenus destinés à entraîner des IA ? C'est aujourd'hui la pensée dominante sur la mailing list d'AI Preferences.

Ce groupe de travail établi au sein de l'IETF a officiellement pris forme en début d'année. Mais ses origines remontent à mars 2024. L'initiative s'appelait alors AI-CONTROLS. Son objet : "discuter de mécanismes permettant [aux LLM] d'interagir avec l'infrastructure Internet". Avec un focus initial sur "la manière dont les sites web peuvent communiquer leurs préférences via un mécanisme comme robots.txt".

Les porteurs du projet avaient fait un point sur l'existant. Entre autres, les balises meta "noai" de DeviantArt, le blocage par défaut de l'user-agent AiBot par Medium et le système mis en place par Cloudflare pour bloquer des catégories de bots. Ils avaient aussi mentionné diverses propositions de fichiers ai.txt. Dont une impliquant un dispositif apparenté au RSS, où les crawlers IA souscriraient à des flux de contenu structuré au préalable.

Parmi les questions qui se posaient alors :

- Comment traiter les robots utilisés à la fois pour l'indexation et pour la collecte de contenus destinés à entraîner des IA ? Et, pour ce dernier usage, ceux dont la finalité n'est pas précise (commercial vs recherche, par exemple) ?

- Où est la frontière entre les robots qui collectent des contenus pour entraîner des IA et ceux qui le font pour alimenter des services de recherche (RAG) ?

- Comment concilier les préférences des créateurs, des détenteurs de droits et des distributeurs ?

Harmoniser le vocabulaire... et réconcilier les expressions de préférences

Cette dernière question est aujourd'hui au coeur des travaux d'AI Preferences. Qui s'est donné la mission de publier, pour août 2025, des spécifications couvrant trois points :

- Une terminologie commune pour l'expression de préférences

- Des moyens d'attacher ces préférences à du contenu, soit en les y embarquant, soit à travers les protocoles de livraison de contenu

- Un mécanisme pour réconcilier plusieurs expressions de préférences

Le groupe de travail est coprésidé par Suresh Krishnan (par ailleurs président du groupe de travail eBPF et du directoire IoT) et Mark Nottingham (président du groupe de travail HTTP). Il organisera sa première réunion "intérimaire" - hors du cycle des réunions IETF - les 8, 9 et 10 avril à Bruxelles, chez Microsoft Belgique.

En l'état, la charte ne précise pas si le mécanisme élaboré s'inscrira dans un principe d'opt-in ou d'opt-out. Le groupe de travail semble juger plus prudent de couvrir les deux cas, dans une logique d'adaptation aux régimes juridiques. Il envisage en outre une terminologie simple, mais extensible. Ainsi que la collaboration avec les organisations qui portent des formats tels que HTML et jpeg.

De JPEG Trust à TDMRep, de multiples compléments potentiels à robots.txt

En toile de fond, pour ce dernier, la norme JPEG Trust (ISO 21617-01). Elle fait partie des briques sur lesquelles AI Preferences est susceptible de se fonder. La spécificiation TDMRep (TDM Reservation Protocol) en est une autre. Signée du W3C et basée sur la directive copyright (2019/790), elle permet d'exprimer des droits réservés relatifs aux minage de texte et de données. On peut y ajouter le Photo Metadata Standard de l'IPTC (International Press Telecommunications Council, fédérant l'industrie des médias). Il inclut un champ "data mining" et une liste de valeurs permettant d'indiquer si l'exploitation d'images est ou non autorisé pour une série de finalité (indexation, entraînement d'algorithmes de machine learning, entraînement d'IA générative, etc.).

Lire aussi : Meta va utiliser les données des utilisateurs européens pour entraîner ses modèles d'IA

C2PA et ISCC sont des dispositifs d'un autre ordre si on les considère sous l'angle de la privacy, puisqu'ils impliquent d'associer l'identité du créateur à la déclaration d'opt-in/opt-out. Une réalité à laquelle AI Preferences ne se montre pas insensible. Sans pour autant, en l'état, trancher clairement s'il lui incombe d'englober cet enjeux dans ses travaux. Ni, d'ailleurs, si c'est à lui de fournir de quoi s'assurer que toute personne ou entité déclarant des préférences ait une base valide pour le faire.

Pour pallier les limites de robots.txt (notamment sa taille maximale de 500 kibioctets), s'est imposée l'idée d'exploiter une "composante soeur" au sein du REP (Robots Exclusion Protocol) : l'en-tête X-Robots, peu utilisé actuellement.

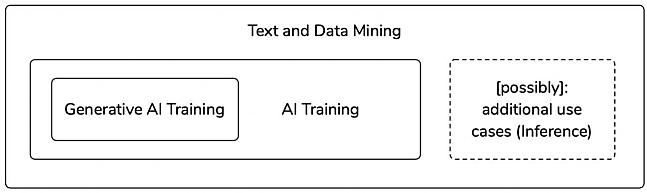

Concernant la terminologie commune, le collectif Open Future, partie prenante aux discussions, en a récemment proposé une ébauche. Elle laisse la porte ouverte pour l'inclusion de l'inférence en complément à l'entraînement.

À consulter en complément :

OpenAI plaide en faveur de nouvelles règles américaines pour l'IA

AI Act : des exigences de documentation des modèles prennent forme

IA et prioriété intellectuelle : la vision du Cigref

ChatGPT et copyright : OpenAI, dans les clous du fair use ?

Illustration principale © Kemal - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA