Multimodale, locale, agentique... quelle IA en 2025 ?

À l'appui de son traitement du sujet cette année, Silicon.fr ébauche quelques pistes sur ce que sera l'IA en 2025.

Quels points communs entre les marques Moshi, MobileDiffusion, Agentforce et Confiance.ai ? Tout au moins celui d'être apparues cette année sur Silicon.fr. Elles emblématisent l'IA respectivement sous ses aspects multimodal, local, agentique... et de confiance.

Nous reprenons ici cette segmentation pour esquisser, sur la base de notre traitement du sujet en 2024, quelques-uns des fondements posés pour le développement de l'IA en 2025.

Vers des LLM vraiment multimodaux

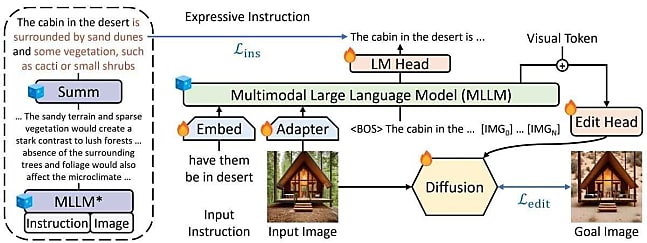

Apple Intelligence n'était pas encore d'actualité lorsque la firme de Cupertino présenta, en début d'année, un aperçu de ses travaux sur les LLM multimodaux. Plus précisément sur une méthode dite MGIE (MLLM-Guided Image Editing). Elle consiste, pour les tâches d'édition d'images, à s'appuyer sur un modèle multimodal intermédiaire capable d'enrichir les instructions que donne l'utilisateur.

En mars, OpenAI avait dévoilé Sora, son générateur de vidéos. Un modèle finalement ouvert en décembre... avec des restrictions sur certains usages. En première ligne, l'exploitation de photos ou de vidéos de personnes réelles.

Sora a un modèle économique spécifique. Il ne consomme pas de tokens, mais des crédits, selon plusieurs paramètres (format, résolution et durée de la vidéo produite + type de tâche). OpenAI insiste sur les garde-fous - instaurés ou prévus. Parmi eux, le recours aux métadonnées C2PA, du nom de la Coalition for Content Provenance and Authenticity. Ce consortium fondé en 2021 élabore des spécifications techniques pour établir la provenance et l'authenticité de contenus. Autre garde-fous : un moteur de recherche inversée (pour faciliter la découverte de contenus produits par Sora) et une modération par LLM (réécriture de prompts, par exemple ceux qui demandent de s'inspirer du style d'un artiste vivant).

Dans la foulée du lancement de Sora, Google annonça Gemini 2.0. Cette nouvelle génération de ses modèles génératifs commerciaux sert pour le moment des usages essentiellement expérimentaux. La nouveauté par rapport à la génération précédente, c'est la multimodalité des outputs (audio et images).

Avec Moshi, Kyutai a surtout travaillé sur la modalité audio. Il a fusionné en un réseau de neurones le pipeline traditionnellement complexe des IA vocales (détection de parole, transcription textuelle, génération d'une réponse texte, puis synthèse vocale). Autant pour réduire la latence que pour conserver des éléments que la modalité texte fait perdre (émotions, intonations, hésitations, acoustique...).

Parallèlement à la multimodalité se développe le multilinguisme. En tout cas dans le cadre de projets tels qu'EuroLLM. Financé par le programme Horizon Europe, il doit durer jusqu'au 30 avril 2025. Il est censé en découler des LLM d'échelle 1B à 22B pouvant traiter et produire du texte dans les 24 langues officielles de l'UE, ainsi qu'une dizaine d'autres. L'entraînement des premiers a notamment impliqué, sur la fin du processus (les 10 derniers %), l'augmentation de la proportion de données "de haute qualité" (Wikipédia pour toutes les langues ; arXiv, Books et Apollo pour l'anglais).

Lire aussi : Apple Intelligence, une épreuve de patience

Les modèles d'EuroLLM seront mis en open source. Une voie vers laquelle Intel s'est tourné face à NVIDIA. Il apparaît comme la tête de pont d'OPEA (Open Enterprise Platform for AI). Ce projet placé sous l'égide de la Fondation Linux vise, selon les termes de sa charte technique, à développer un "framework d'orchestration d'écosystème pour l'intégration efficace des technologies de GenAI". Les implémentations de référence sont toutes optimisées pour une exécution sur les accélérateurs Gaudi.

Des briques open source, la France en produira aussi dans le cadre de l'appel à projets "Communs numériques pour l'intelligence artificielle". Parmi les projets lauréats, AI for Democracy doit développer un cadre scientifique de détermination des principes démocratiques appliqués à l'IA. Ainsi qu'un modèle d'évaluation des biais des LLM par rapport à ces principes, assorti de LLM "débiaisés" et de plates-formes de participation citoyenne conformes à ces mêmes principes.

Le projet ArGiMi a pour but de créer des LLM francophones adoptés aux besoins spécifiques des entreprises. CC-SWH vise à développer, sur la base de Software Heritage (projet de préservation de code source), un modèle générateur de code informatique. Quant à Photoroom, il doit produire un modèle text-to-image valorisant le patrimoine français.

L'an 1 des LLM locaux...

Apple n'a pas attendu d'officialiser sa stratégie en la matière pour publier des articles de recherche. L'un d'entre eux touchait aux LLM frugaux en mémoire. Au coeur des travaux, un mécanisme d'optimisation des transferts de données de la flash vers la RAM. Il implique, entre autres techniques, la prédiction de matrices creuses, l'usage d'une fenêtre glissante et la concaténation de valeurs. Il s'agit à la fois de réduire les volumes de transferts et d'optimiser les performances en lecture.

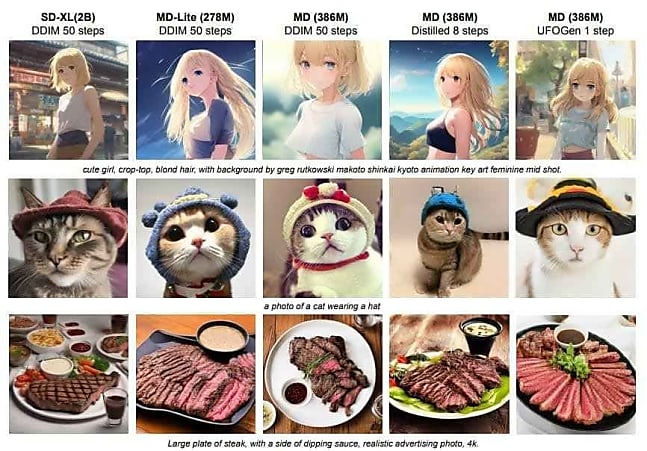

Quelques semaines plus tard, Google avait présenté MobileDiffusion, un modèle de diffusion adapté aux appareils mobiles. Il résulte d'une optimisation de l'architecture UNet. Spécialement sur les blocs dits transformeurs. Ceux-ci sont, dans les grandes lignes, responsables de la compréhension du texte qui permet de générer les images. Ils incluent une couche d'autoattention particulièrement coûteuse en ressources de calcul.

Des travaux préalables avaient introduit une architecture UViT réduisant les "coûts d'attention" en privilégiant le placement de ces blocs sur le segment basse résolution de UNet. Les chercheurs ont exploité cette approche pour relocaliser d'autres blocs depuis des segments haute résolution. Pour maintenir la cohérence du nombre de paramètres, ils ont réduit la taille des canaux aux plus basses résolutions. Une méthode qui dégrade moins les performances que de réduire la taille même des blocs transformeurs. Autre technique : sur les hautes résolutions, découpler la couche d'autoattention et la couche de cross-attention pour ne conserver que cette dernière, bien moins gourmande.

Parallèlement à ces recherches, des modèles "légers" destinés à un usage local ont émergé. Par exemple dans le domaine du développement logiciel. Stability AI a lancé un modèle Stable Code utilisable sans GPU dédié. Le pipeline d'entraînement fut similaire à celui des modèles Code Llama. JetBrains a quant à lui commencé à pousser du LLM local dans ses IDE, d'abord pour la saisie semi-automatique. L'inférence a son processus dédié, optimisé pour l'architecture cible.

Mi-2024, les premiers PC Copilot+ sont arrivés sur le marché. Les NPU en sont un trait caractéristique. Il s'agit de coprocesseurs spécialisés en calcul matriciel, une opération fondamentale dans le fonctionnement des LLM.

... et de l'IA agentique ?

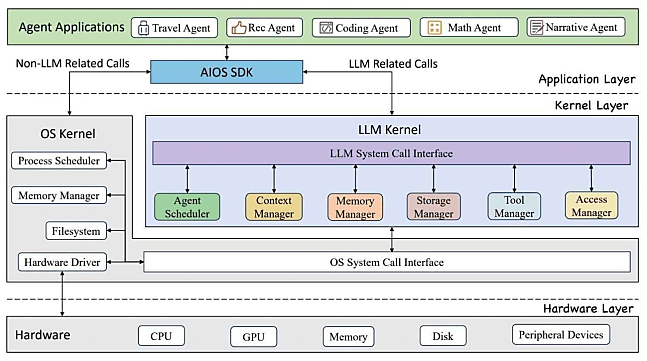

Divers articles de recherche ont là aussi donné le ton en début d'année. Illustration avec le projet AIOS, destiné à améliorer les agents autonomes en les englobant dans une forme de système d'exploitation. Il implique un noyau LLM spécifique - distinct du kernel - qui comprend un planificateur ainsi que divers gestionnaires de contexte (sauvegarde et restauration d'état + gestion de la fenêtre), de mémoire et de stockage (mémoires à court et long termes), d'outils (exploitables par API) et d'accès.

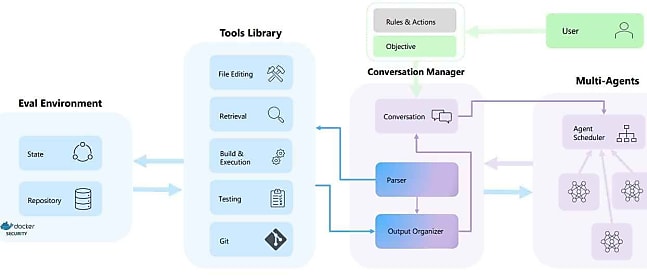

Autre exemple : AutoDev, qui fait de GPT-4 un agent autonome de développement logiciel. Ce framework s'inspire d'Auto-GPT, qui associe à GPT-3.5 et GPT-4 un "bot compagnon" s'appuyant sur eux pour réaliser les étapes nécessaires à l'accomplissement d'un objectif. Autres sources d'inspiration : le framework LATS (Language Agent Tree Search) et la méthode Reflexion.

Le premier exploite l'algorithme de recherche arborescente Monte-Carlo pour mutualiser les capacités de planification, de raisonnement et d'action. La seconde établit un système de "feedback linguistique" sans modification de poids : un agent réfléchit verbalement à partir de signaux et conserve cette réflexion dans une mémoire épisodique.

AutoDev synthétise ces éléments et les adapte au développement logiciel en les intégrant dans le flux des IDE.

Au deuxième semestre, l'intégration de l'IA agentique dans les offres commerciales s'est accélérée. Chez SAP, l'assistant Joule a commencé à s'ouvrir à ce type d'usage, avec deux scénarios pour commencer : gestion de litiges et comptabilité financière. Les développeurs pourront construire leurs propres agents sur SAP Build à partir du premier trimestre 2025.

L'IA agentique a appelé des changements de positionnement marketing. Le cas de UiPath en témoigne. L'entreprise se présente désormais comme un fournisseur de "logiciels d'automatisation agentique". Il n'y a pas si longtemps, elle se disait fournisseur de logiciels de RPA (puis d'automatisation d'entreprise, et enfin d'automatisation d'entreprise par IA).

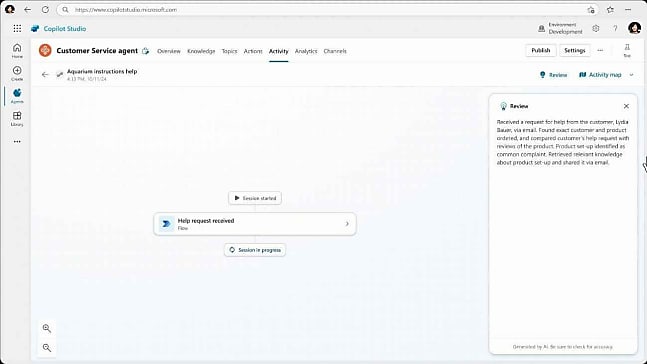

Chez Microsoft aussi, la terminologie a évolué. Il fut un temps, "agent" était synonyme de "chatbot". Il fallait, en particulier, l'entendre ainsi dans le cadre de l'offre Power Virtual Agents. Celle-ci n'existe plus depuis fin 2023. Elle est cependant devenue un des socles de Copilot Studio. Avec ce produit, la notion d'agent fut d'abord mise en arrière-plan au profit du "copilote". Puis réinstaurée rapidement au sens de "version autonome du copilote".

Dans ce contexte sont apparus des comparatifs d'assistants IA sous l'angle agentique. Comme la matrice d'AI Builders, élaborée sur le modèle du Magic Quadrant, avec comme angle les suites bureautiques et métiers.

L'impact de l'IA agentique sur les modèles économiques de éditeurs de logiciels interroge. En premier lieu chez Numeum, syndicat professionnel qui les représente en France. En toile de fond, Salesforce, qui, avec l'annonce d'Agentforce, a esquissé une tarification à la conversation.

IA de confiance : trouver les bons indicateurs

Les articles de recherche ne manquent pas non plus sur le sujet de l'IA de confiance. Certains démontrent la marge de progression qui demeure sur divers aspects. Des chercheurs ont par exemple attiré l'attention sur une attaque qui a permis d'extraire des informations dans la dernière couche de LLM en boîte noire. En utilisant l'API de plusieurs modèles commerciaux, ils ont pu déterminer la dimension vectorielle de la dernière couche. Voire, pour les plus petits modèles, l'intégralité de la matrice de poids.

Une synthèse d'un autre chercheur a donné à voir les limites de l'IA générative pour ce qui est de "désapprendre". Les méthodes que l'intéressé passent en revue incluent du désapprentissage exact (le modèle se comporte comme s'il n'avait pas été entraîné sur les données cibles), de la vie privée différentielle (on garantit de façon quantifiable qu'on ne peut faire la distinction entre des modèles M et M' entraînés sur des datasets X et X'), du désapprentissage empirique (ajustement du comportement du modèle pour se rapprocher de ce qu'il aurait été sans les données cibles) et du désapprentissage par les prompts (un LLM peut "faire semblant" d'avoir désappris).

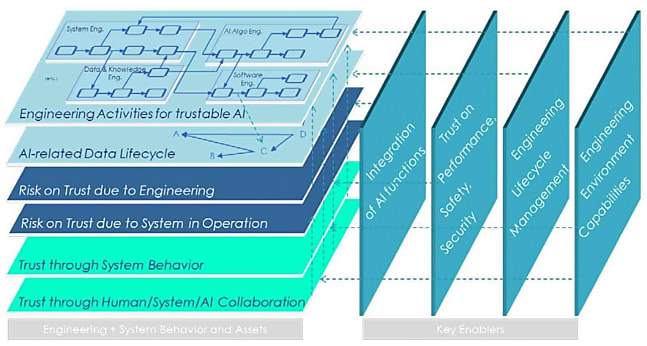

En France, le programme Confiance.ai avait démarré début 2021 dans le cadre du Grand Défi "Sécuriser, certifier et fiabiliser les systèmes fondés sur l'intelligence artificielle". Une dizaine d'industriels avaient apporté des cas d'usage, avec une question : comment intégrer des IA de confiance en production ? Au bout du compte, il y a un "environnement de confiance" qui prend la forme d'une méthode transsectorielle associée à un catalogue de composants technologiques.

Confiance.ai s'était d'aord focalisé sur des approches orientées données, utilisant essentiellement les réseaux neuronaux pour le traitement d'images, de séries temporelles et d'informations structurées. Il avait ensuite abordé des problématiques plus complexes touchant à l'IA symbolique et à l'IA hybride.

L'ANSSI a édicté des lignes directrices sur l'IA générative. (ne pas mutualiser les composants GPU avec d'autres applications métier du SI, privilégier des formats qui séparent strictement données paramètres et données de code exécutable, etc.). Elle a fait de même pour l'usage des assistants de codage (tests de fonctions sur les outputs, mise en place d'une liste blanche face aux attaques fondées sur des packages malicieux, etc.).

Fin 2023, Stanford avait publié un index de transparence des LLM. L'université l'a actualisé cette année, sans changer les critères, mais en modifiant la méthode (la recherche d'informations a laissé place au déclaratif).

En parallèle, Hugging Face a revu les fondements de son leaderboard (axé sur la précision des LLM). Il a considéré que des benchmarks comme ARC, HellaSwag et MMLU n'étaient plus pertinents. D'un côté, parce qu'ils étaient devenus "trop simples" (certains modèles atteignaient le niveau de performance de l'humain). De l'autre, parce que des modèles montraient des signes de contamination : ils semblaient avoir été (sur)entraînés sur des données très proches de ces benchmarks.

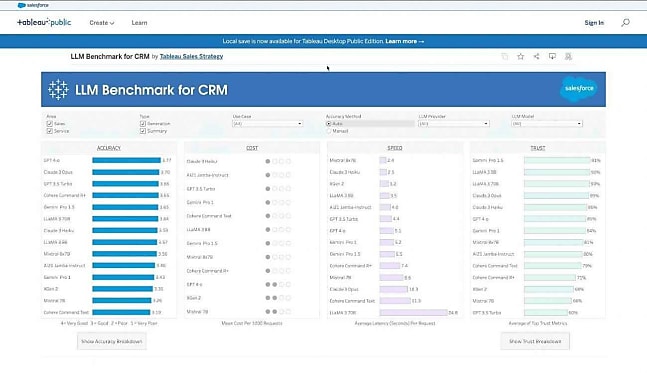

Salesforce a mêlé performance et confiance dans un benchmark focalisé sur des cas d'usage CRM. En l'occurrence, la synthèse et la génératon de contenus textuels pour les ventes et le service. Il a utilisé quatre critères sur chacun des deux axes. Pour la performance, l'exhaustivté, la concision et la factualité des réponses, ainsi que la qualité de suivi des nstructions en termes de contenus et de format. Pour la confiance, la capacité à refuser de répondre à des prompts indésirables, le respect de la vie privée, l'aptitude à corriger de fausses informations dans les prompts et la résistance aux biais de genre et de compte.

Des disponibilités limitées en Europe sur fond de régulation

Des initiatives ont aussi émergé sur la gestion des risques. Une première version de l'AI Risk Repository a fait son entrée, concrétisant un travail collectif - emmené par le MIT - de compilation des risques associés à l'IA.

La réglementation européenne - nommément, l'AI Act - est venue encadrer l'IA à partir d'une approche basée sur les risques. Dans le même temps, les CNIL sont intervenues. Notamment l'autorité irlandaise. Avant d'ouvrir une enquête sur PaLM 2 de Google (son entraînement a-t-il respecté le RGPD ?), elle avait trouvé un accord avec X. Lequel a promis de ne plus entraîner son modèle Grok avec les données personnelles contenues dans les posts publics des utilisateurs localisés dans l'Espace économique européen. En amont, elle avait réussi à obtenir que Meta "mette en pause" ses ambitions d'entraîner des LLM avec du contenu public partagé sur Facebook et Instagram dans cette même zone géographique.

Dans ce contexte, Meta s'est refusé à lancer ses LLM multimodaux Llama 3.2 en Europe. Il estime que la régulation est devenue "fragmentée et imprévisible". Tandis que les interventions des CNIL ont "créé de l'incertitude quant aux données utilisables pour entraîner des modèles". L'entreprise a émis une lettre ouverte intitulée "L'Europe a besoin de certitude réglementaire sur l'IA". Parmi les signataires, les patrons de Criteo, d'Ericsson, de Publicis, de SAP et de Spotify. Ainsi que Patrick Pérez et Yann Le Cun, respectivement directeur de Kyutai et directeur scientifique de l'IA chez Meta.

Apple a aussi invoqué l'environnement réglementaire - avant tout, le Digital Markets Act - pour justifier le décalage du lancement d'Apple Intelligence dans l'UE sur iPhone et iPad. Ce sera pour avril 2025, alors que la diffusion - très progressive - dans le reste du monde a débuté en octobre 2024.

Chez Google, Gemini a aussi connu un lancement plus tardif dans l'UE que dans le reste du monde.

Des architectures et des frameworks alternatifs

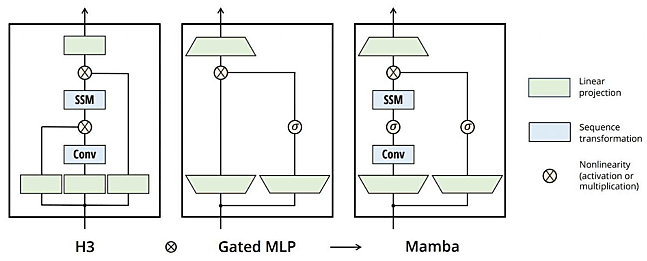

Pour son premier LLM codeur ouvert, Mistral AI a utilisé une architecture alternative : Mamba. Elle est censée pallier les limites de Transformers lors du traitement de longues séquences. Dans ces scénarios, le mécanisme d'attention constitue un goulet d'étranglement, du fait qu'il utilise une forme de cache clé-valeur permettant à chaque token d'accéder aux précédents lors de la prédiction. Plus la taille de contexte augmente, plus l'empreinte mémoire et la latence augmentent, de façon quadratique.

Des méthodes telles que la fenêtre glissante et l'attention flash peuvent atténuer cet effet. Mamba va plus loin en remplaçant le composant d'attention par un mécanisme inspiré de la théorie du contrôle : les SSM (State Space Models). Avec eux, la montée en charge est linéaire. On permet aux paramètres SSM d'être fonction de l'input, de sorte qu'une sélection des informations à conserver s'opère au moment de la mémorisation - et non au moment de la remémoration, comme c'est le cas pour les transformeurs.

Mamba combine le bloc H3 à la base de la plupart des architectures SSM avec le bloc MLP des réseaux neuronaux modernes. Au lieu d'interlacer les deux blocs, il répète le bloc Mamba de manière homogène.

En 2024, on a aussi vu se développer le principe de la chaîne de pensée. Elle guide notamment le fonctionnement des modèles o1 d'OpenAI. Elle se manifeste par des tokens spécifiques. Dits "de raisonnement", ils retranscrivent la "pensée brute" d'un modèle. Ils ne sont pas visibles sur l'API, mais bien facturés. Sur l'UI ChatGPT, on voit une version résumée de la chaîne... épurée des éléments indésirables.

Parmi les travaux dont les chaînes de pensée ont fait l'objet figurent ceux de Meta. Ses chercheurs ont proposé une méthode écartant la modalité langage. Elle permet d'encoder simultanément plusieurs next steps potentiels. Et donc à un LLM d'explorer, à chaque étape de raisonnement, plusieurs solutions, plutôt que de s'engager sur une voie déterminée.

Des travaux, il y en a aussi eu sur le raisonnement inductif (généralisation à partir d'exemples). Entre autres ceux d'Amazon, qui propose le framework SolverLearner, censé être à même de saisir les véritables capacités des LLM en la matière, grâce à une séparation stricte vis-à-vis du raisonnement déductif.

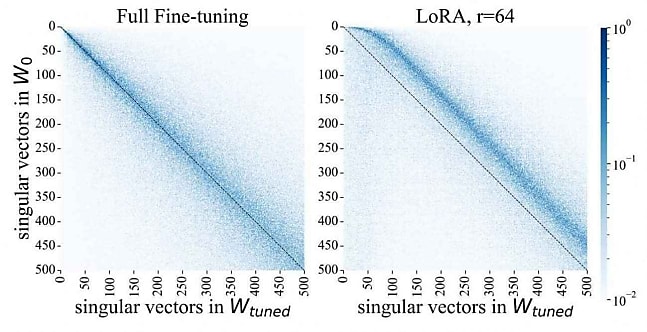

D'autres travaux ont permis de mieux comprendre la méthode LoRA (Low-Rank Adaptation). Avec elle, on ne modifie pas la matrice de poids d'origine : on estime les paramètres en la décomposant en deux matrices plus petites, dites de rang inférieur (le rang correspondant à leur dimension).

Des chercheurs ont examiné les différences avec les modèles résultant d'un surentraînement classique. Ils ont constaté que les modèles LoRA présentaient davantage de "dimensions intruses". En d'autres termes, des vecteurs singuliers dont la similarité cosinus vis-à-vis de ceux de la matrice de poids d'origine est faible (ils leur sont approximativement orthogonaux).

L'existence de ces dimensions intruses est corrélée à une plus grande tendance à l'oubli. À la fois vis-à-vis de la distribution d'origine et lors de l'entraînement en continu (affinement sur plusieurs tâches à la suite). Cela peut expliquer pourquoi les modèles LoRA ont du mal à rivaliser avec les modèles FFT (full fine-tuning) sur des tâches complexes comme la génération de code et de texte long.

Illustration principale

Sur le même thème

Voir tous les articles Data & IA