Un an après : comment Anthropic s'est développé avec les milliards d'Amazon

Il y a un an, Anthropic obtenait officiellement le soutien financier d'Amazon. Voici quelques grands axes sur lesquels son offre a évolué depuis.

Que peut-on faire avec 4 Md$ ? En septembre 2023, Amazon s'était engagé à apporter ce montant à Anthropic. Il avait immédiatement injecté 1,25 milliard. Le reste de l'enveloppe fut débloqué en mars 2024.

Dans la foulée de cette annonce, Claude était passé en disponibilité générale sur Amazon Bedrock, après environ cinq mois de bêta. On ne pouvait alors pas encore y accéder sur Vertex AI, l'offre concurrente de Google Cloud, qui avait pourtant apporté en amont son soutien financier à Anthropic (près de 400 M$ investis en février 2023).

Quelques semaines plus tard, Claude 2.1 faisait son entrée. Au menu, entre autres, une fenêtre de contexte doublée (200k) par rapport à la génération précédente. Et deux fois moins de hallucinations, nous promettait-on. En parallèle, Anthropic ajoutait, en bêta, la possibilité d'utiliser divers outils (fonctions ou API, recherche web, RAG). En parallèle, il introduisait les invites système. Et ouvrait aux développeurs une expérience de type "bac à sable" (workbench).

Début décembre, Anthropic avait publié une forme de correctif temporaire pour Claude 2.1. Cible : les traitements sur long contexte. Le modèle avait tendance à ne pas vouloir se prononcer si la réponse à une question tenait en une phrase qui ne lui semblait "pas à sa place". La solution a consisté à éditer les prompts afin que Claude cherche d'abord les phrases les plus pertinentes.

Début 2024, des protections juridiques étendues étaient entrées en vigueur sur l'API (y compris sur Amazon Bedrock). Anthropic promettait, dans les grandes lignes, d'indemniser ses clients en cas de plainte pour une infraction au copyright liée à tout usage autorisé de ses services ou des contenus produits.

Début mars, la génération Claude 3 fit ses débuts. D'abord avec les modèles Sonnet et Opus. Parmi les promesses, une amélioration des capacités d'analyse, de création de contenu nuancé et de multilinguisme - notamment en français. Ainsi que moins de refus non nécessaires...

Haiku, le plus petit modèle de la famille Claude 3, arriva quelques jours plus tard. Dans la foulée, Anthropic le rendit disponible - comme Sonnet - sur Vertex AI.

L'application iOS arriva début mai, parallèlement à l'abonnement Claude Team, articulé autour du concept de workspaces.

Le 10 mai, Anthropic annonçait avoir mis à jour sa politique d'usage. Avec, en particulier :

- Définitions plus claires des usages entrant dans la catégorie "lobbying et campagnes politiques"

- Permission d'implémenter l'API à destination d'individus mineurs à condition de respecter certaines règles de sûreté

- Exigences de mesures supplémentaires dans le cadre d'usages à haut risque (affectant des décisions d'ordre sanitaire ou juridique pouvant avoir d'importantes conséquences pour les personnes concernées)

Quelques jours après cette annonce, la version web de Claude et les apps mobiles arrivaient en Europe, complétant l'API.

Au workbench lancé en 2023 finit par se greffer un générateur de prompts mettant à contribution des techniques telles que la chaîne de pensée.

Anthropic a régulièrement entrecoupé ses annonces produits de points sur ses avancées en R&D. Il y eut, par exemple, un rapport sur la compréhension du fonctionnement interne des LLM. Plus particulièrement lorsque l'entreprise fut parvenue à mettre à l'échelle sa technique de détection de patterns d'activations. Dans ce cadre, elle mit en ligne, pour 24 heures, une démo de "Golden Gate Claude". Ce dérivé avait une feature activée en continu, de sorte qu'il parlait du Golden Gate de San Francisco dans chacune de ses réponses, même s'il n'y avait pas lieu.

Fin mai, la capacité à exploiter des outils externes était passée en disponibilité générale sur l'API Messages, Bedrock et Vertex AI. Avec la possibilité de forcer l'usage d'un outil précis... et la compatibilité avec le streaming (affichage progressif des réponses).

L'été débuta avec l'arrivée de Claude 3.5 Sonnet. Meilleur, promettait Anthropic, sur la gestion de l'humour, le raisonnement visuel (analyse de graphes) et l'écriture "naturelle".

Une fonctionnalité fit ses débuts en bêta dans le même temps, sous le nom d'Artifacts. Le principe : lorsqu'on produit certains contenus, ils apparaissent dans une fenêtre à côté de la conversation. Une interface censée favoriser l'itération.

Après les Artifacts arrivèrent les "projets", destinés à organiser les discussions sur Claude Pro et Team. Chaque projet peut avoir sa propre base de connaissances et ses instructions spécifiques.

En plus de générer des prompts dans la console, il devint possible, début juillet, de les tester et les évaluer. Soit en créant ses tests ou en les important, soit en confiant la tâche à Claude.

L'application Android fit ses début mi-juillet.

Auparavant, Anthropic avait lancé une initiative de financement axée sur les évaluations tierces de modèles. En ligne de mire, non seulement ces évaluations elles-mêmes, mais aussi des infrastructures et des outils pour les développer (plates-formes no code, modèles juges...).

Un peu plus tard, le bug bounty sur la sûreté des modèles allait s'étendre. Jusque-là porté sur les modèles au public, il venait toucher à une "nouvelle génération" du système de sûreté, encore interne à Anthropic.

La mise en cache des prompts est en bêta depuis mi-août. Elle permet de réduire la latence et d'économiser des tokens sur l'API, pour les informations auxquelles Claude doit accéder de manière répétée.

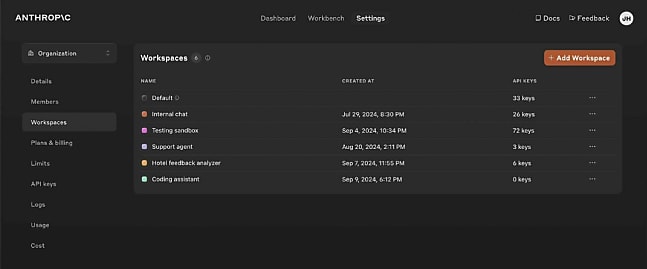

Fin août, les Artifacts sont passés en GA. Une semaine plus tard, la formule Claude for Enterprise a rejoint le catalogue (voir notre article à ce sujet). La console s'est ensuite enrichie de workspaces destinés à gérer les déploiements associés à de multiples clés d'API.

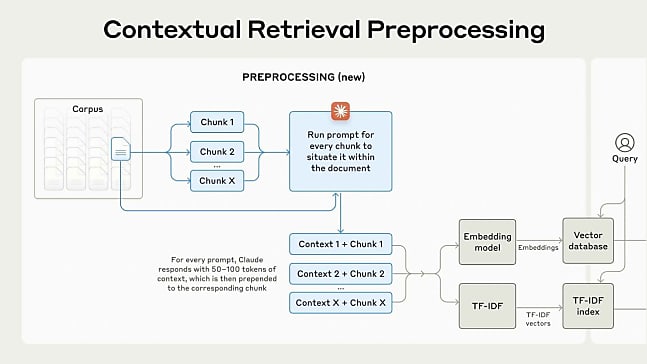

Parmi les derniers ajouts en date, il y a la récupération contextuelle. Sa promsse : éliminer l'écueil du RAG traditionnel, en ce qu'il supprime du contexte lors de l'encodage de l'information. La méthode ici proposée implique d'attacher du contexte spécifique à chaque chunk avant la vectorisation, puis la création d'un index avec l'algorithme BM25 (Best Matching 25), qui utilise la correspondance lexicale.

Illustration principale © zorandim75 - Adobe Stock

Sur le même thème

Voir tous les articles ChatGPT