Gemini, ce modèle voulu multimodal « par essence »

Google vante la multimodalité « naturelle » de Gemini. À quoi la doit-on et comment se manifeste-t-elle ?

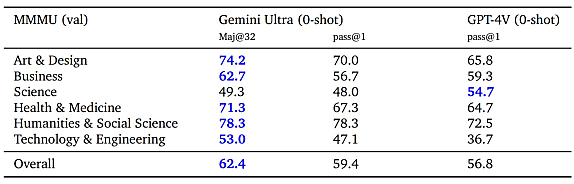

MMMU (Massive Multi-discipline Multimodal Understanding), l'idéal pour illustrer les capacités de Gemini ?

Ce benchmark, récemment présenté, contient 11 500 questions issues de manuels et d'examens de niveau secondaire. Il couvre 30 sujets sur 6 disciplines : arts & design, business, sciences, santé-médecine, humanités & sciences sociales, tech & ingénierie. On y trouve de multiples formats d'images allant des cartes aux partitions musicales en passant par des structures chimiques.

Mis à l'épreuve sur MMMU, GPT-4V(ision) a atteint une précision de 55,7 %. Les meilleurs modèles open source, autour de 34 %. D'après Google, Gemini Ultra - la plus grosse version - a réalisé un score de 62,4 %. L'équipe chargée du modèle chez DeepMind le met généreusement en avant dans son rapport.

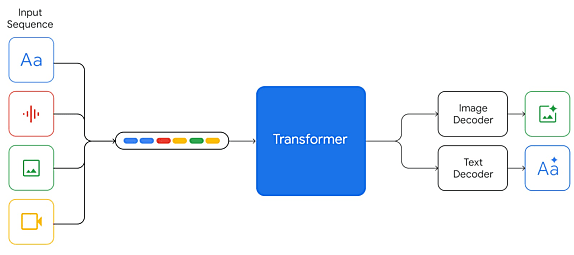

Par rapport aux travaux que Google a pu mener précédemment sur CoCa, Flamingo ou PaLI, les modèles Gemini sont multimodaux « par nature ». C'est-à-dire qu'ils peuvent traiter des séquences interlaçant texte, image et audio. Ce dernier est, en outre, traité directement, sans conversion préalable en texte, ce qui permet de ne pas perdre des nuances.

Des chiffres et des lettres

Le dataset d'entraînement contient des données « de documents web, de livres et de code ». C'est à peu près tout ce qu'en dit Google.

L'entraînement s'est fait sur des TPU v4 et v5e. On a privilégié des sauvegardes d'état en mémoire plutôt que sur du stockage persistant. Cela a amélioré les délais de reprise après interruption.

Pour ce qui est des capacités multilingues, Gemini Ultra est au niveau de GPT-4. En tout cas sur le benchmark WMT-23. Il se distingue davantage si on y ajoute la résolution de problèmes de maths (dataset MGSM, variante traduite de GSM8K).

De l'écart, il y en a aussi - toujours sur la foi des mesures de DeepMind - sur la partie codage. En 0-shot sur HumanEval (génération de code Python), Gemini dépasse GPT-4 d'environ 7 points. La différence est moins nette (1 point) sur Natural2Code, un dataset « à la HumanEval » mais dont aucun élément n'est public.

Sur la compréhension et la génération de langage, les gains en qualité sont cohérents vis-à-vis de la taille des modèles Gemini.

Gemini Pro a servi de base pour la conception d'AlphaCode 2. Se sont ensuivies plusieurs étapes de finetuning avec la méthode GOLD, puis sur une version actualisée du dataset CodeContests, avant une dernière spécialisation sur « un jeu de données plus qualitatif ».

Pour chaque problème, on génère jusqu'à 1 million d'échantillons de code, en randomisant à chaque fois la température. Pour n'en conserver que 10, on opère un premier filtrage, puis on agrège en fonction du comportement à l'exécution.

Illustration principale © ?? ?????????? - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA