GPT-4o : où, quand et pour qui ?

OpenAI orchestre un déploiement très progressif de GPT-4o, y compris de ses capacités multimodales.

GPT-4o, plus rapide que GPT-4 Turbo pour générer du texte ? OpenAI l’affirme… et plusieurs retours d’expérience le confirment.

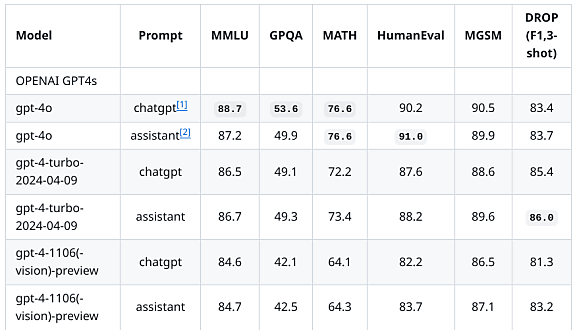

Les utilisateurs apparaissent plus partagés quant aux performances. OpenAI annonce un potentiel équivalent à celui de GPT-4 Turbo pour le texte, le raisonnement et le code. Il assure que GPT-4o est meilleur sur les langues autres que l’anglais. Mëme chose sur la vision – ce que valident des tests – et sur l’audio.

GPT-4o, un modèle bridé au lancement

Pour expérimenter cette dernière fonctionnalité, il faudra patienter. Idem pour la vidéo « temps réel » : il faut pour l’instant la scinder en séquences d’images. OpenAI estime devoir encore travailler* sur l’infrastructure, le surentraînement et la sécurité. Le délai de mise à disposition devrait se compter en mois. En attendant, un essai de ces modalités en cercle restreint (version alpha) va commencer sur ChatGPT Plus et sur l’API.

GPT-4o n’est pas disponible que sur ChatGPT Plus. Il l’est aussi sur la formule Team, le sera « bientôt » sur l’édition Enterprise… et l’est également sur la version gratuite. Au niveau de l’API, on le retrouve sur les endpoints Chat Completions, Assistants et Batch. OpenAI y donne par ailleurs accès dans son playground. Comme Microsoft au niveau de l’offre Azure OpenAI Service (sur la région cloud US).

GPT-4o, aussi sur ChatGPT Free

La base de connaissances de GPT-4o s’arrête à octobre 2023. Soit plus tôt que celle de GPT-4 Turbo (décembre 2023). La fenêtre de contexte est la même (128k ; 4k max en sortie). L’inférence coûte en revanche deux fois moins cher (5 $ par million de tokens en entrée ; 15 $ en sortie). Et les limites de débit sont plus élevées sur ChatGPT (x 5, à 10 millions de tokens par minute**) comme sur l’API (de 30k TPM et 500 RPM au niveau 1 à 5M TPM et 10k RPM au niveau 5).

GPT-4o utilise en outre une nouvelle version de l’encodeur tiktoken. Celle-ci optimise la production de texte, en particulier sur les langues orientales (il y a des exemples à – 25 % de tokens en japonais).

Sur les versions payantes de ChatGPT, les GPT utilisent encore, pour le moment, GPT-4. OpenAI prévoit d’intégrer GPT-4o « dans les prochaines semaines ».

Sur la version gratuite, épuiser le quota GPT-4o empêchera également d’utiliser les GPT. Les limites pour les fonctions de navigation, d’analyse de données et d’upload de fichiers sont séparées… mais mutualisées entre elles.

Des fonctions spécifiques pour l’analyse de données

Bien que proche de GPT-4 Turbo en termes de performances, GPT-4o est pour le moment le seul à prendre en charge les dernières capacités ajoutées à la brique Advanced Data Analysis (ex-Code Interpreter). Celle-ci permet à ChatGPT d’exécuter des opérations telles que :

– Détection et correction d’anomalies (valeurs manquantes ou hors plages, lignes en double, types de données incorrects…)

– Agrégation/intégration (sommes, moyennes, écarts-types, fusion à partir d’identifiants partagés…)

– Statistique comparative, corrélation/régression et séries temporelles

Lire aussi : Les choix d'OpenAI pour GPT-4o mini

Advanced Data Analysis peut aussi créer des tableaux et des graphiques (il exploite pandas et Matplotlib). Les diagrammes linéaires et en barres, comme les camemberts et les nuages de points, sont la plupart du temps interactifs… à condition d’utiliser GPT-4o. Il faudra aussi utiliser ce modèle pour profiter de la vue extensible (interface plein écran, le discussion passant dans un panneau latéral) et de l’importation de fichiers depuis Google Drive et OneDrive.

* Le mode voix de GPT-3.5 et GPT-4 implique des modèles distincts de reconnaissance et de synthèse vocales, intercalés avant et après le LLM. Ce dernier traitant donc une transcription, on perd des éléments tel que le ton, l’ambiance sonore et l’identification des locuteurs. Avec GPT-4o, un unique réseau de neurones traitera tous les types de contenus, a priori donc de manière plus cohérente.

** Ces limites valent pour la quantité de tokens. Pas pour le volume de messages. Au lancement, le plafond pour GPT-4o était à 80 messages par tranche de trois heures sur ChatGPT Plus. Contre 40 avec GPT-4.

Photo d’illustration © maciek905 – Adobe Stock

Sur le même thème

Voir tous les articles Data & IA

![{ Tribune Expert } - IA générative : entre promesses et [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2024/11/465144/generative-entre-promesses-realites-entreprise-L.jpg)