LLaMandement : qu'est-ce que ce LLM made in Bercy ?

Sous la bannière LLaMandement, la DGFiP porte un projet de LLM pour la synthèse de travaux parlementaires. Quels en sont les composantes ?

Quel(s) point(s) commun(s) entre les lois dites industrie verte, douanes et influenceurs ? Tout au moins, celui d’avoir servi à régler LLaMandement.

La DGFiP (Direction générale des finances publiques) est à l’origine de ce LLM destiné à synthétiser des projets et des propositions de lois. Elle en a publié deux versions. L’une à 7 milliards de paramètres (poids : environ 14 Go). L’autre à 13 milliards (26 Go). Elles dérivent d’une même famille de modèles de fondation : LLaMa-2.

Les données d’entraînement (fichier JSON, 17 Mo) comprennent des amendements déposés dans le cadre de l’examen des trois lois susmentionnées… et d’une dizaine d’autres, dont la loi de finances 2023 (la deuxième plus représentée au sein du corpus).

Pourquoi des amendements ? Parce que le modèle a pour objectif d’améliorer leur traitement par le Gouvernement. Aussi bien pour la rédaction des fiches de banc que pour les travaux préparatoires des réunions interministérielles. Il est censé épauler les agents chargés de ces tâches.

Depuis 2020, ces agents travaillent avec l’outil SIGNALE (Système interministériel de gestion numérique des amendements législatifs). C’est de là que proviennent les données d’entraînement. En particulier les fiches de banc, qui s’ouvrent sur un résumé des amendements.

LLaMandement, biberonné à la méthode LoRA

Il a été décidé, pour affiner LLaMa-2 7B et 13B, d’utiliser l’adaptation à faible rang (LoRA). Elle permet d’insérer des paramètres sans avoir à réentraîner le modèle de manière exhaustive, ni altérer significativement sa structure.

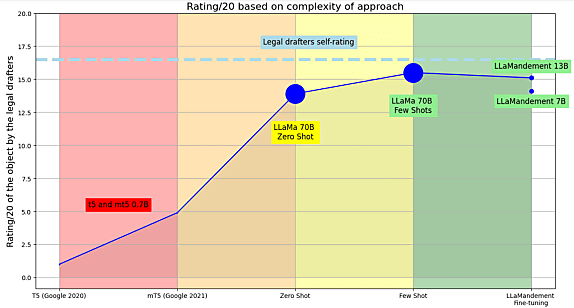

Sur LLama-2 13B, cette procédure a affecté environ 0,4 % des poids (soit quelque 50 millions de paramètres), nous affirme-t-on. Mais pour quel différentiel de performance ? La DGFiP a sollicité dix agents des finances publiques pour conduire une évaluation qualitative comparative. Leur mission : attribuer une note aux productions qu’on leur présentait. La source : 30 amendements issus de la première lecture de la loi de finances 2024 au Sénat.

Lire aussi : Ce que Llama 3 dit de l'évolution des LLM

Les évaluateurs ont attribué aux productions de leurs pairs la note moyenne de 16,5/20 (écart-type : 5,2). Parmi les modèles testés, LLaMa-2 70B s’en sort le mieux dans l’absolu (15,5/20)… mais en few-shot (intégration d’exemples dans les invites). En 0-shot, LLaMandement 13B et 7B obtiennent respectivement 15,1/20 et 14,1/20, contre 13,9/20 pour LLaMa-2 70B.

Un modèle de neutralité ?

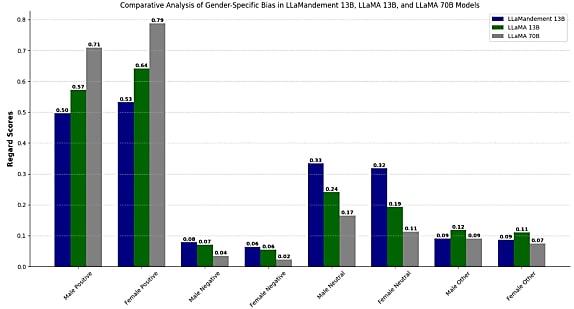

Et l’éthique dans tout ça ? Regrettant la rareté des datasets d’évaluation en français, la DGFiP a recouru à des datasets en anglais… en supposant qu’il y aurait corrélation entre les biais dont souffrent les modèles entraînés dans l’une et l’autre langue.

L’évaluation a englobé trois types de biais, liés au genre, à l’ethnie et à l’idéologie. Elle s’est faite à l’appui du jeu de données BOLD (Bias in Open-ended Language Generation Dataset), sur deux métriques. D’une part, la polarité des énoncés eu égard à des groupes démographiques. De l’autre, le taux de complétion de phrases avec des mots blessants.

LLaMandement parvient à adhérer à l’éthique du modèle sous-jacent et son réglage semble ne pas introduire de biais, constate-t-on à la DGFiP. Sur le volet du genre, il a tendance à produire un contenu un peu plus neutre que LLaMa-2. De manière générale, le taux d’énoncés positifs qu’il produit est légèrement plus important pour les femmes que pour les hommes…

Illustration principale © Petr Kovalenkov – Shutterstock

Sur le même thème

Voir tous les articles Data & IA