Évaluation des LLM : les arbitrages de Salesforce

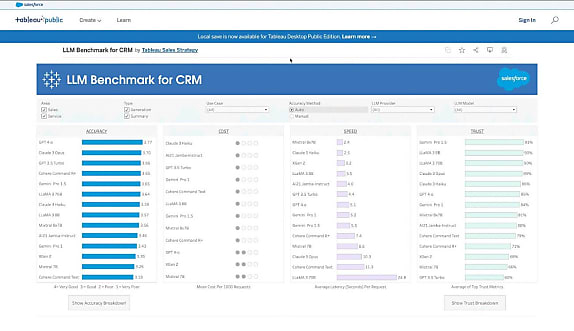

Salesforce a entrepris un benchmark des LLM sur des cas d'usage CRM. Comment l'a-t-il orchestré et qu'en ressort-il ?

Quelle taille de prompt ? Quel juge pour les évaluations automatisées ? Quelles conditions d'exécution pour les modèles non disponibles sur une API publique ? Autant de questions que Salesforce a dû aborder pour constituer son benchmark de LLM.

Ce benchmark a la particularité de cibler des cas d'usage propres aux CRM. Dans deux domaines en l'occurrence : ventes et service. Ils couvrent la synthèse et la génération de contenus textuels.

Pour le moment, Salesforce n'a évalué que des modèles génériques entraînés pour le suivi d'instructions. Ils émanent de huit fournisseurs :

- AI21 (Jamba-Instruct)

- Anthropic (Claude 3 Haiku, Claude 3 Opus)

- Cohere (Command R+, Command Text)

- Google (Gemini Pro 1.0, Gemini Pro 1.5)

- Meta (Llama 3 8B, Llama 3 70B)

- Mistral AI (Mistral 7B, Mixtral 8x7B)

- OpenAI (GPT-4o, GPT-4 Turbo, GPT-3.5 Turbo)

- Salesforce (XGen 2)

À benchmark spécifique, méthodo spécifique

Chacun de ces modèles s'est vu attribuer un score de précision. Il résulte d'une évaluation sur quatre critères : l'exhaustivité, la concision et la factualité des réponses, ainsi que la qualité de suivi des instructions en termes de contenu et de format.

Quatre critères également pour la partie « confiance et sûreté ». Plus précisément :

- Capacité à refuser de répondre à des prompts indésirables

- Respect de la vie privée (en 0-shot et 5-shot)

- Aptitude à corriger de fausses informations dans les prompts

- Résistance aux biais de genre et de compte

Le benchmark compare par ailleurs le temps de réponse des modèles, le nombre moyen de tokens dans les réponses et le coût global.

Salesforce a calculé ce dernier à partir de la tarification standard pour les modèles sur API publique (celle du fournisseur pour OpenAI, Google et AI21 ; via Bedrock pour Anthropic et Cohere). Pour les autres, autohébergés, il l'est sur un plan horaire, en supposant un niveau d'usage correspondant à un CRM en prod.

Les modèles autohébergés ont été déployés avec partitionnement sur des instances EC2 (g5.x48large pour les 7B, p4d.24xlarge pour les 70B), en utilisant le framework d'inférence DJL.

Pour tester la latence, Salesforce a pris en considération deux use cases différant sur le nombre de tokens en entrée (500 vs 3000). Ses mesures valent pour une « connexion haut débit », précise-t-il.

L'éditeur a évalué la partie confiance et sûreté sur des datasets publics... et les biais sur des données du CRM. Pour le genre, il a joué avec les noms des personnes et les pronoms. Pour les comptes, sur le nom des entreprises, remplacées par ceux de concurrents du même secteur.

Llama 70B a fait office de LLM juge pour évaluations automatiques. Salesforce justifie ce choix par le niveau de corrélation avec les évaluateurs humains.

Une longueur d'avance pour OpenAI... sur la précision

Sur les évaluations manuelles, on trouve systématiquement en tête un modèle d'OpenAI. Le plus souvent, c'est GPT-4o. Il domine le classement sur le résumé d'appels et la génération d'e-mails côté sales. Même chose, côté service, pour la création de bases de connaissance et la fourniture d'insights en direct pendant une conversation.

Toujours dans une perspective service client, la palme revient à GPT-4 Turbo pour la fourniture de recommandations de réponses en direct. Et à GPT-3.5 Turbo pour le résumé d'appels.

Derrière les modèles d'OpenAI, se distinguent :

- Les modèles Llama pour la génération d'e-mails côté commerciaux

- Mixtral 8x7B pour la création de bases de connaissances

- XGen 2 pour les insights en cours de conversation

- Claude 3 Haiku pour les recommandations de réponses en direct

Sur les évaluations automatisées, les modèles d'OpenAI ressortent souvent en tête. Claude 3 Opus a cependant l'avantage sur le résumé d'appels, autant côté sales que service client. Llama 3 70B se distingue sur la génération d'e-mails et de recommandations de réponses. Mistral 7B est rarement à son avantage. Il est même le seul à obtenir un score inférieur à 3 (sur 4 points possibles) pour les recommandations de réponses. Et à 2 sur la capacité à mettre à jour des enregistrements CRM.

Il arrive que dans une même famille, le plus petit modèle fasse mieux. Sur le résumé d'e-mails commerciaux, par exemple, Llama 3 8B dépasse Llama 3 70B. Sur le résumé d'appels, Mistral 7B dépasse Mixtral 8x7B (même si on ne peut pas comparer l'architecture de ces deux modèles).

Mistral AI intéressant sur les temps de réponse...

Sur le temps de réponse, les valeurs sont peu différenciées entre use cases.

Sur sept d'entre eux, Mixtral 8x7B mène la danse, avec une exécution en 2,44 secondes. Il devance Claude 3 Haiku (2,78), XGen (3,71), Llama 3 8B (3,76), Jamba-Instruct (4), GPT-3.5 Turbo (4,5) et GPT-4o (5,1). Llama 3 70B est bon dernier (20,1). Les use cases en question : mise à jour d'enregistrements CRM, résumé d'appels et d'e-mails (sales & service), création de bases de connaissances et résumé de conversations en direct.

Sur les quatre autres use cases (génération d'e-mails, résumé de conversations, insights et recommandations en direct), Claude 3 Haiku arrive en tête (2,2 secondes). Suivent Mixtral 8x7B (2,41), XGen (2,64), Llama 3 8B (3,23), Jamba-Instruct (4), GPT-3.5 Turbo (4,2), Gemini Pro 1 (4,4) et GPT-4o (5). Llama 3 70B est à nouveau en queue de peloton (29,4).

... et sur les coûts

On retrouve presque la même division entre use cases sur la question des coûts (seule la création de bases de connaissances change de groupe).

Sur le premier groupe, qui comprend essentiellement des tâches de synthèse, Mistral 7B est l'unique modèle à entrer dans la catégorie « bas coût ». Sept modèles entrent dans le segment « coût moyen » : Claude 3 Haiku, Gemini Pro 1, GPT-3.5 Turbo, Jamba-Instruct, Llama 3 8B, Mixtral 8x7B et XGen 2. Les coûts sont élevés pour Claude 3 Opus, Command R+ et Command Text, Gemini Pro 1.5, GPT-4o, GPT-4 Turbo et Llama 3 70B.

Sur le deuxième groupe, qui comprend essentiellement des tâches génératives, Mistral 7B n'est plus seul dans la catégorie « bas coût ». Il voisine avec Claude 3 Haiku, Gemini Pro 1, GPT-3.5 Turbo, Jamba-Instruct, Llama 3 8B et Mixtral 8x7B. En « coût moyen », il y a Command Text, Gemini Pro 1.5, Llama 3 70B et XGen 2. Les coûts restent élevés pour Claude 3 Opus, Command R+, GPT-4o et GPT-4 Turbo.

À consulter en complément :

Évaluer les LLM, un défi : le cas Hugging Face

La recette et les ingrédients des LLM codeurs Granite d'IBM

Ce qu'il faut savoir sur Moshi, l'IA vocale de Kyutai

Chez Red Hat France, la problématique VMware plus concrète que les LLM

Silo AI, point d'ancrage européen pour Mistral AI

Illustration © bestforbest - Adobe Stock

Sur le même thème

Voir tous les articles Open source

![Firefox soumis à des conditions d'utilisation : pourquoi [...]](https://cdn.edi-static.fr/image/upload/c_lfill,h_201,w_298/e_unsharp_mask:100,q_auto/f_auto/v1/Img/BREVE/2025/2/468264/firefox-soumis-conditions-utilisation-mozilla-inquiete-L.jpg)