Gemini dans Google Workspace : des annonces au galop, une diffusion au trot

À la Cloud Next '25, Google multiplie les annonces d'intégrations au stade expérimental. Leur délai d'industrialisation s'avère parfois significatif, a fortiori si on tient compte de la localisation linguistique.

La localisation linguistique, un exercice pas si facile avec les services d'IA générative ?

Voilà deux ans, à la Cloud Next '23, Google avait introduit, dans Docs et Gmail, une fonctionnalité d'assistance à l'écriture (Help me write) fondée sur Gemini - alors encore désigné sous la marque Duet AI.

Il avait fallu attendre mai 2024 pour que d'autres langues que l'anglais soient prises en charge. En l'occurrence, l'espagnol et le portugais.

Le français vient tout juste de rejoindre la liste. Fin mars sur Gmail, début avril sur Docs.

Au sein de Google Workspace, d'autres intégrations de Gemini auront connu des délais de localisation significatifs. Par exemple :

- Dans le panneau latéral de Slides (juin 2024 en anglais ; mars 2025 en français)

- Dans la visionneuse PDF de Drive (juillet 2024 - mars 2025)

- Dans Meet pour la prise de notes (août 2024 - mars 2025)

Le délai a été plus court pour, entre autres :

- L'intégration dans le panneau latéral de Chat (novembre 2024 - mars 2025)

- La création de documents enrichis dans Docs (décembre 2024 - mars 2025)

- L'intégration dans ce même panneau au sein de toutes les apps de la suite pour générer des images (novembre 2024 - janvier 2025)

- L'interaction avec l'agenda Google depuis Gmail (novembre 2024 - avril 2025)

Vers une couche d'automatisation supplémentaire dans Google Workspace

L'intégration dans Chat dépassera le panneau latéral dans les prochaines semaines. On pourra l'expérimenter dans les Labs.

En attendant, les organisations utilisatrices de Gemini dans Google Workspace et inscrites au programme alpha peuvent essayer la conception d'automatisation ("Flows") en langage naturel. Elle peut tirer parti des Gems (versions personnalisées de Gemini). L'ouverture à des applications tierces n'est pas encore effective.

Devraient bientôt s'y ajouter, dans Docs, un assistant de rédaction ("Help me refine") et une option de synthèse vocale ("Listen up") inspirée de ce que propose déjà NotebookLM. Ainsi que, dans l'appli Google Vids, la création de vidéos avec le modèle Veo 2.

Indépendamment de ses intégrations dans l'écosystème Google, Veo 2 voit ses capacités enrichies, avec inpainting (remplissage) et outpainting (extension), gestion de la composition et interpolation (choix de la première et de la dernière images).

Le modèle audio Chirp 3 accueille quant à lui la diarisation (en preview) et la possibilité de créer une voix personnalisée "avec 10 secondes de parole" (en disponibilité globale...avec accès sur demande).

La famille de LLM made in Google s'agrandit en parallèle, avec Lyria, générateur de musique. Il est en preview sur Vertex AI.

Agent2Agent : comment Google veut compléter le protocole MCP

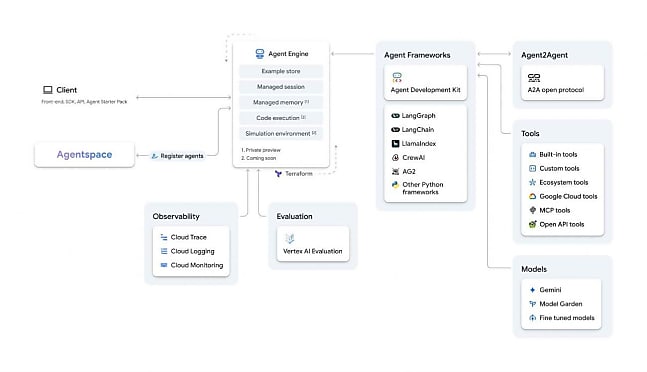

Vertex AI, justement, n'échappe pas à la vague agentique. Google annonce, en particulier, lui avoir adjoint un kit de développement d'agent (ADK) ; pour le moment en Python. Axé sur l'intégration avec l'écosystème du groupe américain, il sous-tend déjà l'offre Agentspace, centrée sur la recherche d'entreprise*. Son niveau de compatibilité avec les autres frameworks agentiques varie. Il est complet pour LangChain et LangGraph ; partiel pour AG2 et LlamaIndex (fourniture de templates managés dans le SDK) ainsi que pour CrewAI (possibilité d'adapter des templates).

Lire aussi : Gemini 2.0 : où, quand et pour qui ?

À défaut d'être un nouveau produit, Agent Engine est une nouvelle marque, qui prend le relais de Vertex AI Reasoning Engine (ou LangChain sur Vertex AI). Il s'agit toujours d'un runtime destiné au déploiement d'agents en production. Google l'inscrit dans une suite de fonctionnalités dite AI Agent Builder. Elle comprend aussi ADK, une bibliothèque d'agents (Agent Garden, en preview) et divers outils (interpréteur de code, moteur RAG, ancrage sur Google Search, connexion à Apigee...).

À cela s'ajoute une initiative de protocole de niveau applicatif dit A2A (Agent2Agent). Entrevu comme un complément à MCP, il utilise le même format de message, mais pour permettre la communication entre agents. Chacun déclarerait ses capacités et ses exigences d'authentification par l'intermédiaire d'un fichier JSON dans le dossier /.well-known.

De grands noms suivent la démarche. Qui a notamment, sur sa feuille de route, la prise en charge des registres d'agents et la négociation dynamique d'UX (enclenchement de différentes modalités de conversation pendant l'exécution d'une tâche).

* Lancé en décembre, Agentspace est en accès anticipé. Google le rend désormais accessible dans la barre de recherche de Chrome. Il y ajoute un concepteur sans code censé compléter l'approche "développeur" d'Agent Builder.

À consulter en complément :

Qu'est-ce que le protocole MCP, qui monte dans l'univers de l'IA agentique ?

De l'UX à l'AX : penser les interfaces pour les agents IA

Gemini intégré dans Google Workspace : les prix en hausse

Avec les LLM, peut-on concilier qualité et diversité des réponses ?

ChatGPT, Gemini, Perplexity... Bataille sur la "recherche en profondeur"

Illustration principale générée par IA

Sur le même thème

Voir tous les articles Workspace