NVIDIA s'affirme en boussole des IA génératives

NVIDIA structure son offre et ses partenariats dans le domaine des IA génératives. Quelle forme prend la démarche ?

NVIDIA, une pierre angulaire de l'IA générative ? On pourrait l'affirmer s'il fallait juger à l'aune des relations commerciales que l'entreprise américaine a établies. En tout, celles qu'elle a choisi de mettre en lumière lors de sa conférence GTC.

Parmi les partenaires, il y a Google Cloud. Qui est officiellement le premier CSP à dégainer - en bêta privée, cependant - des instances fondées sur le GPU L4.

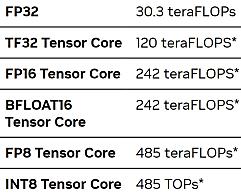

Cette carte low profile « basse consommation » (72 W) peut développer, nous annonce-t-on jusqu'à 30 Pflops en FP32 (simple précision). Soit environ trois fois moins que le modèle L40 (300 W). NVIDIA la présente comme une solution « universelle », mais il avance en premier lieu son usage en inférence avec les modèles génératifs. Les autres jonctions avec Google Cloud interviennent en deuxième rideau dans sa communication, qu'il s'agisse de l'intégration du moteur Triton avec GKE ou de la connexion de la bibliothèque Spark-RAPIDS à Dataproc.

Dans le cadre des relations avec AWS, le message porte plutôt sur les possibilité d'entraînement des modèles génératifs. En ligne de mire, les instances EC2 P5, censées être disponibles dans un horizon de quelques semaines. Elles seront les premières instances GPU du groupe américain à tirer parti de la deuxième génération du pilote EFA.

Les instances P5 reposeront sur le GPU H100. Livré depuis l'automne dernier, celui-ci propulse aussi, entre autres, des instances bare metal sur le cloud d'Oracle et une famille de VM Azure lancée la semaine passée en preview. Ainsi que des instances EC2 que teste notamment, à l'heure actuelle, Stability AI. Il est aussi, chez Meta, le socle du supercalculateur Grand Teton. Des plus « petits » fournisseurs, à l'image de Cirrascale et CoreWeave, sont aussi dans la boucle.

AI Foundations : NVIDIA prend ses marques

En matière d'IA générative, NVIDIA a, en particulier, une marque forte : AI Foundations. Elle donne accès à un bouquet de services fondés sur des grands modèles de langage (LLM). Parmi eux, il y a, en accès anticipé, BioNeMo. Il permet d'entraîner et d'exécuter - via UI web ou API - des modèles dans le domaine des sciences de la vie. Le catalogue en comprend plusieurs en source ouverte. Par exemple, AlphaFold2 (de DeepMind) et ESMFold (de Meta) pour la prédiction de la structure des protéines, DiffDock (du MIT) pour l'amarrage moléculaire ou MegaMolBART (made in NVIDIA) pour la découverte de petites molécules.

Autre service à se placer sous la bannière AI Foundations et là aussi en accès anticipé : NeMo. Il donne pour le moment accès à cinq modèles entraînés sur des données publiques. Dont trois dérivés de GPT à 8, 43 et 530 milliards de paramètres, respectivement axés sur la classification de texte, le Q&A et la composition. Pour la traduction, il y a BLOOMZ-T0, modèle communautaire.

NeMo et BioNeMo donnent chacun accès à un bac à sable et à des options de personnalisation des modèles. Il faudra encore attendre, en revanche, pour l'ouverture au public de Picasso, troisième service de la famille AI Foundations. Pour le moment, NVIDIA met l'accent sur ses travaux avec :

- Adobe pour développer des modèles génératifs dont certains seront intégrés, sous la marque Firefly, dans la Creative Suite

- Shutterstock pour exploiter sa base afin d'entraîner des modèles génératifs 3D qui trouveront place à la fois dans sa boîte à outils Creative Flow et dans l'Omniverse de NVIDIA

- Getty Images pour développer, à partir de ses actifs, des modèles auxquels on pourra accéder par API sur Picasso, avec partage des revenus

Lire aussi : NVIDIA s'affirme en fournisseur de... logiciels

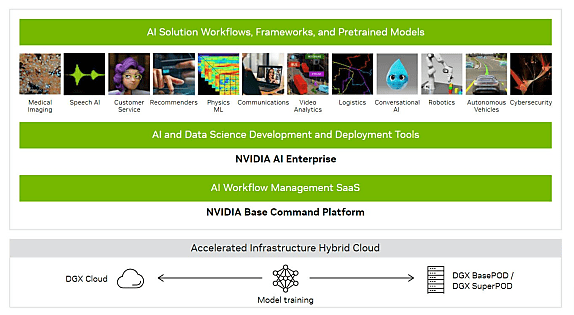

La gamme AI Foundations repose sur l'architecture DGX Cloud. Cette offre donne accès à des clusters dédiés, à partir de 37 000 $ HT/mois. Le premier à héberger officiellement des instances est Oracle. Azure devrait suivre au troisième trimestre 2023.

NVIDIA fournit une couche de gestion hybride permettant d'y associer le pilotage les ressources DGX sur site.

Illustration principale © Sundry Photography - Adobe Stock

Sur le même thème

Voir tous les articles Data & IA