Quand le Deep Learning permet aux aveugles d'écouter leur environnement

L'IA n'est pas réservée aux grands datacenters et peut être déployée dans des objets portables, comme le dispositif Horus, qui combine capteurs et algorithmes de Deep Learning pour aider les aveugles à percevoir ce qui les entoure.

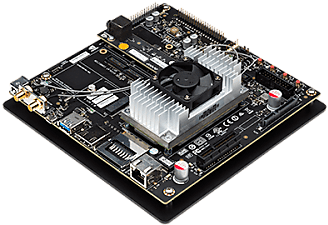

Le Deep Learning, réservé aux grands datacenters du Cloud et aux supercalculateurs ? Un a priori que le fournisseur de puces graphiques (GPU) Nvidia s'emploie à combattre. Depuis mai, la société de Santa Clara commercialise une plateforme de développement, Jetson TX1 (successeur du TK1), basée sur ses puces graphiques et permettant de développer des applications pour ce que Nvidia appelle l'informatique visuelle, l'association de capteurs permettant de balayer l'environnement (caméras, lidars.) et du Deep Learning, cet ensemble d'algorithmes d'IA amenant une machine à interpréter cet environnement.

Une association qu'on retrouve notamment dans le projet Horus, qui vise à faciliter le quotidien des aveugles. Né au sein de l'IIT (Institut italien de technologies) de Gênes, ce projet a donné naissance à une start-up de 15 personnes. Le dispositif, composé d'un boîtier et d'un casque léger supportant caméras, haut-parleurs et microphone, permet aux malvoyants et aux aveugles d'être avertis, via le son, d'éventuels obstacles dans leur environnement, mais aussi de prendre connaissance de ce dernier. « Nous avons développé un prototype avancé de notre offre, aujourd'hui testé par une poignée d'utilisateurs afin de régler le logiciel en fonction de leurs besoins réels. La production en masse démarrera en mars ou avril prochain », assure Luca Nardelli, co-fondateur et directeur technique Eyra.io, la jeune société qui pilote ce projet.

Reconnaissance de textes, d'objets, de visages

Un dispositif qui repose bien-sûr sur des capteurs, mais aussi sur l'emploi de technologies d'IA qui tournent sur le boîtier autonome, en pratique un ordinateur miniaturisé à base de puce Tegra K1

de Nvidia et embarquant des algorithmes de Deep Learning. L'utilisateur dispose de boutons pour enclencher les différentes applications supportées, qui toutes ont recours à l'IA : reconnaissance de textes, reconnaissance faciale, reconnaissance d'objets, application de mobilité pour détecter des obstacles dans l'environnement et descriptions de scènes. « Horus est capable de fonctionner indépendamment de toute connexion Internet, précise Luca Nardelli. Mais le dispositif intègre tant une connexion WiFi que Bluetooth pour des éventuelles mises à jour. Nous réfléchissons aussi à de futures intégrations avec des projets tiers, par exemple en matière de ville intelligente ». La commercialisation d'Horus devrait débuter en Italie (entre 1500 et 2000 euros), mais le directeur technique assure que le portage dans d'autres langues ne représente pas un gros effort de développement. Eyra.io dit ainsi être en contact avec des représentants d'associations spécialisées dans l'Hexagone.

Le Deep Learning gourmand en GPU

Le cas d'Horus est en tout emblématique de l'intelligence que peuvent désormais embarquer les objets. Une tendance sur laquelle entend surfer Nvidia, dont les GPU sont massivement utilisées par les applications de Deep Learning en raison de leur capacité à effectuer de multiples calculs en parallèle. Pour Serge Palaric, le vice-président ventes et marketing embarqué et OEM de Nvidia en Europe, les constructeurs de terminaux ont, à leur disposition, plusieurs options : « si on prend le cas des caméras, on en compte au moins trois. Soit on embarque toute l'intelligence dans la caméra avec, par exemple, une carte Jetson TX1 ou une puce Tegra K1, qui s'adapte bien aux formats plus contraints et ne consomme que 5 à 6 W. Soit on effectue les traitements des données au niveau de l'enregistreur vidéo, qui fédère entre 20 et 30 caméras sur le réseau de vidéosurveillance de Londres par exemple. Ou alors on centralise tout sur des serveurs. » Dans ses derniers résultats trimestriels (1,3 milliard de dollars, +13 %), le constructeur californien n'avait pas manqué de pointer le rôle d'accélérateur joué par le Deep Learning dans sa croissance. « Son adoption touche une industrie après l'autre, stimulant la demande pour nos GPU », disait ainsi au printemps dernier Jen-Hsun Huang, le Pdg.

Et ce même si le jeu vidéo continue à peser plus de 50 % de l'activité du concepteur de puces. Mais, au final, jeu et IA sont en train de faire la jonction. Comme le montrent les exemples de Google et OpenAI, l'initiative lancée par Elon Musk, qui ont tous deux donné accès à des environnements d'entraînement des IA basés. sur des jeux vidéo.

A lire aussi :

OpenAI et Google ouvrent leurs classes primaires pour l'IA

Facebook traite la vidéo en temps réel avec du deep learning

Nvidia met 5,3 téraflops DP de puissance dans un unique GPU

Sur le même thème

Voir tous les articles Workspace