Anthropic, cet « anti-OpenAI » qui veut voir les choses autrement

Il y a trois ans, des anciens d’OpenAI fondaient Anthropic. L’entreprise a aujourd’hui son LLM Claude… dont elle a cadré le développement à travers plusieurs mécanismes.

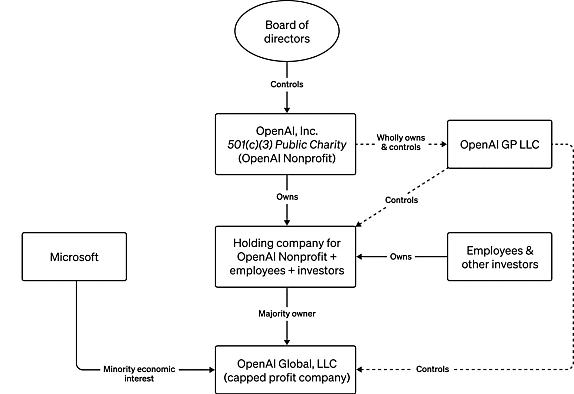

Comment concilier intérêt financier et intérêt public ? OpenAI s’est structuré dans cette logique, en plaçant, au coeur de sa gouvernance, une organisation à but non lucratif.

Celle-ci a pour mission de développer « une intelligence artificielle générale sûre et largement bénéfique pour l’humanité ». Elle contrôle l’intégralité des activités de la branche à but lucratif… et peut notamment en révoquer les dirigeants. C’est ce qui s’est passé récemment avec l’éviction – temporaire, mais retentissante – de Sam Altman.

La structuration d’Anthropic fait écho à celle d’OpenAI. Au sommet de la pyramide se trouve une PBC (Public Benefit Corporation, « entreprise d’intérêt pour la société », forme d’entreprise à mission conçue pour des entités à but lucratif).

Enregistrée dans le Delaware, elle contrôle quatre filiales « opérationnelles » : la principale créée en février 2021 en Californie, les autres constituées en août 2022 dans l’État de New York, le Massachusetts et l’État de Washington.

Le statut de PBC permet à Anthropic de poursuivre à la fois une recherche de profit et une mission définie comme « le développement et la maintenance responsables d’une IA avancée pour le bénéfice à long terme de l’humanité ». Il ne rend cependant pas les administrateurs responsables vis-à-vis des externalités – c’est-à-dire des parties prenantes autres que les actionnaires que l’activité de l’entreprise pourrait affecter. Aussi a-t-il été décidé d’y adjoindre un organisme dit LTBT (Long-Term Benefit Trust). Ses cinq membres sont « détachés des intérêts financiers d’Anthropic ».

Un organisme expérimental… et révocable par les actionnaires

Les jalons avaient été posés en 2021 à l’occasion du tour de table de série A. On parlait alors de LTBC (Long-Term Benefit Committee). Ses pouvoirs ont véritablement été consacrés en mai dernier, au moment du bouclage du tour de table de série C.

Depuis lors, une catégorie spéciale d’actions (ordinaires de classe T), réservée aux membres du LTBT, leur confèrent le droit d’élire et de révoquer des administrateurs. Ce droit se limite pour le moment à un siège. Il est censé s’étendre avec le temps et selon les financements obtenus. Dans tous les cas, il doit englober la majorité du board sous quatre ans.

De par sa nature expérimentale, cet organisme est renconfigurable sans le consentement de ses membres si une « majorité suffisante » d’actionnaires le décident, concède Anthropic. La majorité requise augmentera parallèlement à l’accroissement des pouvoirs du LTBT.

La quasi-intégralité de l’équipe fondatrice d’Anthropic travaillait auparavant chez OpenAI. À commencer par Daniela et Dario Amodei, le tandem dirigeant. L’équipe technique comprend, en nombre, des anciens de Facebook/Meta et de Microsoft. On trouve aussi, sur les CV, de l’Apple, du VMware, du Quora, du FireEye, etc.

Anthropic, : les cinq membres du Long-Term Benefit Committee

( par dans ordre alphabétique )

>> Kanika Bahl

PDG de l’OGN Evidence Action. Ancienne vice-présidente exécutif de la Clinton Health Access Initiative.

>> Paul Christiano

Fondateur de l’Alignment Research Center (organisme de recherche à but non lucratif qui se consacre à l’alignement de l’IA sur les valeurs et les priorités humaines). Ancien directeur de l’équipe « alignement des modèles » chez OpenAI.

>> Jason Gaverick Matheny

PDG du think tank RAND Corporation depuis juillet 2022. Ancien de la Banque mondiale, directeur de l’IARPA (Intelligence Advanced Research Projetcts Activity) sous l’ère Trump puis coordinateur pour la technologie au Conseil de sécurité nationale sous l’administration Biden.

>> Zach Robinson

Directeur exécutif par intérim d’Effective Ventures US (réseau d’organisations et de projets caritatifs… à laquelle le régulateur britannique s’intéresse pour son lien avec FTX). Ancien de la fondation Open Philanthropy.

>> Neil Buddy Shah

Directeur exécutif de la Clinton Health Access Initiative. Directeur général de l’organisation caritative GiveWell. Passé par la Banque mondiale.

Photos : © DR

Claude, en disponibilité encore très restreinte

Anthropic a le soutien d’Amazon, qui s’est engagé, en septembre 2023, à injecter jusqu’à 4 Md$. Quelques semaines plus tard, Google a suivi, avec l’intention de débloquer 2 Md$. Il avait déjà mis ses billes au printemps, parallèlement à Salesforce et Zoom – SAP s’y ajoutant par la suite.

Conséquence de l’investissement d’Amazon, AWS est devenu le « fournisseur cloud principal » d’Anthropic. Il héberge aujourd’hui ses modèles Claude, accessibles par l’intermédiaire du service Bedrock… à condition de pouvoir exposer préalablement un cas d’usage.

Autres moyens d’exploiter Claude : l’UI web (claude.ai), l’API… et une application Slack, disponible sur le forfait Enterprise Grid. L’accès est limité autant sur le plan géographique (toujours pas de Claude dans l’Union européenne, entre autres) que fonctionnel (l’API est en bêta privée ; l’interface de chat, en bêta publique ; l’app Slack, en version expérimentale). Il faut dire que le lancement officiel de Claude remonte à moins d’un an. C’était précisément le 14 mars 2023, au sortir d’une phase alpha ayant impliqué, en particulier, Notion (pour sa brique Notion AI), Quora (chatbot Poe) et DuckDuckGo (service DuckAssist).*

Pour cadrer Claude, Anthropic ne s’appuie pas sur des règles intégrées implicitement par feed-back humain, mais sur un ensemble de principes fixés explicitement sous la forme d’une « constitution ». Sources déclarées : la Déclaration universelle des droits de l’homme, des principes posés par des labos de recherche (dont DeepMind), les conditions d’utilisation des services Apple… et un « effort de prise en comptes de points de vue non occidentaux ». Les modèles sont d’abord entraînés à s’autocritiquer à partir de ce socle (on leur fournit, pour cela, quelques exemples). Ils subissent ensuite un renforcement à partir de cette même base.

Sur le papier, AWS a une autre exclusivité : la prise en charge de la personnalisation (finetuning) des différentes versions de Claude. Ce n’est officiellement pas possible par les canaux directs, quoique Anthropic se dit « ouvert à discuter avec les entreprises » à ce sujet.

Un LLM prudent par essence

L’entreprise ne propose pas encore, tout du moins officiellement, d’offre équivalente à ChatGPT Enterprise. Pour le moment, le catalogue comprend un forfait payant : Claude Pro, placé au même niveau de prix que ChatGPT Plus (20 $ ou 18 £/mois). Il garantit des quotas d’usage « au moins cinq fois plus importants » que sur la version gratuite*. Ainsi qu’un accès prioritaire lors des pics de charge, à l’instar de ce que promet OpenAI.

Claude maîtrise avant tout l’anglais, mais il est « particulièrement efficace » en allemand, en portugais… et en français, affirme Anthropic à l’appui, notamment, du benchmark de traduction FLORES-200. Il sait par ailleurs « coder dans les principaux langages », même s’il est meilleur en Python. Sa base de connaissances s’arrête en décembre 2022. Cela a d’autant plus d’importance qu’il ne peut accéder à Internet. On peut néanmoins lui fournir des documents (8 formats ; maximum 5 fichiers et 10 Mo/fichier).

À l’heure actuelle, Claude ne traite et ne produit que du texte. Nombre de ceux qui l’ont essayé soulignent sa retenue. Parmi les cas de refus signalés :

– Expliquer comment des élèves trichent afin de pouvoir les en empêcher

– Jouer le rôle d’un inspecteur du permis de conduire

– Fournir du vocabulaire à utiliser pour « paraître plus altruiste »

– Expliquer comment « tuer » un processus Python

– Conseiller des médicaments pour améliorer la fertilité féminine

La prudence est un trait assumé de Claude. Anthropic l’a rappelé fin novembre au lancement de la dernière version en date (2.1) : le modèle refuse plus souvent de répondre qu’en version 2.0 (environ 45 % du temps, contre 24 %). Y compris parce qu’il admet ne pas savoir. Aussi, le nombre de réponses incorrectes sur des questions complexes a baissé (d’environ 47 % à 26 %). L’assistance en ligne est dans la même veine « précautionniste ». Elle recommande de donner du temps de réflexion à Claude, de l’encourager à travailler par étapes, de vérifier qu’il a bien compris, de lui demander de reformuler, de le laisser dire qu’il ne sait pas…

Quelques clients en vitrine

Sur la performance pure, à en juger les retours, Claude se rapproche plus de GPT-3.5 qu de GPT-4. Il a tout de même pour lui une fenêtre de contexte de 200 000 tokens… sur la version payante (en usage gratuit, la taille varie selon la charge). Par ailleurs, l’accès à Internet se profile. Il est à l’expérimentation, dans le cadre d’une capacité plus large d’exploitation d’outils externes (fonctions, API, bases de données).

Au gré des évolutions du modèle, Anthropic a communiqué l’identité de quelques clients. Par exemple, Bridgewater Associates (fonds d’investissement), Jasper (création de contenu), LexisNexis (legaltech), Lonely Planet (guides de voyage), Ricoh (électronique) et Sourcegraph (gestion de code). Récemment, il a introduit, sur le modèle de Google et de Microsoft, une garantie de protection juridique. Promesse : défendre – et si nécessaire dédommager – les utilisateurs en cas de plainte pour infraction au copyright. Elle s’appliquera au 1er janvier 2024 sur l’API et au 2 janvier sur Bedrock.

En l’état, tous les serveurs d’Anthropic se trouvent aux États-Unis. Par défaut, l’entreprise n’exploite pas les données des utilisateurs pour entraîner ses modèles. La règle générale veut que ces données soient supprimées après 28 jours sur l’API et 90 jours sur les produits en phase d’expérimentation/évaluation.

* Le nombre de messages autorisés varie selon la quantité de tokens. Anthropic donne un ordre d’idée pour Claude Pro : moyennant des conversations de 200 phrases comprenant chacune 15 à 20 mots, « vous devriez pouvoir envoyer 100 messages par tranche de 8 heures, voire plus en fonction de la capacité disponible ». Sur l’API, on est limité à 5 requêtes concurrentes.

Sur le même thème

Voir tous les articles Data & IA